ソフトウェア開発の分野では、AI コーディング ツールの適用が静かな革命を引き起こしています。開発チームは AI 支援コーディングを広く使用していますが、企業の経営陣は AI ツールの使用に対する効果的な監督と制御を欠いています。これにより、AI ツールの適用とその結果として生じるセキュリティ リスクに関して、開発者と管理者の間で「いたちごっこ」が始まりました。

テクノロジーの世界では、開発者と管理者の間でいたちごっこが続いています。このゲームの主人公は、会社によって明示的に禁止されているものの、開発者によって今でも密かに使用されている AI コーディング ツールです。

クラウド セキュリティ会社 Checkmarx による新しい世界的調査によると、企業の 15% が AI コーディング ツールの使用を明示的に禁止しているにもかかわらず、ほぼすべての開発チーム (99%) が AI コーディング ツールを使用していることがわかっています。この現象は、生成 AI の使用を制御する際の課題を明らかにしています。

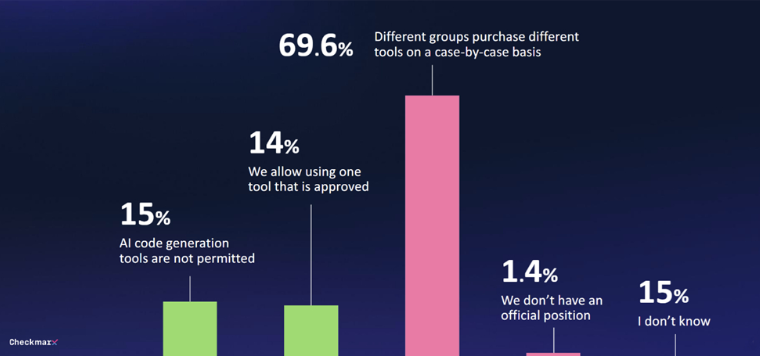

生成 AI ツールに対して何らかのガバナンスを導入している企業は 29% のみです。 70% のケースでは、統一された戦略はなく、購入の決定はさまざまな部門によってその場で行われます。この状況により、経営者が AI コーディング ツールの使用を管理することが困難になります。

AI コーディング ツールの普及に伴い、セキュリティの問題がますます顕著になってきています。回答者の 80% が、開発者が AI を使用する際にもたらす可能性のある潜在的な脅威について懸念しており、特に 60% が AI によって引き起こされる「幻覚」について懸念を表明しています。

懸念にもかかわらず、AI の可能性に対する関心は依然として強い。回答者の 47% は、AI による教師なしのコード変更を許可することに前向きです。ソフトウェア環境における AI セキュリティ対策を信頼しないと回答したのはわずか 6% でした。

「これらの世界的な CISO からの回答は、開発者が AI を使用して安全なコードを確実に作成できない場合でも、アプリケーション開発に AI を使用しているという現実を明らかにしています。つまり、セキュリティ チームは、大量の新たな脆弱なコードに対処する必要があることを意味します」とツルヤ氏は述べた。 。」

Microsoft の Work Trends Index の最近のレポートでも同様の調査結果が示されており、多くの従業員が独自の AI ツールが提供されていない場合に使用していることがわかりました。多くの場合、この使用法について議論されていないため、生成 AI をビジネス プロセスに体系的に統合することが妨げられています。

明示的な禁止にもかかわらず、開発チームの 99% は依然として AI ツールを使用してコードを生成しています。生成 AI の使用のためのガバナンス メカニズムを確立している企業は 29% のみです。ケースの 70% では、さまざまな部門による AI ツールの使用に関する決定がその場で行われます。同時に、セキュリティへの懸念も高まっています。回答者の 47% は、AI による教師なしのコード変更を許可することに前向きです。セキュリティ チームは、AI によって生成された潜在的に脆弱な大量のコードを処理するという課題に直面しています。

開発者と経営陣の間のこの「いたちごっこ」は続いており、AI コーディング ツールの将来がどのような方向に向かうのかを見守る必要があります。

AI コーディング ツールの適用はトレンドになっていますが、それがもたらすセキュリティ リスクは無視できません。企業は、この技術の波によりよく適応するために、AI によってもたらされる効率向上と潜在的なセキュリティ リスクのバランスをとる健全なガバナンス メカニズムを確立する必要があります。