Meta が Llama 3.1 をリリースした後、Mistral AI は、1,230 億のパラメーター量、128k という驚異的なコンテキスト ウィンドウ、Llama 3.1 に匹敵するパフォーマンスを備えたフラッグシップ モデル Mistral Large 2 を発売しました。このモデルは複数の言語とプログラミング言語をサポートし、単一ノード推論用に設計されており、効率的でコストに優しいです。この記事では、Mistral Large 2 のさまざまなパフォーマンス指標、使用方法、および多言語処理、コード理解、命令追従における優れたパフォーマンスを詳しく調べ、商用アプリケーションや研究分野での可能性を分析します。

昨日の最強のオープンソース モデル Llama3.1 のリリースの発表に続き、Mistral AI は今朝早くそのフラッグシップ モデル Mistral Large2 を正式に発表しました。この新製品には 1,230 億のパラメータと 128k の大きなコンテキスト ウィンドウがあるようです。 Llama3.1に相当します。

ミストラルラージ2モデル詳細

Mistral Large2 には 128k のコンテキスト ウィンドウがあり、フランス語、ドイツ語、スペイン語、イタリア語、ポルトガル語、アラビア語、ヒンディー語、ロシア語、中国語、日本語、韓国語を含む数十の言語に加え、Python、Java、C、C++、その他の言語をサポートしています。 JavaScript や Bash を含む 80 のコーディング言語。

Mistral Large2 は、ロングコンテキスト アプリケーションをターゲットとした単一ノード推論用に設計されています。その 1,230 億のパラメータ サイズにより、単一ノードで高スループットで実行できます。 Mistral Large2 は、Mistral Research License に基づいてリリースされており、研究および非営利使用を目的としています。商用の必要がある場合、ユーザーは連絡して商用ライセンスを取得する必要があります。

全体的なパフォーマンス:

パフォーマンスの面では、Mistral Large2 は評価指標の新しいベンチマークを確立し、特に MMLU ベンチマーク テストで 84.0% の精度を達成し、パフォーマンスとサービス コストの強力なバランスを示しています。

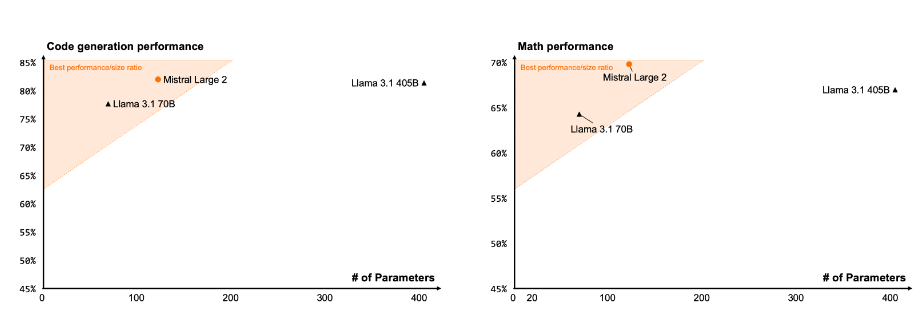

コードと推論

Codestral22B と Codestral Mamba のトレーニング経験により、Mistral Large2 はコード処理において優れたパフォーマンスを発揮し、 GPT-4o、Claude3Opus、Llama3405B などの上位モデルと比較しても遜色ありません。

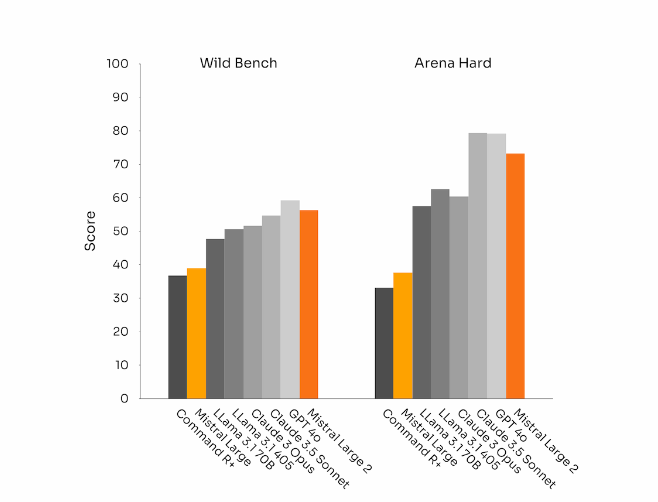

指示の遵守と調整

ミストラル ラージ 2 は、特に複雑なマルチターン対話をより柔軟に処理する場合に、コマンド追従機能と対話機能においても大幅な進歩を遂げています。一部のベンチマークでは、より長い応答を生成するとスコアが向上する傾向があります。ただし、多くの商用アプリケーションでは、シンプルさが非常に重要です。モデルの生成が短いほど、対話が高速化され、推論のコスト効率が高くなります。

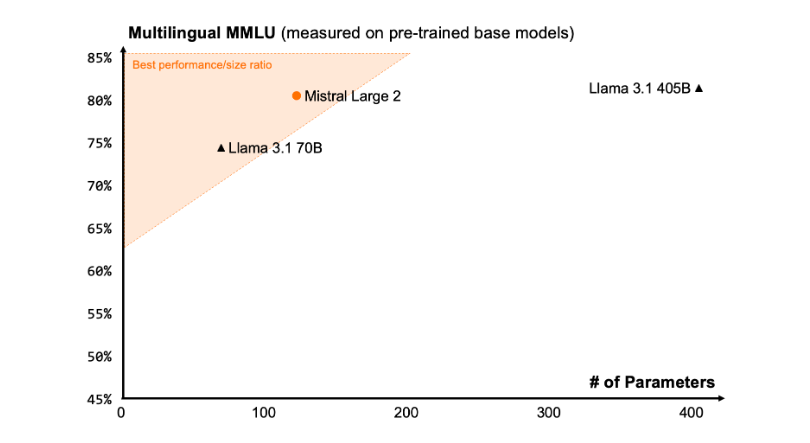

言語の多様性

新しい Mistral Large2 は、特に英語、フランス語、ドイツ語、スペイン語、イタリア語、ポルトガル語、オランダ語、ロシア語、中国語、日本語、韓国語、アラビア語、ヒンディー語の大量の多言語データでトレーニングされています。 優れたパフォーマンス。以下は、多言語 MMLU ベンチマークにおける Mistral Large2 のパフォーマンス結果を、以前の Mistral Large、Llama3.1 モデル、および Cohere の Command R+ と比較したものです。

ツールの使用法と関数呼び出し

Mistral Large2 には、強化された関数呼び出しおよび取得スキルが装備されており、並列および逐次関数呼び出しを巧みに実行するようにトレーニングされており、複雑なビジネス アプリケーションの強力な機能として機能します。

使用方法:

現在、ユーザーは、Plateforme (https://console.mistral.ai/) のようにmistral-large-2407という名前で Mistral Large2 を使用でき、le Chat でテストされています。これはバージョン 24.07 (すべてのモデルに適用される YY.MM バージョン管理システム) で、API 名mistral-large-2407で入手できます。命令モデルの重みは利用可能であり、HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407) でもホストされています。

La Plateforme の製品には、2 つのユニバーサル モデル、Mistral Nemo と Mistral Large、および 2 つのプロフェッショナル モデル、Codestral と Embed が含まれます。 La Plateforme で古いモデルを段階的に廃止しても、すべての Apache モデル (Mistral7B、Mistral8x7B および 8x22B、Codestral Mamba、Mathstral) は引き続きデプロイでき、SDK の misstral-inference および misstral-finetune を使用して微調整できます。

本日より、この製品は、Plateforme の微調整機能を拡張します。これらの機能は、Mistral Large、Mistral Nemo、および Codestral で利用できるようになりました。

また、Mistral AI は、いくつかの大手クラウド サービス プロバイダーと提携して、Mistral Large2 を世界中で、特に Google Cloud Platform 上の Vertex AI で利用できるようにしています。

** ハイライト: **

Mistral Large2 には 128k のコンテキスト ウィンドウがあり、最大 10 の言語と 80 以上のプログラミング言語をサポートします。

MMLU ベンチマークテストで 84.0% の精度を達成し、優れたパフォーマンスとコストを実現します。

?ユーザーはLa Plateformeを通じて新しいモデルにアクセスでき、クラウドサービスプラットフォームで広く使用されています。

全体として、Mistral Large 2 は、強力なパフォーマンス、広範な言語サポート、便利な使用法により、大規模言語モデルの分野で強力な競争力を実証し、研究および商用アプリケーションに新たな可能性を提供します。 また、そのオープンソースの性質により、AI 分野での革新的な開発がさらに促進されます。