Green Deep Learning の最新のオープンソース RWKV-CLIP モデルは、Transformer と RNN アーキテクチャを統合した革新的な設計により、視覚言語表現学習の分野で強力なパフォーマンスを実証しました。このモデルは、ツインタワー アーキテクチャ、空間ミキシングおよびチャネル ミキシング モジュール、多様な記述生成フレームワークを巧みに組み合わせることで、ノイズの多いデータの問題を効果的に解決し、モデルの堅牢性とダウンストリーム タスクのパフォーマンスを大幅に向上させます。画像とテキストのマッチングと理解において画期的な進歩を遂げ、視覚言語モデルの研究と応用に新たな方向性をもたらしました。

Gelingshentong は、Transformer と RNN の利点を組み合わせた視覚的言語表現学習器である RWKV-CLIP モデルをオープンソース化しました。このモデルは、画像とテキストの事前トレーニング タスクを通じて Web サイトから取得した画像とテキストのペアを使用してデータ セットを拡張することで、視覚タスクと言語タスクのパフォーマンスを大幅に向上させます。

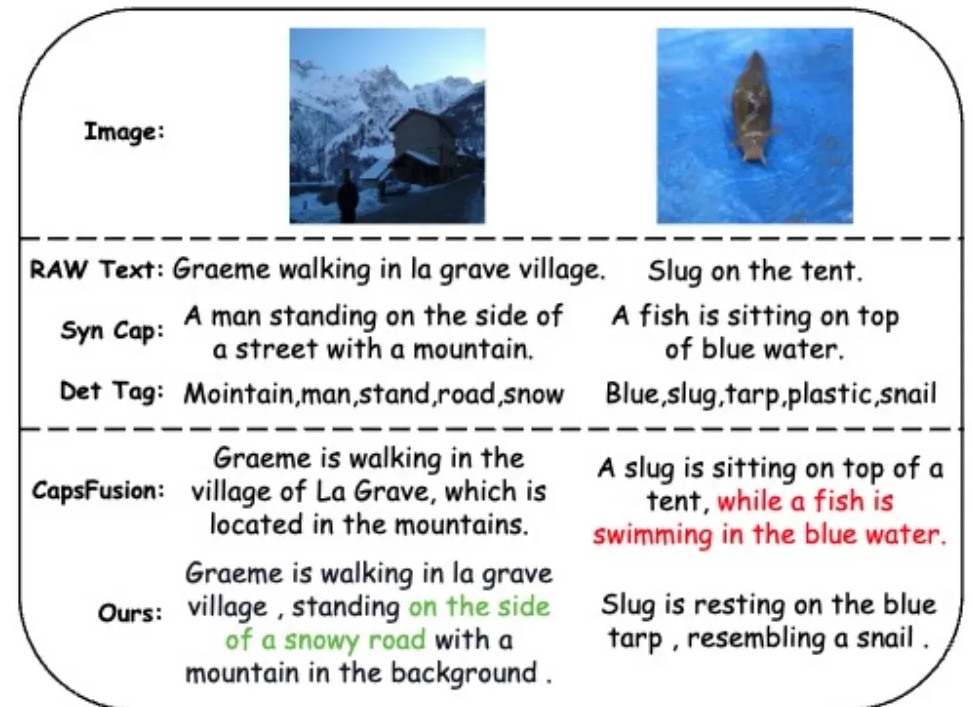

ノイズの多いデータの問題に対処し、データ品質を向上させるために、研究チームは、大規模言語モデル (LLM) を活用して、Web ベースのテキスト、合成された字幕、および検出されたタグからコンテンツを合成および洗練する、多様な記述生成フレームワークを導入しました。

RWKV-CLIP モデルはツインタワー アーキテクチャを採用し、Transformer の効果的な並列トレーニングと RNN の効率的な推論を統合します。このモデルは、複数の空間ブレンディング モジュールとチャネル ブレンディング モジュールによってスタックされており、入力画像とテキストの詳細な処理が可能になります。空間混合段階では、モデルはアテンション メカニズムを使用してグローバルな線形複雑さの計算を実行し、チャネル レベルでの特徴の相互作用を強化します。チャネル ブレンディング ステージでは、特徴表現がさらに洗練されます。入力強化の観点から、RWKV-CLIP モデルは、オリジナルのテキスト、合成字幕、または生成された説明をテキスト入力としてランダムに選択することにより、モデルの堅牢性を強化します。

実験結果は、RWKV-CLIP が線形検出、ゼロショット分類、ゼロショット画像テキスト検索などの複数の下流タスクで最先端のパフォーマンスを達成することを示しています。ベースライン モデルと比較して、RWKV-CLIP は大幅なパフォーマンスの向上を実現します。

RWKV-CLIP モデルのクロスモーダル分析では、その学習された表現が同じモダリティ内でより明確な識別性を示し、画像とテキストのモダリティ空間でより近い距離を示し、クロスモダリティの位置合わせパフォーマンスが向上していることが示されています。

モデルアドレス: https://wisemodel.cn/models/deepglint/RWKV-CLIP

全体として、RWKV-CLIP モデルは視覚言語の分野で大きな可能性を示しており、そのオープンソースは関連研究に貴重なリソースも提供します。 興味のある開発者は、提供されたリンクにアクセスしてモデルをダウンロードし、さらなる研究と応用を行うことができます。