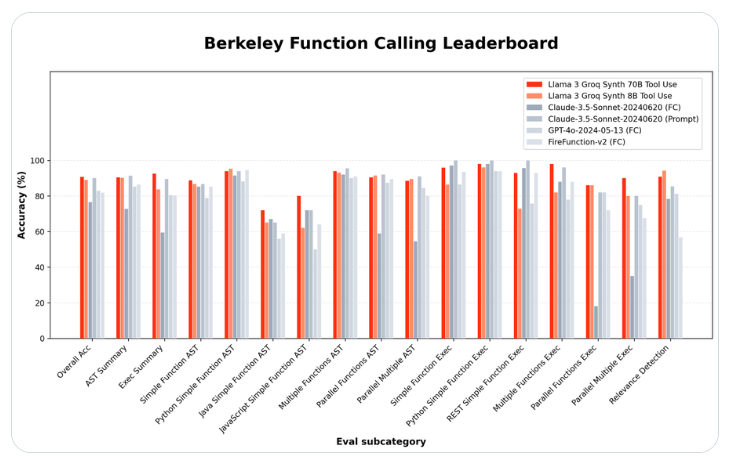

人工知能の分野における競争は熾烈を極めており、オープンソース モデルの台頭によりテクノロジー大手の優位性が挑戦されています。最近、人工知能ハードウェアのスタートアップ Groq は、2 つのオープンソース言語モデル、Llama-3-Groq-70B-Tool-Use および Llama3Groq Tool Use 8B をリリースし、Berkeley Function Call Rank (BFCL) で素晴らしい結果を達成しました。その中で、70B パラメーターはこのバージョンは、OpenAI、Google、Anthropic などの企業の独自モデルを上回りました。これらのモデルの成功は、その強力なパフォーマンスだけではなく、トレーニング プロセス中に倫理的に生成された合成データを使用することにもあります。これにより、データ プライバシーや過剰適合などの問題が効果的に解決され、この分野の持続可能な発展に新たな機会が提供されます。人工知能の例。

人工知能ハードウェアの新興企業 Groq は、特殊なツールを使用する能力においてハイテク大手を上回る 2 つのオープンソース言語モデルをリリースしました。新しい Llama-3-Groq-70B-Tool-Use モデルは、OpenAI、Google、Anthropic などの独自製品を上回り、バークレー関数呼び出しランキング (BFCL) でトップの座を獲得しました。

Groq プロジェクト リーダーの Rick Lamers は、X.com の記事で画期的な進歩を発表しました。同氏は次のように述べています。「Llama3Groq Tool Use 8B および 70B モデルを発表できることを誇りに思います。これは、独自モデルを含む他のすべてのモデルを上回り、BFCL でナンバー 1 の地位を獲得した、Llama3 のオープンソース ツールの完全に微調整されたバージョンです。クロード・ソネット3.5、GPT-4Turbo、GPT-4o、Gemini1.5Proなど。

合成データと倫理的 AI: モデル トレーニングの新しいパラダイム

大きい 70B パラメータ バージョンは BFCL で全体の精度 90.76% を達成しましたが、小さい 8B モデルは 89.06% のスコアを獲得し、全体で 3 位にランクされました。これらの結果は、オープンソース モデルが、特定のタスクに関してはクローズド ソースの代替パフォーマンスと同等かそれを超える可能性があることを示しています。

Groq は、人工知能研究会社 Glaive と提携して、Meta の Llama-3 ベース モデルに完全な微調整と直接優先最適化 (DPO) を使用してモデルを開発しました。チームは、倫理的に生成された合成データのみをトレーニングに使用し、データのプライバシーと過剰適合に関する一般的な懸念に対処していることを強調しています。

これらのモデルは、Groq API および Hugging Face プラットフォームを通じて利用できるようになりました。このアクセシビリティにより、自動コーディング、データ分析、対話型 AI アシスタントなど、複雑なツールの使用や関数呼び出しが必要な分野でのイノベーションを加速できます。

Groq はまた、Hugging Face Spaces の公開デモを開始し、ユーザーがモデルを操作してそのツール機能を直接テストできるようにしました。 Hugging Face が 2021 年 12 月に買収した Gradio と同様、Hugging Face Spaces のデモの多くはこの方法で作成されています。 AI コミュニティは熱心に反応し、多くの研究者や開発者がこれらのモデルの機能を探索することに熱心でした。

ハイライト:

⭐ Groq がリリースしたオープンソース AI モデルは、特定のタスクにおいてテクノロジー巨人の独自モデルを上回るパフォーマンスを発揮

⭐ Groq は、トレーニングに合成データを使用することで、AI モデル開発における一般的なデータ プライバシーと過剰適合の問題に挑戦します

⭐ オープンソースモデルの立ち上げは、AI分野の開発経路を変え、より広範なAIへのアクセシビリティと革新的なエコシステムの育成を促進する可能性があります

Groq オープンソース モデルの成功は、人工知能分野の発展に新たな活力を注入し、オープンソース モデルが将来的にますます重要な役割を果たすことを示しています。合成データのアプリケーションは、データ プライバシーやモデルのバイアスなどの問題を解決する上で新しいアイデアを提供しており、業界による詳細な研究と参照に値します。将来的には、人工知能技術の継続的な進歩を促進するために、より優れたオープンソースモデルが登場することを期待しています。