近年、大規模言語モデル (LLM) は自然言語処理の分野で大きな進歩を遂げていますが、そのトークンレベルの処理方法では、コンテキストの理解や、多言語およびマルチモーダルなアプリケーションにおいて限界があります。 Meta AI は、既存の LLM の欠点を解決することを目的として、この目的のためにまったく新しい手法であるラージ コンセプト モデル (LCM) を提案します。高次元埋め込み空間 SONAR でモデリングすることにより、LCM は複数の言語とモダリティをサポートし、階層アーキテクチャを採用して長いコンテンツの一貫性とローカル編集機能を向上させ、モデルの効率と一般化機能を大幅に向上させます。

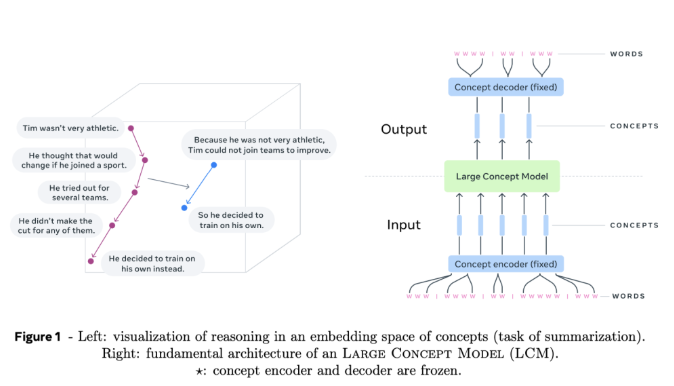

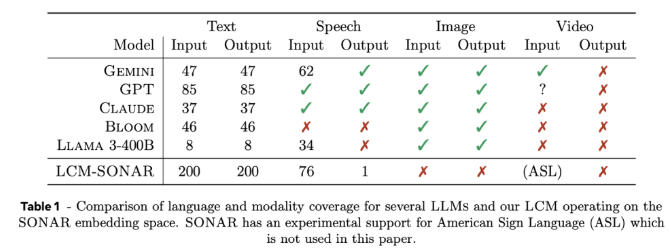

大規模コンセプト モデル (LCM) は、従来の LLM アーキテクチャからの重要な変化を表しています。彼らは 2 つの主要な革新を導入しています。まず、LCM は個別のトークンに依存するのではなく、高次元の埋め込み空間でモデル化します。 SONAR と呼ばれるこの埋め込みスペースは、200 以上の言語と、テキストや音声を含む複数のモダリティをサポートするように設計されており、言語やモダリティに依存しない処理機能を提供します。第 2 に、LCM の設計により、セマンティック レベルでのシームレスな移行が可能になり、さまざまな言語やモダリティにわたる強力なゼロショット汎化機能が可能になります。

LCM の中核には、コンセプト エンコーダとデコーダがあります。これらは、入力文を SONAR の埋め込み空間にマッピングし、埋め込みを自然言語またはその他のモダリティにデコードするコンポーネントです。これらのコンポーネントの凍結された設計によりモジュール性が保証され、モデル全体を再トレーニングすることなく新しい言語やモダリティを簡単に拡張できます。

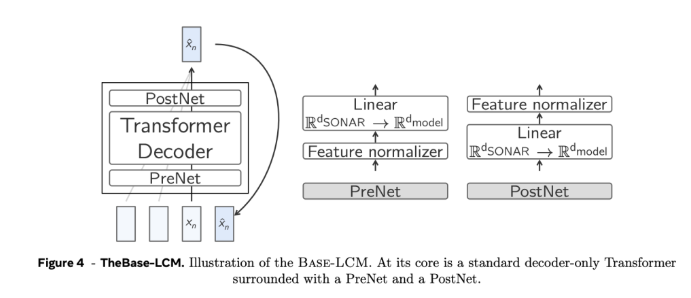

技術的な詳細に関しては、LCM は人間の推論プロセスを模倣する階層アーキテクチャを採用しており、それにより、全体的なコンテキストを乱すことなくローカル編集を可能にしながら、長い形式のコンテンツの一貫性が向上します。 LCM は、前の埋め込みに基づいて次の SONAR 埋め込みを予測する拡散モデルを採用することで、生成プロセスに優れています。実験では、シングルタワーとデュアルタワーの 2 つのアーキテクチャが使用され、デュアルタワー アーキテクチャではコンテキストのエンコードとノイズ除去が別々に処理されるため、効率が向上しました。

実験結果は、拡散ベースの 2 タワー LCM が複数のタスクで競争力を発揮することを示しています。たとえば、多言語要約タスクでは、LCM はゼロショットのケースでベースライン モデルを上回り、その適応性を示しています。同時に、LCM は短いシーケンスを処理する際にも高い効率と精度を示し、これは関連するメトリックの大幅な改善によって確認されます。

Meta AI の大規模な概念モデルは、従来のトークンレベルの言語モデルに代わる有望な代替手段を提供し、高次元の概念の埋め込みとモダリティに依存しない処理を通じて既存の手法の主要な制限の一部を解決します。このアーキテクチャの研究が深まるにつれて、LCM は言語モデルの機能を再定義し、AI 主導のコミュニケーションによりスケーラブルで適応性のあるアプローチを提供することが期待されています。

プロジェクトの入り口: https://github.com/facebookresearch/large_concept_model

全体として、Meta AI が提案する LCM モデルは、従来の LLM の限界を解決する革新的なソリューションを提供します。その利点は、多言語、マルチモーダル処理と効率的なアーキテクチャ設計にあり、自然言語の分野で大きな将来性をもたらします。処理には大きな可能性があり、継続的な注目と詳細な研究が必要です。