Google は第 6 世代 TPU、Trillium を正式にリリースし、Google Cloud の顧客に公開しました。 Trillium は Google のこれまでで最も強力な TPU であり、最も強力な AI モデルである Gemini 2.0 のトレーニングに使用されています。トレーニングのパフォーマンス、推論のスループット、エネルギー効率を大幅に向上させながら、コストの削減を実現します。 この記事では、Trillium TPU のパフォーマンスの向上、主な機能、さまざまな AI ワークロードにおける優れたパフォーマンスを詳しく説明し、AI21Labs などの顧客における実際のアプリケーション ケースを示します。

今年の初めに、Google は第 6 世代でこれまでで最も強力な TPU である Trillium をリリースしました。本日、Trillium が Google Cloud のお客様に正式に利用可能になりました。

Google は、Trillium TPU を使用して、Google のこれまでで最も強力な AI モデルである最新の Gemini2.0 をトレーニングしました。現在、企業も新興企業も同様に、堅牢かつ効率的で持続可能なインフラストラクチャを利用できるようになりました。

AIスーパーコンピューターの中核:Trillium TPU

Trillium TPU は、Google Cloud AI ハイパーコンピューターの重要なコンポーネントです。 AI ハイパーコンピューターは、パフォーマンスが最適化されたハードウェア、オープン ソフトウェア、最先端の ML フレームワーク、および柔軟な消費モデル統合システムを活用する画期的なスーパーコンピューター アーキテクチャです。 Trillium TPU の正式リリースに伴い、Google は AI トレーニングで最高の価格/パフォーマンスを達成するために、XLA コンパイラーや JAX、PyTorch、TensorFlow などの一般的なフレームワークの最適化など、AI ハイパーコンピューターのオープン ソフトウェア レイヤーに重要な機能強化も行いました。 、チューニングとサービス。

さらに、大容量ホスト DRAM (補助高帯域幅メモリ、つまり HBM) を使用したホスト オフロードなどの機能により、より高いレベルの効率が実現します。 AI ハイパーコンピューターを使用すると、13 ペタビット/秒の双方向帯域幅と、単一の分散トレーニング ジョブを数十万のアクセラレータに拡張する機能を備えた、Jupiter ネットワーク アーキテクチャごとに 100,000 個を超える Trillium チップという前例のない展開から最大の価値を引き出すことができます。

AI21Labs のような顧客は、すでに Trillium を使用して有意義な AI ソリューションを顧客に迅速に提供しています。

AI21Labs の CTO である Barak Lenz 氏は次のように述べています。「AI21 では、TPU v4 の長期ユーザーとして、Google Cloud の Trillium の機能に感銘を受けています。規模、スピード、コストにおいて、効率の向上は顕著であり、Trillium は次世代の複雑な言語モデルの開発を加速する上で重要な役割を果たし、より強力でアクセスしやすい AI ソリューションをお客様に提供できると信じています。」

Trillium のパフォーマンスは大幅に向上し、多くの指標が新記録を樹立しました。

前世代と比較して、Trillium は次の点で大幅な改善を加えました。

トレーニングパフォーマンスが4倍以上向上

推論スループットが 3 倍向上

エネルギー効率が 67% 向上

チップあたりのピーク コンピューティング パフォーマンスが 4.7 倍向上

高帯域幅メモリ (HBM) により容量が 2 倍に

チップ間相互接続 (ICI) により帯域幅が 2 倍に

単一の Jupiter ネットワーク アーキテクチャには 100,000 個の Trillium チップが含まれています

1 ドルあたりのトレーニング パフォーマンスが 2.5 倍、1 ドルあたりの推論パフォーマンスが 1.4 倍向上

これらの機能強化により、Trillium は次のようなさまざまな AI ワークロードで良好なパフォーマンスを発揮できるようになります。

AI トレーニングのワークロードのスケーリング

高密度モデルや混合エキスパート (MoE) モデルを含む LLM のトレーニング

推論パフォーマンスと一括スケジューリング

高密度モデルの埋め込み

費用対効果の高いトレーニングと推論を提供する

Trillium はさまざまなワークロードでどのようにパフォーマンスを発揮しますか?

AI トレーニングのワークロードのスケーリング

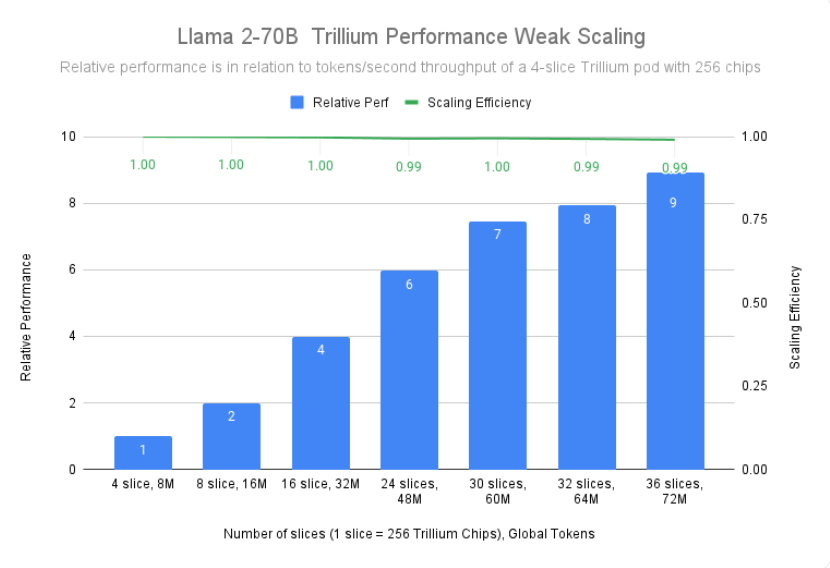

Gemini2.0 のような大規模なモデルをトレーニングするには、大量のデータと計算が必要です。 Trillium のほぼ線形なスケーラビリティにより、256 チップ ポッドの高速チップ間相互接続と最先端の機能を介して接続された複数の Trillium ホスト全体にワークロードを効果的かつ効率的に分散することで、これらのモデルを大幅に高速にトレーニングできます。ジュピターのデータセンターネットワーク。これは、大規模トレーニング向けの TPU マルチチップ、フルスタック テクノロジーによって実現され、ホスト アダプターからネットワーク アーキテクチャに至るまでの動的なデータセンター レベルのオフロード システムである Titanium によってさらに最適化されています。

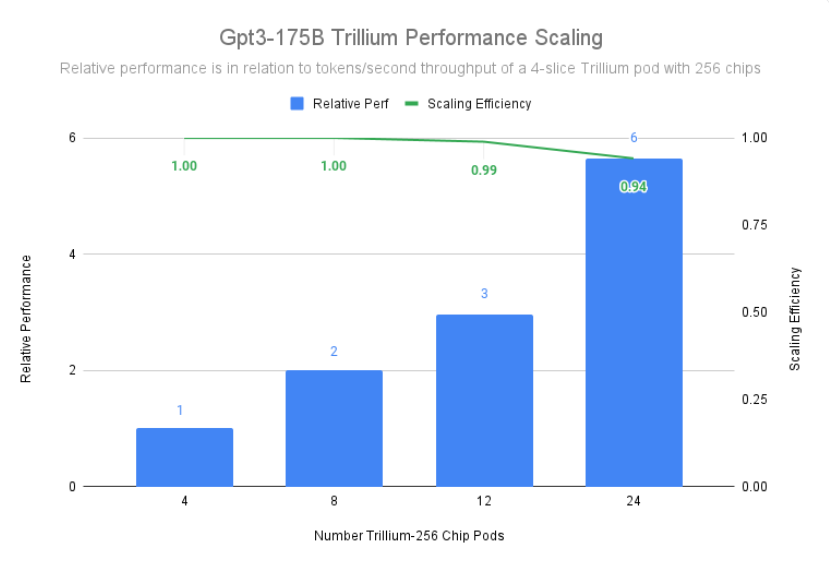

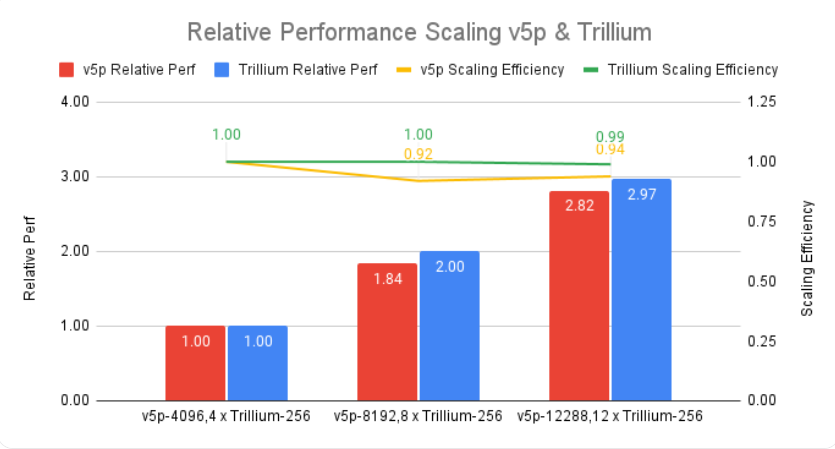

Trillium は、3072 チップを搭載した 12 ポッドのデプロイメントで 99% のスケーリング効率を達成し、gpt3-175b を事前トレーニングするために 6144 チップを搭載した 24 ポッドで 94% のスケーリング効率を実証しました。データセンター ネットワーク全体で実行する場合でも同じことが当てはまります。

高密度モデルや混合エキスパート (MoE) モデルを含む LLM のトレーニング

Gemini のような LLM は本質的に強力かつ複雑であり、数十億のパラメーターがあります。このような集中的な LLM のトレーニングには、膨大なコンピューティング能力と、共同設計されたソフトウェアの最適化が必要です。 Trillium は、Llama-2-70b や gpt3-175b などの集中的な LLM をトレーニングする場合、前世代の Cloud TPU v5e よりも 4 倍高速です。

集中的な LLM に加えて、ますます人気が高まっているアプローチは、AI タスクのさまざまな側面に特化した複数の「エキスパート」ニューラル ネットワークを組み合わせた混合エキスパート (MoE) アーキテクチャを使用して LLM をトレーニングすることです。トレーニング中にこれらの専門家を管理および調整することは、単一のモノリシック モデルをトレーニングする場合と比べて複雑さが増します。 Trillium は、MoE モデルをトレーニングする際に、前世代の Cloud TPU v5e よりも 3.8 倍高速です。

さらに、Trillium TPU は、Cloud TPU v5e と比較して 3 倍のホスト ダイナミック ランダム アクセス メモリ (DRAM) を提供します。これにより、一部の計算がホストにオフロードされ、大規模なパフォーマンスと良好なスループットが最大化されます。 Trillium のホスト オフロード機能により、Llama-3.1-405B モデルをトレーニングする際のモデル FLOP 使用率 (MFU) のパフォーマンスが 50% 以上向上します。

推論パフォーマンスと一括スケジューリング

マルチステップ推論の重要性が高まっているため、増加する計算需要を効率的に処理できるアクセラレータが必要です。 Trillium は推論ワークロードに大幅な進歩をもたらし、AI モデルのより迅速かつ効率的な導入を可能にします。実際、Trillium は画像拡散と高密度 LLM に対して最高の TPU 推論パフォーマンスを提供します。私たちのテストでは、Stable Diffusion XL は Cloud TPU v5e と比較して相対推論スループット (1 秒あたりの画像数) が 3 倍以上高いのに対し、Llama2-70B はほぼ 2 倍であることが示されています。

Trillium は、オフラインおよびサーバー推論のユースケースにおいて最もパフォーマンスの高い TPU です。以下の図は、Cloud TPU v5e と比較して、Stable Diffusion XL のオフライン推論の相対スループット (1 秒あたりの画像数) が 3.1 倍、サーバー推論の相対スループットが 2.9 倍高いことを示しています。

Trillium では、パフォーマンスの向上に加えて、新しい集合スケジューリング機能も導入されています。この機能により、Google のスケジューリング システムは、コレクション内に複数のレプリカが存在する場合に、推論ワークロードの全体的な可用性と効率を向上させるインテリジェントなジョブ スケジューリング決定を行うことができます。これは、Google Kubernetes Engine (GKE) を含む、単一ホストまたは複数ホストの推論ワークロードを実行する複数の TPU スライスを管理する方法を提供します。これらの部分をコレクションにグループ化すると、需要に合わせてレプリカの数を簡単に調整できます。

高密度モデルの埋め込み

第 3 世代の SparseCore を追加することで、Trillium は埋め込み集約型モデルのパフォーマンスを 2 倍、DLRM DCNv2 のパフォーマンスを 5 倍向上させます。

SparseCore は、組み込み集中型のワークロードに対して、より適応性の高いアーキテクチャ基盤を提供するデータ フロー プロセッサです。 Trillium の第 3 世代 SparseCore は、スキャッター コレクション、スパース セグメントの合計、パーティショニングなどの動的操作やデータ関連操作の高速化に優れています。

費用対効果の高いトレーニングと推論を提供する

Trillium は、世界最大級の AI ワークロードのトレーニングに必要な優れたパフォーマンスと規模に加えて、1 ドルあたりのパフォーマンスを最適化するように設計されています。現在まで、Trillium は、Llama2-70b や Llama3.1-405b などの集中的な LLM をトレーニングする場合、1 ドルあたり Cloud TPU v5e の 2.1 倍、Cloud TPU v5p の 2.5 倍のパフォーマンスを達成しています。

Trillium は、大規模なモデルを並行してコスト効率よく処理することに優れています。研究者や開発者が以前よりもはるかに低いコストで強力で効率的な画像モデルを提供できるように設計されています。 Trillium で 1,000 枚の画像を生成するコストは、オフライン推論の場合は Cloud TPU v5e より 27% 低く、SDXL でのサーバー推論の場合は Cloud TPU v5e より 22% 低くなります。

AI イノベーションを次のレベルへ

Trillium は、Google Cloud AI インフラストラクチャの大きな進歩を表し、さまざまな AI ワークロードに驚異的なパフォーマンス、スケーラビリティ、効率性を提供します。 Trillium は、世界クラスの共同設計ソフトウェアを使用して数十万のチップに拡張できる機能を備えているため、より迅速なブレークスルーを実現し、優れた AI ソリューションを提供できます。さらに、Trillium は優れた価格/パフォーマンスを備えているため、AI への投資の価値を最大化したいと考えている組織にとって、コスト効率の高い選択肢となります。 AI の状況が進化し続ける中、Trillium は、企業が AI の可能性を最大限に引き出すことを支援する最先端のインフラストラクチャを提供するという Google Cloud の取り組みを実証しています。

公式紹介: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

全体として、Trillium TPU の登場は、クラウド AI コンピューティング機能の大幅な向上を意味し、その強力なパフォーマンス、拡張性、経済的利点により、AI 分野の開発が促進され、企業や研究機関により強力な AI ソリューションが提供されます。