OpenAI は、ChatGPT の高度な音声モードが視覚化され、Plus、Team、または Pro に加入しているユーザーは、携帯電話のカメラを通じてリアルタイムで ChatGPT と対話し、画面共有機能を利用できるようになったと発表しました。この機能はこれまで何度も延期され、長期間のテストを経てようやく正式にリリースされたが、一部の地域やユーザータイプではすぐに利用できるわけではなく、来年1月まで待たなければならない場合もある。

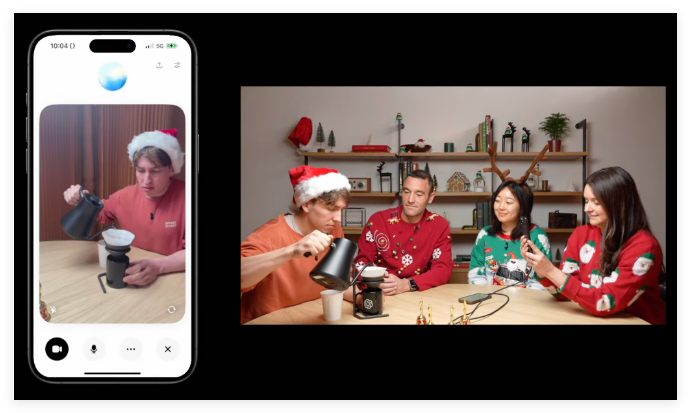

OpenAIは木曜日、ChatGPT向けに開発した人間のような会話機能「Advanced Speech Mode」を可視化したと発表した。 ChatGPT Plus、Team、または Pro に加入しているユーザーは、携帯電話のカメラをオブジェクトに向けることができるようになり、ChatGPT はほぼリアルタイムで応答します。

ビジョン機能を備えたこの高度な音声モードには、デバイス画面上のコンテンツを分析する画面共有機能も備えています。たとえば、さまざまな設定メニューの説明や数学の問題のアドバイスを提供できます。

使用方法は非常に簡単です。ChatGPT チャット バーの横にある音声アイコンをクリックし、左下隅にあるビデオ アイコンをクリックしてビデオを開始します。画面を共有したい場合は、三点メニューをクリックして「画面を共有」を選択します。

機能の展開に関して、OpenAI は、ビジョンを備えた高度な音声モードが今週木曜日から展開され、来週終了する予定であると述べました。これはすべてのユーザーがすぐに利用できるわけではないことに注意することが重要です。 ChatGPT EnterpriseとEduのユーザーは来年1月まで待たなければならないが、EU、スイス、アイスランド、ノルウェー、リヒテンシュタインのユーザーはまだ具体的なスケジュールを発表していない。

最近 CNN の「60 Minutes」に出演した際、OpenAI の社長であるグレッグ ブロックマンは、アンダーソン クーパーに対して音声パターンの高度な視覚分析機能をデモンストレーションしました。クーパー氏が黒板に人体の一部を描くと、ChatGPT は彼の絵を理解し、コメントすることができました。たとえば、脳が正確に配置されていると述べ、脳の形状が楕円に近いことを示唆しています。

ただし、デモンストレーション中に、この高度な音声モードでは幾何学的な問題に関するいくつかの不正確さも明らかになり、「幻覚」の潜在的なリスクが示されました。

ビジュアル機能を備えたこの高度な音声モードは、何度も延期されてきたことに言及する価値があります。 OpenAIは4月に「数週間以内」にサービスを開始すると約束していたが、その後、さらに時間がかかると述べた。この機能は、今秋初めまで一部の ChatGPT ユーザーが利用できず、その時点では視覚分析機能はまだ利用できませんでした。

人工知能における競争が激化する中、GoogleやMetaなどのライバルも同様の機能を開発している。今週、Googleはリアルタイムビデオ分析会話型人工知能プロジェクト「Project Astra」を一部のAndroidテスターに公開した。

ビジュアル機能に加えて、OpenAI は木曜日にお祭り気分の「サンタ モード」も開始しました。これにより、ユーザーは ChatGPT アプリの通知バーの横にあるスノーフレーク アイコンを通じてサンタの声を有効にすることができます。

ChatGPT の高度な音声モードのこの視覚的なアップデートは、現実世界と対話する AI の能力の向上を示していますが、同時に技術開発における課題と限界も明らかにしています。今後も同様の機能の向上と普及が期待され、AI技術の進歩は私たちの生活に影響を与え続けます。