汎用人工知能 (AGI) の抽象化と推論能力を評価するために設計されたベンチマークである ARC-AGI は、最近進歩を遂げていますが、その作成者であるフランソワ ショレ氏は、これは AGI が近づいていることを意味するものではないと私たちに思い出させてくれます。同氏は、ARC-AGIテストにおける現在のAIシステムのパフォーマンスは依然として予想をはるかに下回っており、その主な理由は真の推論よりもパターン認識の方が優れている大規模言語モデル(LLM)の限界にあると指摘した。 Sholay 氏とその共同研究者らは、ARC-AGI におけるオープンソース AI の画期的な進歩を促進するために 100 万ドルのコンテストを立ち上げましたが、その結果はテスト自体に欠陥がある可能性があり、さらなる改善が必要であることも確認しました。

2019 年の発表以来、ARC-AGI は人工知能の分野で注目を集めています。 AI システムはテストである程度の進歩を遂げましたが、そのスコアは依然として人間のレベルを大幅に下回っていました。これは、AI 開発の現在の方向性を考えるきっかけとなり、研究者は AGI の定義と評価方法を再検討するようになりました。この記事では、ARC-AGI テストの限界と将来の AGI 研究の方向性の見通しを詳細に分析し、関連する競争結果と研究者の対処戦略を示します。

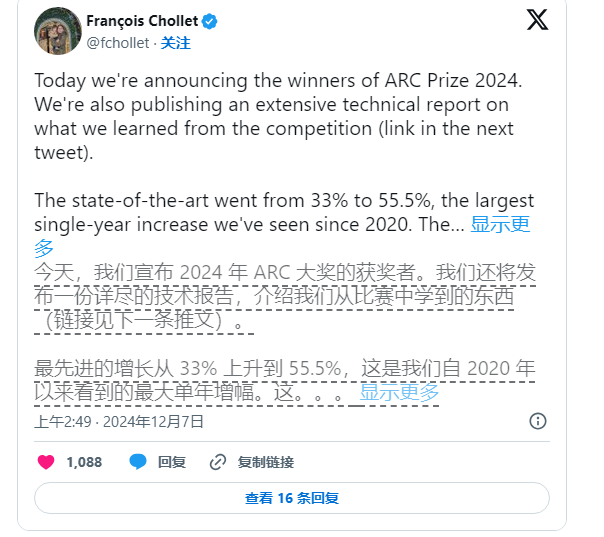

それでも、ショーレイ氏はAI研究の推進をやめていない。同氏とZapier創設者のマイク・ヌープ氏は共同で、オープンソースAIがARC-AGIベンチマークに挑戦することを奨励するため、今年6月に100万ドルのコンテストを共同で立ち上げた。最もパフォーマンスの高い AI システムのスコアは 17,789 件のエントリーのうち 55.5% に過ぎず、「人間のパフォーマンス」を達成するために必要な 85% の基準を下回っていましたが、それでも Sholay 氏と Knoop 氏はこれが重要な一歩であると考えています。

Knoop 氏はブログ投稿で、この成果は AGI の実現に近づいたことを意味するものではなく、ARC-AGI の一部のタスクが「強引な」ソリューションに過度に依存しており、真の一般向けに効果的な信号を提供できない可能性があることを強調しています。知能。 ARC-AGI は元々、これまでに見たことのない複雑なタスクを提供することで AI の汎化能力をテストするために設計されました。しかし、これらのタスクが AGI を効果的に評価できるかどうかには依然として疑問があります。

画像出典注:画像はAIによって生成され、画像はサービスプロバイダーMidjourneyによって許可されています

ARC-AGI ベンチマークのタスクにはパズル問題などが含まれており、既知の情報に基づいて AI が未知の答えを推測する必要があります。これらのタスクは新しい状況への AI の適応を促進するように見えますが、結果は、既存のモデルが大量の計算を通じて解決策を見つけているように見え、必ずしも真のインテリジェントな適応性を実証していないことを示しています。

さらに、ARC-AGI の作成者は、特に AGI の定義をめぐる曖昧さに関して、同僚からの批判に直面しています。 OpenAI の従業員は最近、AGI が「ほとんどのタスクでほとんどの人間よりも優れたパフォーマンスを発揮する」人工知能として定義されるのであれば、AGI は実際に達成されていると述べました。しかし、Cholet 氏と Knoop 氏は、ARC-AGI ベンチマークの既存の設計ではまだこの目標を完全には達成していないと主張しています。

今後、Sholay と Knoop は第 2 世代の ARC-AGI ベンチマークをリリースする予定であり、現在のテストの欠点に対処するために 2025 年に新しいコンテストを開催する予定です。新しいベンチマークは、AI研究の発展をより重要な方向に促進し、AGIの実装を加速することに重点を置くと彼らは述べた。

ただし、既存のベンチマークを修正するのは簡単な作業ではありません。 Sholay 氏と Knoop 氏の取り組みは、人工知能、特に一般知能の分野における知能の定義が依然として難しく複雑な課題であることを示しています。

全体として、ARC-AGI ベンチマークと関連する議論の進歩は、人工知能の分野における一般的な人工知能の探求が依然として進行中であり、将来的にはより厳密な定義とより効果的な評価が行われることを反映しています。 AGI の本格的な開発を促進する必要があります。