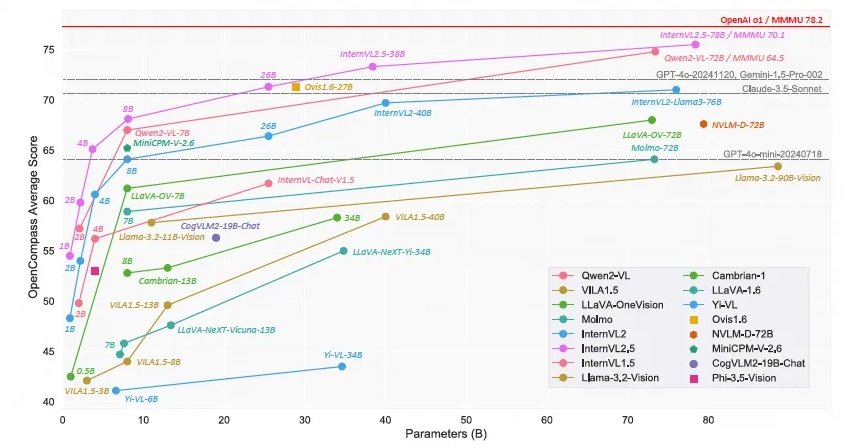

上海 AI 研究所は、オープンソースのマルチモーダル大規模言語モデル - Scholar・Wanxiang InternVL2.5 をリリースしました。そのパフォーマンスは、マルチモーダル理解ベンチマーク (MMMU) で 70% 以上の精度に達しており、これは MMMU に匹敵します。 GPT-4o と Claude-3.5-Sonnet などの商用モデルは同等のパフォーマンスを持っています。 InternVL2.5 モデルは、連鎖思考推論テクノロジーを使用して、複数のベンチマーク テスト、特に複数の専門分野にまたがる推論、文書理解、およびマルチモーダル幻覚検出で優れたパフォーマンスを実証します。このモデルのオープンソースの性質は、マルチモーダル AI テクノロジーの開発と革新を大きく促進します。

最近、上海 AI 研究所は Scholar・Wanxiang InternVL2.5 モデルの発売を発表しました。このオープンソースのマルチモーダル大規模言語モデルは、その卓越したパフォーマンスにより、マルチモーダル理解ベンチマーク (MMMU) で 70% を超える精度を達成した最初のオープンソース モデルとなり、GPT-4o や Claude などの商用モデルと競合しています。 -3.5-Sonnet 同等のパフォーマンス。

InternVL2.5 モデルは、Chain of Thinking (CoT) 推論テクノロジによって 3.7 パーセント ポイントの改善を達成し、テスト時間の強力なスケーラビリティの可能性を実証しました。このモデルは InternVL2.0 に基づいてさらに開発され、トレーニングおよびテスト戦略を強化し、データ品質を向上させることでパフォーマンスをさらに向上させます。モデルのサイズとパフォーマンスの関係を調査するために、ビジュアル エンコーダー、言語モデル、データセットのサイズ、テスト時間の構成について詳細な調査が行われます。

InternVL2.5 は、複数のベンチマーク、特に複数の専門分野にまたがる推論、文書理解、複数画像/ビデオ理解、現実世界の理解、複数モーダル幻覚検出、視覚的グラウンディング、複数言語機能、および純粋言語処理において競争力のあるパフォーマンスを実証します。そして他の分野。この成果は、オープンソース コミュニティにマルチモーダル AI システムの開発と応用のための新しい標準を提供するだけでなく、人工知能の分野における研究と応用の新たな可能性を切り開きます。

InternVL2.5 は、前世代の InternVL1.5 および InternVL2.0 と同じモデル アーキテクチャを維持し、「ViT-MLP-LLM」パラダイムに従い、新しい増分事前トレーニング済み InternViT-6B または InternViT-300M とさまざまな機能の統合を実装しています。さまざまなサイズとタイプの事前トレーニング済み LLM は、ランダムに初期化された 2 層 MLP プロジェクターを使用して統合されます。高解像度処理のスケーラビリティを高めるために、研究チームはピクセル シャッフル操作を適用して、ビジュアル トークンの数を元の数の半分に減らしました。

このモデルのオープンソースの性質は、研究者や開発者が InternVL2.5 に自由にアクセスして使用できることを意味し、マルチモーダル AI テクノロジーの開発と革新を大幅に促進します。

モデルリンク:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

InternVL2.5 のオープンソース リリースは、マルチモーダル AI 研究に貴重なリソースを提供し、その優れたパフォーマンスと拡張性により、この分野でのさらなるブレークスルーが促進され、より革新的なアプリケーションの誕生が促進されることが期待されます。 今後、InternVL2.5をベースにしたさらに驚くべき結果が期待されます。