NVIDIA の最新のオープン ビジュアル言語モデルである NVILA は、精度と効率において大幅な進歩を遂げ、ビジュアル AI 分野における新たなマイルストーンとなりました。他の大規模ビジョン モデルと比較して、NVILA はトレーニング コスト、メモリ使用量、遅延の大幅な削減を達成し、複数のベンチマーク テストでも優れたパフォーマンスを示し、一部の競合他社を上回りました。この記事では、モデルの精度と効率のバランスをとることを目的とした、「最初に拡張し、後で圧縮」テクノロジー、動的な S2 拡張、DeltaLoss ベースのデータセット プルーニング、その他の最適化戦略を含む、NVILA の技術的詳細を詳しく紹介します。 これは、視覚言語モデル技術がより経済的かつ効率的な方向に開発されたことを示しています。

最近、NVIDIA は新世代のオープン ビジュアル言語モデル、NVILA を発表しました。精度と効率を最適化するように設計されており、その優れたパフォーマンスによりビジュアル AI 分野のリーダーとなっています。

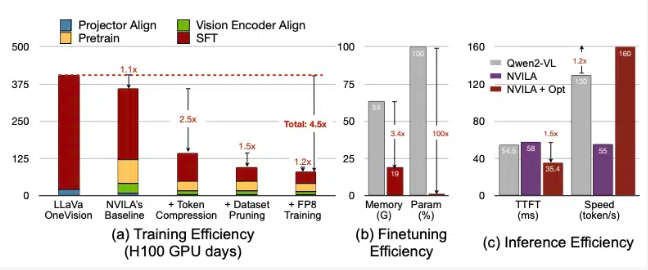

NVIDIA によると、NVILA はトレーニング コストを 4.5 倍削減し、微調整に必要なメモリを 3.4 倍削減し、プリフィルとデコードのレイテンシをほぼ 2 倍削減します。これらのデータは、別の大規模ビジョン モデルである LLaVa OneVision と比較されます。

ビデオベンチマークでは、NVILA は GPT4o Mini を上回り、GPT4o、Sonnet3.5、および Gemini1.5Pro との比較でも良好なパフォーマンスを示しました。また、Llama3.2との比較でもNVILAが僅差で勝利しました。それにもかかわらず、NVIDIA は、モデルはまだ Hugging Face プラットフォームにリリースされていないと述べ、モデルの再現性を高めるためにコードとモデルをすぐにリリースすることを約束しました。

NVIDIA は、視覚言語モデルのトレーニングにかかるコストが非常に高く、7B パラメーターの視覚言語モデルをトレーニングするには約 400 GPU 日かかると指摘しました。同時に、このようなモデルの微調整も非常にメモリを消費し、7B パラメータ モデルには 64GB 以上の GPU メモリが必要です。

したがって、NVIDIA は、モデルの精度と効率のバランスを取るために、展開してから圧縮するという手法を使用しています。写真やビデオのサイズを縮小する代わりに、このモデルは高解像度の画像やビデオから複数のフレームを使用して、細部が失われないようにします。

圧縮プロセス中に、モデルは視覚情報をより少ないトークンに圧縮し、重要な情報を保持するためにピクセルをグループ化することで入力データのサイズを削減します。 NVIDIA は論文の中で、解像度を 2 倍にするとビジュアル トークンの数が 2 倍になり、トレーニングと推論のコストが 2 倍以上増加すると述べています。したがって、空間/時間トークンを圧縮することでこのコストを削減します。

NVIDIA はいくつかのモデルのデモも披露し、NVILA は写真やビデオに基づいて複数のクエリに答えることができます。その出力結果は、NVIDIA が以前にリリースした VILA1.5 モデルとも比較されます。さらに、NVIDIA は、動的な S2 拡張、DeltaLoss ベースのデータセット プルーニング、FP8 精度を使用した量子化など、他のいくつかのテクノロジーも詳細に紹介しました。

これらのテクニックは 8B パラメータ モデルに適用されており、具体的な詳細は Arxiv で確認できます。

論文の入り口: https://arxiv.org/pdf/2412.04468

ハイライト:

? NVILA モデルはトレーニング コストを 4.5 倍削減し、ビジュアル AI の効率を向上させます。

? NVILA は、高解像度の画像とビデオ フレームを使用して、入力情報の整合性を保証します。

? NVIDIA は、研究の再現性を高めるためにコードとモデルをすぐにリリースすることを約束します。

全体として、NVILA の出現は、視覚言語モデルの開発に新たな可能性をもたらし、その効率的なトレーニングと推論プロセスにより、視覚 AI アプリケーションの敷居が下がり、この分野のさらなる開発が促進されます。より多くの研究者が参加し、ビジュアル AI テクノロジーの進歩を共同で促進できるよう、NVIDIA がコードとモデルを早期に公開することを期待しています。