ByteDance Doubao Big Model チームは、新しいコード ビッグ モデル評価ベンチマークである FullStack Bench をリリースしました。このベンチマークは、11 の実際のシナリオ、16 のプログラミング言語、および 3374 の質問をカバーしており、以前の評価基準と比較して、FullStack Bench はより優れたパフォーマンスを実現します。大規模モデルのコード開発能力を正確に評価します。 Stack Overflow からのデータをスクリーニングし、AI と人間によって相互検証して、データの信頼性と幅広さを確保します。同時にチームは、開発者が大規模なモデルのテストを実施しやすくするために、コード サンドボックス ツール SandboxFusion もオープンソース化しました。

12 月 5 日、Byte Doubao 大規模モデル チームは、最新の大規模コード モデル評価ベンチマークである FullStack Bench を開始しました。このベンチマークは、11 種類以上の実際のシナリオをカバーし、16 のプログラミング言語をサポートし、3374 の質問を含みます。このベンチマークは、これまでの評価基準よりも広範囲のプログラミング分野における大規模モデルのコード開発能力をより正確に評価でき、現実のプログラミング作業におけるモデルの最適化を促進します。

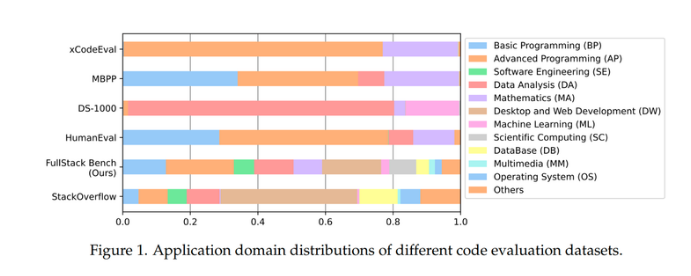

HumanEval や MBPP などの現在の主流のコード評価ベンチマークは通常、基本的および高度なプログラミング問題に焦点を当てていますが、DS-1000 はデータ分析と機械学習タスクに焦点を当てており、Python のみをサポートしています。 xCodeEval は高度なプログラミングと数学に焦点を当てており、大規模なアプリケーション シナリオと言語範囲の制限があります。対照的に、FullStack Bench はデータ カバレッジを大幅に強化し、11 以上のアプリケーション領域をカバーし、より複雑で多様なプログラミング シナリオをカバーします。

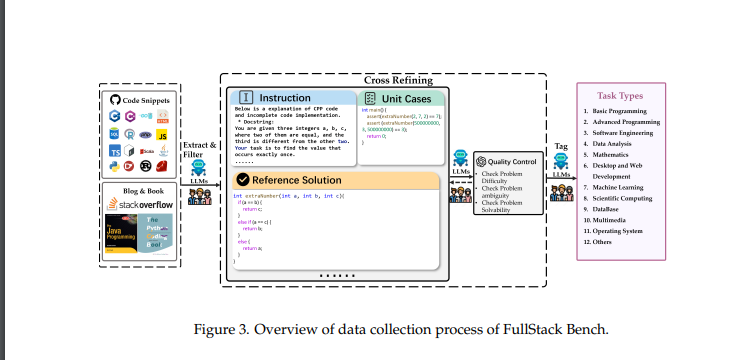

FullStack Bench データセットは、世界最大のプログラミング Q&A プラットフォームである Stack Overflow から取得したもので、研究チームは 500,000 の質問からアプリケーション分野の上位 88.1% を選択し、データセットの幅広さと堅牢性を確保しています。各質問には、評価の正確性を保証するための詳細な問題の説明、参照ソリューション、単体テスト ケースが含まれています。チームはまた、データの信頼性をさらに向上させるために、AI と手動レビューによるデータ品質の相互評価も実施しました。

開発者がこのデータ セットを使いやすくするために、Byte Doubao チームは、多言語プログラミング タスクの効率的な実行をサポートするコード サンドボックス ツール SandboxFusion もオープンソース化しました。 SandboxFusion は、広く使用されている 10 以上のコード評価データ セットと互換性があり、23 のプログラミング言語をサポートしているため、開発者はさまざまな環境で大規模なモデルを簡単にテストできます。

さらに、Byte Doubao の大規模モデル チームは、自社開発の大規模コード モデル Doubao-Coder を初めてデモンストレーションし、世界中の 20 以上の大規模コード モデルのプログラミング機能を評価しました。 Byte は AI プログラミングの分野で継続的に進歩しており、特に自社開発のコード ベース モデル MarsCode を通じて、毎月数百万のコードをユーザーに提供しており、この分野でのリーダー的地位を示しています。

データセットのオープンソースアドレス: https://huggingface.co/datasets/ByteDance/FullStackBench

サンドボックスオープンソースアドレス: https://github.com/bytedance/SandboxFusion

論文アドレス: https://arxiv.org/pdf/2412.00535v2

FullStack Bench と関連ツールのオープンソースのリリースは、AI コードの分野における ByteDance の大きな進歩を示し、大規模なコード モデルの評価と開発の促進に重要な貢献をしてきました。 開発者はこれらのリソースを使用して、独自のモデルのパフォーマンスを向上させ、AI コード テクノロジの進歩を促進できます。