Amazon が新たに開始した Bedrock AI サービスの自動ワード プロンプト最適化機能は、人工知能アプリケーション開発の状況を大きく変えています。この機能は、最小限のコストで AI タスクのパフォーマンスを大幅に向上させ、開発者の効率を大幅に向上させるように設計されています。開発者は、単一の API 呼び出しまたは簡単なクリック操作で、Anthropic の Claude3、Meta の Llama3、Mistral Large、Amazon 独自の Titan Text Premier など、複数の主要な AI モデルのプロンプト ワードを最適化できます。このテクノロジーは、テキストの要約、検索拡張生成 (RAG) に基づく対話の継続性、および関数呼び出し機能において大幅な改善を達成し、開発者の時間と労力を大幅に節約します。

Amazon は AI アプリケーション開発において革命を起こしています。 Bedrock AI サービスの自動ワード プロンプト最適化機能を開始することで、このテクノロジー巨人は最小限のユーザー コストで AI タスクのパフォーマンスを大幅に向上させることを約束します。

この革新的なツールを使用すると、開発者は 1 回の API 呼び出しまたは Amazon Bedrock コンソールのボタンをクリックするだけで、複数の AI モデルのプロンプトワードを簡単に最適化できます。現在、このシステムは、Anthropic の Claude3、Meta の Llama3、Mistral Large、Amazon 独自の Titan Text Premier など、さまざまな主要な AI モデルをサポートしています。

オープンソース データセットでのテスト結果は印象的です。 Amazon は、この最適化ツールがさまざまな AI タスクで大幅な改善を達成したと発表しました。

テキスト要約タスクのパフォーマンスが 18% 向上

検索拡張生成 (RAG) に基づいて対話の継続性が 8% 向上しました

関数呼び出し能力が 22% 増加

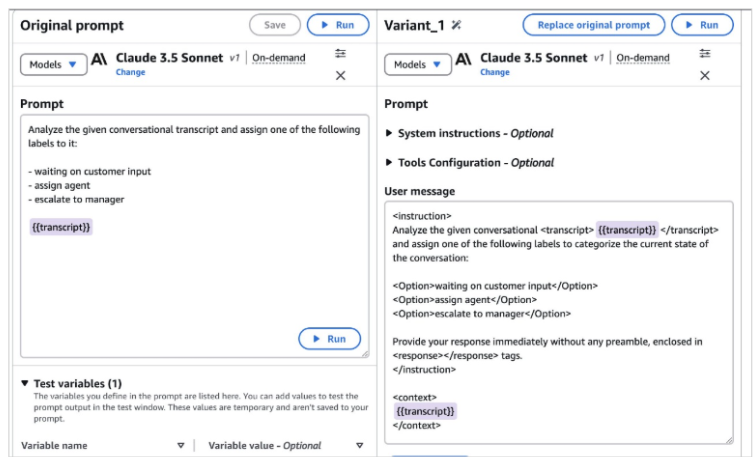

この機能の実際の応用シナリオには、チャット記録や通話記録の分類が含まれます。システムは、元のプロンプト ワードを自動的に調整してより正確にし、変数の追加とテストのプロセスを簡素化します。

これは開発者にとって何を意味するのでしょうか? 以前は手作業によるプロンプト ワード エンジニアリングに数か月かかった退屈なプロセスが大幅に短縮されることが期待されています。開発者は、さまざまなモデルやタスクに最適なプロンプト ワードをより迅速に見つけることができます。

ただし、Amazon は、このツールが万能薬ではないことを認めています。業界の専門家は、複雑な複数の例のプロンプトワードを処理する場合、自動最適化システムにはまだ限界があると指摘しています。構造や詳細を追加するのには役立ちますが、タスクの要件を理解し、効果的な合図の言葉を設計するには、人間の専門的な判断が依然としてかけがえのないものです。

Amazon だけではないことは注目に値します。 Anthropic と OpenAI も同様のプロンプトワード最適化ツールを開発しました。しかし、これらのシステムが改善をどのように評価するのか、また最初のプロンプトの品質にどの程度依存しているのかは完全には明らかではありません。

より広い観点から見ると、この機能は AI 業界が経験している大きな変革を反映しています。 AI モデルがますます複雑になるにつれて、最適化ツールの出現により技術的な参入障壁が低くなり、より多くの開発者が高度な AI テクノロジーを効率的に利用できるようになりました。

AIを開発する企業や開発者にとって、Amazonのこのイノベーションは間違いなく注目に値する。これは、プロンプトワードエンジニアリングの新たな、よりインテリジェントな段階を示す可能性があります。

制限はあるものの、Amazon の自動ワードプロンプト最適化機能は間違いなく人工知能の分野における大きな進歩であり、開発効率を大幅に向上させ、AI テクノロジーの幅広い応用を促進します。 今後、技術の成熟に伴い、このツールはさらに改良され、開発者へのサポートが強化されることが期待されます。