Epoch AI は最近、大規模な言語モデル トレーニングの計算能力シミュレーターをリリースしました。このシミュレーターは、さまざまなハードウェア条件下で GPT-4 のトレーニングのコストと効率をシミュレートすることで、研究者に貴重な参考資料を提供します。シミュレーションの結果、2012 年製の古いグラフィックス カード GTX580 を使用しても GPT-4 をトレーニングできることが示されましたが、コストは最新のハードウェアの 10 倍となり、AI モデルのトレーニングにおけるハードウェアのパフォーマンス向上の重要性が浮き彫りになりました。このシミュレーターはマルチデータセンターのトレーニング シミュレーションもサポートしており、ユーザーがパラメーターをカスタマイズし、さまざまなハードウェアとトレーニング戦略のパフォーマンスの違いを分析できるため、将来の大規模 AI モデルのトレーニングに重要な意思決定の基礎を提供します。

最近、人工知能研究会社 Epoch AI は、大規模な言語モデルをトレーニングするために必要な計算能力をシミュレートするために特別に設計された対話型シミュレーターをリリースしました。研究者らは、このシミュレーターを使用して、GTX580 などの 2012 年製の古いグラフィックス カードを使用して GPT-4 をトレーニングすることは可能ですが、コストが今日の最新のハードウェアの 10 倍になることを発見しました。

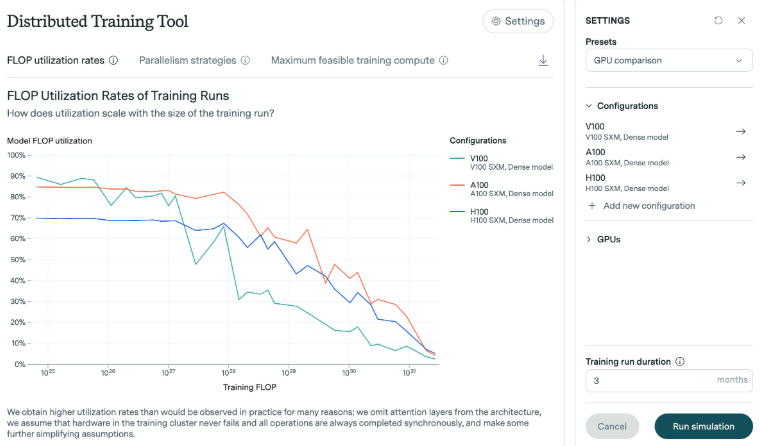

Epoch AI の調査によると、GPT-4 のトレーニングに必要な浮動小数点演算 (FLOP) の数は 1e25 ~ 1e26 の間です。この調査では、シミュレーターは、特にモデルがスケールアップした場合の、さまざまなグラフィックス カードの効率を分析しました。結果は、モデルが大きくなるにつれて、一般的に効率が低下することを示しています。近年発売された H100 グラフィックス カードを例に挙げると、長期間にわたって高い効率を維持できますが、V100 グラフィックス カードは、トレーニング規模が大きくなると効率がより顕著に低下します。

Epoch AIの実験では、GTX580グラフィックスカードのメモリはわずか3GBでした。このグラフィックス カードは、2012 年に AlexNet モデルをトレーニングするときに主流の選択肢でした。技術は進歩していますが、研究者らは、古いハードウェアを使用してもこのような大規模なトレーニングは可能ですが、必要なリソースとコストが法外に高いと考えています。

さらに、シミュレーターは、複数のデータセンターにわたる複雑なトレーニング シミュレーションをサポートします。ユーザーは、データセンターのサイズ、遅延、接続帯域幅などのパラメーターをカスタマイズして、複数の場所にわたるトレーニングの実行をシミュレートできます。このツールを使用すると、最新のグラフィックス カード (H100 と A100 など) 間のパフォーマンスの違いを分析したり、さまざまなバッチ サイズやマルチ GPU トレーニングの影響を調査したり、モデルの出力を文書化する詳細なログ ファイルを生成したりすることもできます。

Epoch AIは、ハードウェアの効率改善について理解を深め、チップ輸出規制の影響を評価するためにシミュレータを開発したと述べた。今世紀中に大規模な訓練ミッションが増加すると予想されるため、将来必要となるハードウェア要件を理解することが特に重要です。

全体として、この Epoch AI の研究とシミュレーターは、大規模な言語モデルのトレーニングに重要な参考値を提供し、研究者がハードウェアの効率をより深く理解し、トレーニング戦略を最適化し、将来の AI モデルを予測するためのより信頼性の高いトレーニングを提供するのに役立ちます。