Nexa AI は、エッジ デバイス向けに最適化された強力なツールである最新の OmniAudio-2.6B オーディオ言語モデルをリリースしました。自動音声認識 (ASR) と言語モデルを統一フレームワークに統合し、処理速度と効率を大幅に向上させ、従来のアーキテクチャのコンポーネント間の接続によって引き起こされる非効率性と遅延の問題を解決します。このモデルは、ウェアラブル、自動車システム、IoT デバイスなど、コンピューティング リソースが限られているデバイスに特に適しています。

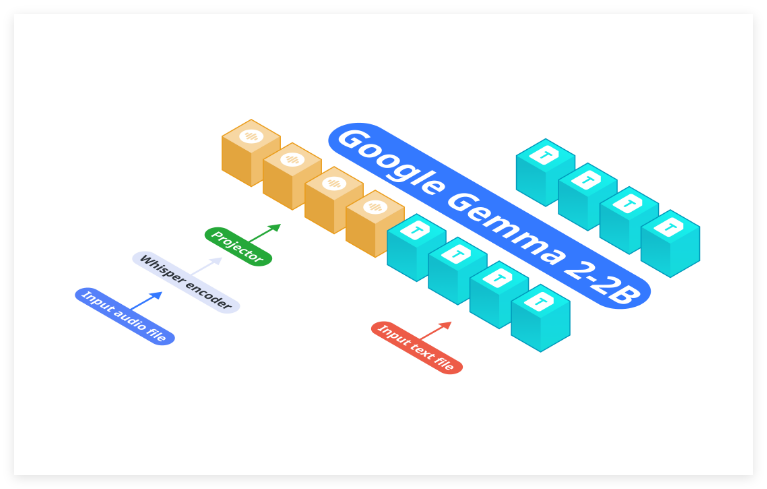

Nexa AI は最近、エッジ デバイスの効率的な展開のニーズを満たすように設計された新しい OmniAudio-2.6B オーディオ言語モデルを発表しました。自動音声認識 (ASR) と言語モデルを分離する従来のアーキテクチャとは異なり、OmniAudio-2.6B は Gemma-2-2b、Whisper Turbo、およびカスタム プロジェクターを統合フレームワークに統合します。この設計により、従来のシステムによって引き起こされる非効率性と遅延が排除されます。ネットワーク内のさまざまなコンポーネントのリンクは、コンピューティング リソースが限られているデバイスに特に適しています。

主なハイライト:

処理速度:OmniAudio-2.6Bはパフォーマンスに優れています。 2024Mac Mini M4Pro では、Nexa SDK と FP16GGUF 形式を使用して、モデルは 1 秒あたり 35.23 トークン、Q4_K_M GGUF 形式では 1 秒あたり 66 トークンを達成しました。比較すると、Qwen2-Audio-7B は同様のハードウェア上で 1 秒あたり 6.38 トークンしか処理できず、速度に大きな利点があることがわかります。リソース効率: このモデルのコンパクトな設計により、クラウド リソースへの依存が軽減され、電力と帯域幅に制約のあるウェアラブル、自動車システム、IoT デバイスに最適です。この機能により、限られたハードウェア条件下でも効率的な運用が可能になります。高い精度と柔軟性: OmniAudio-2.6B は速度と効率を重視していますが、精度の面でも優れたパフォーマンスを発揮し、文字起こし、翻訳、要約などのさまざまなタスクに適しています。リアルタイムの音声処理であっても、複雑な言語タスクであっても、OmniAudio-2.6B は正確な結果を提供します。

OmniAudio-2.6B の発表は、オーディオ言語モデルの分野における Nexa AI のもう 1 つの重要な進歩を示し、その最適化されたアーキテクチャは処理速度と効率を向上させるだけでなく、エッジ コンピューティング デバイスにさらなる可能性をもたらします。モノのインターネットとウェアラブル デバイスの普及が進むにつれて、OmniAudio-2.6B は複数のアプリケーション シナリオで重要な役割を果たすことが期待されています。

モデルアドレス: https://huggingface.co/NexaAIDev/OmniAudio-2.6B

製品アドレス:https://nexa.ai/blogs/omniaudio-2.6b

全体として、OmniAudio-2.6B は、その効率的なアーキテクチャと優れたパフォーマンスにより、エッジ デバイスでのオーディオ処理に革命的な変化をもたらし、将来の AI アプリケーションの広範な普及に向けた強固な基盤を築きました。 Nexa AI のイノベーションに期待する価値があります。