人工知能モデルの進歩は、前例のないコンピューティング能力をもたらしましたが、同時に膨大なエネルギー消費と環境問題ももたらしました。 OpenAI の最新 AI モデル o3 のエネルギー消費と環境への影響は、幅広い注目と議論を集めています。この記事では、o3 モデルのエネルギー消費、炭素排出、環境への影響を分析し、この問題に関する関連分野の専門家や学者の見解と対応戦略を探ります。

人工知能が進歩し続けるにつれて、イノベーションと持続可能性のバランスが重要な課題になります。最近、OpenAI は、これまでで最も強力なモデルである最新の AI モデル o3 を発表しました。ただし、これらのモデルの実行コストに加えて、環境への影響についても広く懸念されています。

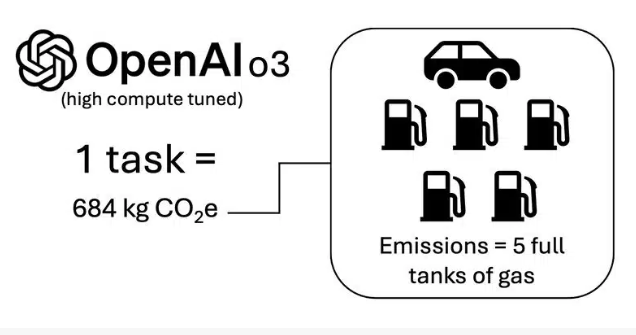

ある研究によると、各 O3 タスクは約 1,785 キロワット時の電力を消費します。これは、平均的なアメリカ家庭の 2 か月間の電力消費量に相当します。 Salesforce の AI サステナビリティ責任者、ボリス ガマザイチコフ氏の分析によると、この電力消費量は二酸化炭素換算排出量に換算すると約 684 キログラムに相当し、これは満タンのガソリン 5 つ分の二酸化炭素排出量に相当します。

o3 のハイコンピューティング バージョンは ARC-AGI フレームワークに基づいてベンチマークされ、計算は標準の GPU エネルギー消費とグリッド排出係数に基づいています。ガマザイチコフ氏は、「テクノロジーが拡大し、統合され続けるにつれて、これらのトレードオフにもっと注意を払う必要がある」と述べ、この計算では体内に含まれる炭素は考慮されておらず、GPU のエネルギー消費のみに焦点を当てていると述べた。実際の排出量は過小評価されている可能性があります。

さらに、データ サイエンティストの Kasper Groes Albin Ludvigsen 氏は、8 枚の Nvidia H100 グラフィックス カードを搭載した HGX サーバーのエネルギー消費量は 11 ~ 12 キロワットであり、グラフィックス カード 1 枚あたりの 0.7 キロワットをはるかに上回っていると述べました。

タスク定義の観点から、Pleias の共同創設者である Pierre-Carl Langlais 氏は、モデル設計、特にモデル設計をすぐに縮小できない場合の懸念を提起しました。 「複雑な数学の問題を解決するには、多くの製図、中間テスト、推論が必要です」と彼は言いました。

今年初めの研究で、ChatGPT は 1 回の会話で平均的な人間の 1 日の水分摂取量の 10%、つまりほぼ 0.5 リットルの水が消費されることが明らかになりました。この数字はそれほど多くないように思えるかもしれませんが、何百万人もの人々がこのチャットボットを毎日使用すると、水の総消費量はかなりの量になります。

Salesforce の人工知能テクノロジーのチーフアーキテクトである Kathy Baxter 氏は、OpenAI の o3 モデルのような AI の進歩は、ジェボンズのパラドックスに悩まされる可能性があると警告しました。 「必要なエネルギーは減るかもしれないが、水の消費量は増えるかもしれない」と彼女は言う。

高いエネルギー消費、複雑な冷却要件、巨大な物理インフラストラクチャなど、AI データセンターが直面する課題に対応して、Synaptics や embedUR などの企業は、エッジ AI を通じてこれらの問題を解決し、データセンターへの依存を減らし、遅延を削減しようとしています。パフォーマンスの消費を考慮し、デバイス レベルでリアルタイムの意思決定を行うことが可能になります。

ハイライト:

各 o3 タスクの消費電力は、家庭の 2 か月分の電力消費量に相当します。

各ミッションでは、ガソリン満タン 5 つ分と同じ量の二酸化炭素が排出されます。

ChatGPT の会話で消費される水の量は、人間の 1 日あたりの平均的な飲料水の 10% に達します。

全体として、AI モデルの高いエネルギー消費と環境への影響は無視できません。人工知能の持続可能な開発を達成するには、技術の進歩を追求しながら、より環境に優しく持続可能なAI開発の道を積極的に模索し、イノベーションと環境保護の関係のバランスをとる必要があります。