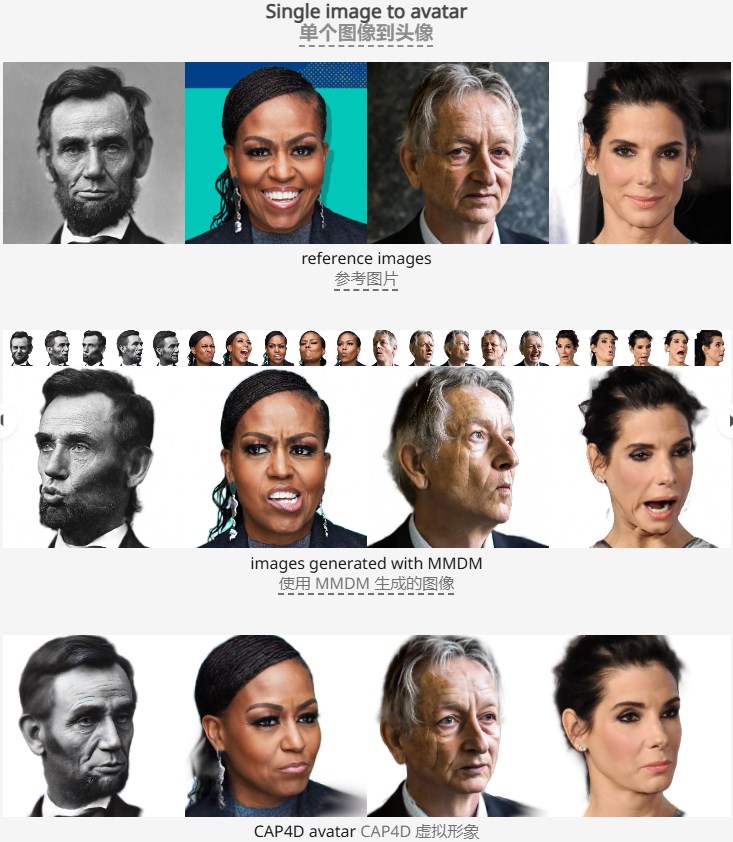

トロント大学と Vector Institute の研究チームは最近、画期的な 4D アバター生成技術である CAP4D モデルをリリースしました。これは変形可能なマルチビュー拡散モデル (MMDM) に基づいており、任意の数の参照画像から現実的でリアルタイムに制御可能な 4D アバターを生成でき、アバターの再構成効果とディテールのプレゼンテーションが大幅に向上します。このテクノロジーは、単一または少数の参照画像を処理できるだけでなく、テキスト プロンプトやアートワークからアバターを生成することもでき、その強力な適応性と生成機能を実証しています。その 2 段階の手法では、最初に MMDM を使用してさまざまな視点と表現の画像を生成し、次に参照画像を組み合わせて 4D アバターを再構築し、より豊かなインタラクションとダイナミックな効果を実現するために、既存の画像編集モデルや音声駆動のアニメーション モデルとの組み合わせをサポートします。仮想アバターを提供するアプリケーションは新たな可能性を広げます。

このモデルでは、MMDMを用いて視点や表情の異なる画像を生成し、生成した画像と参照画像を組み合わせてリアルタイムに制御可能な4Dアバターを再構成するという2段階の手法を採用しています。ユーザーは任意の数の参照画像を入力でき、モデルはこれらの画像情報を使用して高品質の 4D アバターを生成し、音声駆動のアニメーション モデルとの組み合わせをサポートして、オーディオ駆動のダイナミックな効果を実現します。 CAP4D モデルの登場は、4D アバター生成テクノロジーの大きな進歩を示しており、仮想現実、ゲーム、メタバースなどの分野で幅広い応用が期待されています。

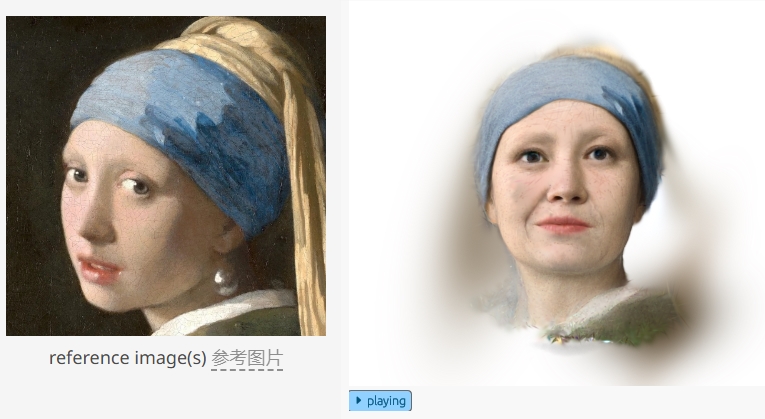

研究チームは、単一の参照画像、少数の参照画像、およびテキスト プロンプトやアートワークからアバターを生成するより困難なシナリオをカバーし、CAP4D によって生成されたさまざまなアバターを実証しました。複数の参照画像を使用することで、モデルは 1 つの画像では見ることができない詳細やジオメトリを復元できるため、再構成のパフォーマンスが向上します。さらに、CAP4D には既存の画像編集モデルと組み合わせる機能もあり、ユーザーは生成されたアバターの外観や照明を編集できます。

アバターの表現力をさらに向上させるために、CAP4D は生成された 4D アバターを音声駆動のアニメーション モデルと組み合わせて、オーディオ駆動のアニメーション効果を実現できます。これにより、アバターは静的な視覚効果を表示するだけでなく、サウンドを通じてユーザーと動的に対話することができ、仮想アバター アプリケーションの新しい分野が生まれます。

ハイライト:

CAP4D モデルは、2 段階のワークフローを使用して、任意の数の参照画像から高品質の 4D アバターを生成できます。

この技術により、さまざまな視点からアバターを生成でき、画像の再構成効果とディテールの表現が大幅に向上します。

CAP4D を音声駆動のアニメーション モデルと組み合わせることで、音声駆動の動的なアバターを実現し、仮想アバターのアプリケーション シナリオを拡張します。

全体として、CAP4D モデルは 4D アバター生成の分野で大きな進歩を遂げ、その効率的、現実的、多機能な機能は、仮想現実やデジタル エンターテイメントなどの分野に新たな可能性をもたらしました。 今後、この技術はさらに発展し、より便利でリアルな仮想インタラクティブ体験をユーザーに提供することが期待されます。