Answer.AI と LightOn は共同でオープンソース言語モデル ModernBERT をリリースしました。これは Google BERT を大幅に改善し、速度、効率、品質が大幅に向上しました。 ModernBERT は BERT より 4 倍高速に処理し、使用するメモリが少なく、最大 8192 トークンのテキストを処理できます。これは既存のモデルより 16 倍高速です。また、プログラミング コードのエンコードにおいて初めて画期的な進歩を遂げ、StackOverflow Q&A データセットで 80 点を超えるスコアを獲得し、新記録を樹立しました。さらに重要なのは、ModernBERT は大規模なテキスト処理のコストを大幅に削減し、通常の消費者向けハードウェアで実行できるため、GPT-4 などのモデルよりもコスト効率が高くなります。

ModernBERT の設計では、最大 8192 トークンの長さのテキストを処理できます。これは、既存のエンコード モデルの一般的な 512 トークン制限に比べて 16 倍の改善です。さらに、ModernBERT は、広範囲にトレーニングされた初めてのプログラミング コード エンコード モデルであり、StackOverflow Q&A データセットで 80 を超えるスコアを達成し、エンコード モデルの新記録を樹立しました。

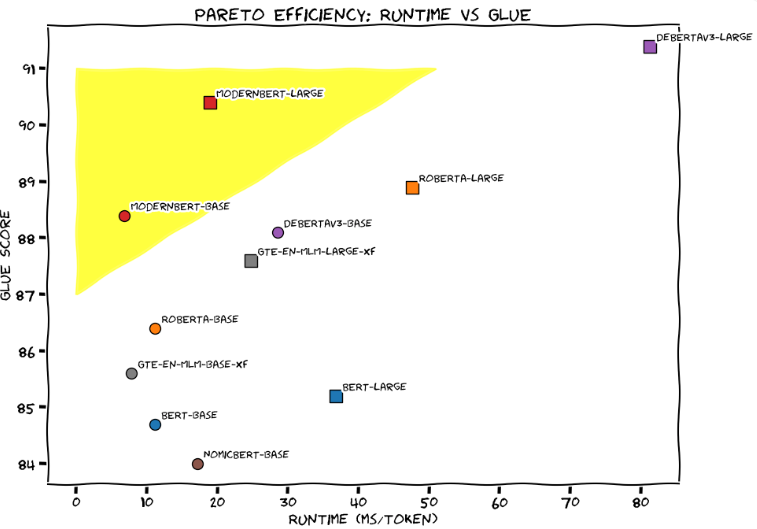

一般言語理解評価 (GLUE) では、ModernBERT-Large が、トークンあたり約 20 ミリ秒の処理時間と 90 のスコアで、処理速度と精度の最適なバランスを達成しました。開発チームは、ModernBERT をチューニングされたホンダ シビックと鮮やかに比較し、日常のアプリケーションにおける信頼性と効率性を強調しました。

GPT-4 などの既存の大規模言語モデルと比較して、ModernBERT は大規模なテキスト処理のコストを大幅に削減します。 GPT-4 はクエリごとに数ペニーの費用がかかりますが、ModernBERT はローカルで実行され、高速かつ安価です。たとえば、FineWeb Edu プロジェクトが 150 億のタグをフィルタリングしたとき、BERT モデルの使用コストは 6 万米ドルで、Google の Gemini Flash デコーダを使用した場合でも 100 万米ドルを超えました。

開発チームによれば、ModernBERT は、検索拡張生成 (RAG) システム、コード検索、コンテンツ レビューなど、さまざまな実用的なアプリケーションに最適です。特殊なハードウェアを必要とする GPT-4 とは異なり、ModernBERT は一般的なコンシューマ ゲーム GPU で効果的に実行できます。

現在、ModernBERT には 2 つのバージョンがあり、基本モデルには 1 億 3,900 万のパラメータが含まれ、大規模バージョンには 3 億 9,500 万のパラメータが含まれています。どちらのバージョンも現在 Hugging Face でリリースされており、ユーザーは既存の BERT モデルを直接置き換えることができます。開発チームは来年、より大きなバージョンをリリースする予定ですが、マルチモーダル機能の計画はありません。新しいアプリの開発を促進するために、最優秀プレゼンター 5 名に 100 ドルと 6 か月分の Hugging Face プロ サブスクリプションを与えるコンテストも開始します。

Google が 2018 年に BERT を発表して以来、このモデルは最も人気のある言語モデルの 1 つであり、HuggingFace では月間 6,800 万件以上のダウンロードが行われています。

プロジェクト入口: https://huggingface.co/blog/modernbert

ハイライト:

ModernBERT は BERT より 4 倍高速で、最大 8192 トークンの長さのテキストを処理できます。

GPT-4 と比較して、ModernBERT は大規模なテキスト処理のコストが大幅に削減され、動作がより効率的になります。

このモデルはプログラミング コードの処理に特に優れており、StackOverflow Q&A データ セットで 80 以上のスコアを獲得し、新記録を樹立しました。

つまり、ModernBERT のオープンソース リリースは、開発者に効率的で経済的かつ強力な言語モデルの選択肢を提供し、速度、効率、長いテキストを処理する能力において大きな利点があり、より多くの AI アプリケーションの革新的な開発を促進することが期待されています。 。 今後のアップデートと幅広いアプリケーションに期待しています。