Zhiyuan Research Institute と Tencent は共同で、大規模言語モデル (LLM) の長文理解および推論能力を評価するためのベンチマーク テスト プラットフォームである LongBench v2 をリリースしました。 LongBench v2 は、503 問の難しい 4 択多肢選択問題を含む、テキストの長さと評価の難易度を大幅に改善します。これにより、人間の専門家でも短時間で高い精度を得ることが困難になります。このベンチマークは 6 つの主要なタスク カテゴリをカバーしており、結果の信頼性と精度を高めるための評価方法の改善が含まれています。この動きは、長文処理における大規模言語モデルの進歩を促進し、関連研究により効果的な評価ツールを提供することを目的としています。

2024 年 12 月 19 日の記者会見で、Zhiyuan Research Institute と Tencent は、現実世界の長文マルチタスクにおける大規模言語モデル (LLM) の深い理解と推論能力を評価するように設計された LongBench v2 の発売を発表しました。設計されたベンチマーク。このプラットフォームは、理解と推論における長いテキスト モデルの進歩を促進することを目的としており、長いテキストと大規模な言語モデルの適用における現在の課題に対応します。

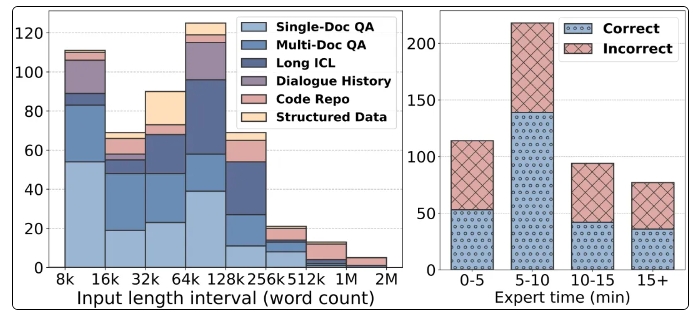

LongBench v2 の注目すべき機能には、8,000 語から 200 万語までの長いテキスト長のサポートが含まれ、難易度の高い 503 問の難しい 4 択多肢選択問題が含まれており、人間の専門家の平均的な正解率を 15 分で上回る率はわずか 53.7% です。 。さらに、このベンチマークは、単一ドキュメント Q&A、複数ドキュメント Q&A、長文コンテキスト学習などを含む 6 つの主要なタスク カテゴリをカバーしており、幅広いアプリケーション シナリオを保証します。

評価の信頼性を確保するために、LongBench v2 のすべての質問は多肢選択問題の形式であり、厳密な手動による注釈とレビューのプロセスが行われます。データ収集プロセス中に、質問の質と難易度を確保するために、トップクラスの大学からアノテーターが採用されました。 LongBench v2 は制御変数を導入することにより、オリジナルの Bradley-Terry 統計アルゴリズムを改善し、交絡因子の影響を軽減し、モデルのランキングをより科学的かつ正確にします。

評価結果に関しては、研究チームは 10 個のオープンソース LLM と 6 個のクローズドソース LLM をテストし、制御変数の導入後にモデルのパフォーマンスが大幅に向上したことを発見しました。特に、GPT-4o モデルは、より多くの推論ステップを導入した後、複数文書の質問応答や長文コンテキスト学習などのタスクで優れたパフォーマンスを発揮し、推論機能の重要性を示しています。

LongBench v2 のリリースは、大規模な言語モデルを評価するための新しいツールを提供するだけでなく、将来の研究の方向性を示し、モデル自体の理解と推論能力を向上させる重要性を強調します。 Zhiyuan Research Institute と Tencent の協力は、AI 技術分野のさらなる発展を示すものであり、このベンチマーク テストにより長文理解および推論技術の進歩が促進されることが期待されます。

ホームページ: https://longbench2.github.io

論文: https://arxiv.org/abs/2412.15204

データとコード: https://github.com/THUDM/LongBench

LongBench v2 のリリースは、より厳格な評価基準とより包括的なテスト内容により、大規模言語モデルの長いテキストの理解と推論能力の継続的な向上を促進するのに役立ちます。 AI技術の発展をさらに促進するために、今後もLongBench v2をベースとしたさらなる研究成果が登場することを期待しています。