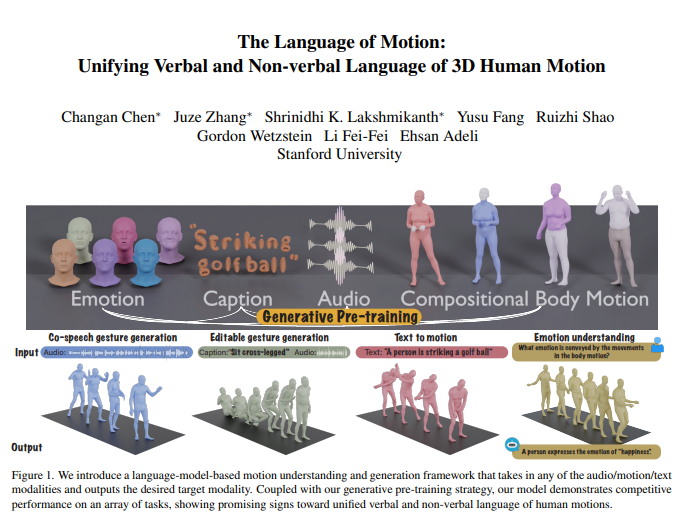

Li Feifei のチームは最近、画期的な研究結果を発表しました。それは、人間の行動を理解して生成し、言語モデルを巧みに組み合わせて言語と非言語の統一処理を実現する新しいマルチモーダル モデルです。この革新により、機械は人間の指示を理解できるだけでなく、行動の背後にある感情も解釈できるようになり、それによってより自然でスムーズな人間とコンピューターのインタラクションが実現します。モデルの中核はマルチモーダル言語モデル フレームワークにあり、オーディオ、モーション、テキストなどの複数の入力を統合し、対応するモーダル データを出力できます。協調的な音声ジェスチャ生成などのタスクで優れたパフォーマンスを発揮し、モデルのトレーニングに必要なデータ量を大幅に削減し、編集可能なジェスチャ生成やアクションによる感情予測などの新しいアプリケーション シナリオを拡張します。

Li Feifei氏のチームは、人間の行動を理解して生成できる新しいマルチモーダルモデルを立ち上げ、言語モデルを組み合わせることで言語と非言語の統合処理を実現した。 この画期的な研究により、機械は人間の指示を理解するだけでなく、動作に含まれる感情を読み取ることができるようになり、より自然な人間とコンピューターの対話が可能になります。

モデルの中核はマルチモーダル言語モデル フレームワークにあり、オーディオ、モーション、テキストなどの複数形式の入力を受け取り、必要なモーダル データを出力できます。 生成的な事前トレーニング戦略と組み合わせることで、モデルは複数のタスクで優れたパフォーマンスを発揮します。 たとえば、共同音声ジェスチャ生成では、このモデルは最先端技術を上回るだけでなく、トレーニングに必要なデータ量も大幅に削減されます。 さらに、このモデルは、編集可能なジェスチャの生成やアクションによる感情予測などの新しいアプリケーション シナリオも可能にします。

人間のコミュニケーションは本質的に多様であり、言語、顔の表情、体の姿勢などの言語的および非言語的手がかりが含まれます。 これらのマルチモーダルな動作を理解するこのモデルの機能は、ゲーム、映画、仮想現実などのアプリケーションで自然に通信する仮想キャラクターを作成するために重要です。 しかし、既存のアクション生成モデルは多くの場合、特定の入力モダリティ (音声、テキスト、またはアクション データ) に限定されており、利用可能なデータの多様性を十分に活用できていません。

このモデルは、次の 3 つの主な理由により、言語モデルを利用して言語と非言語を統合します。

言語モデルは、さまざまなモダリティを自然に接続します。

音声は高度に意味論的であり、ジョークに対する応答をモデル化するなどのタスクには、強力な意味論的推論能力が必要です。

言語モデルは、広範な事前トレーニングを通じて強力な意味理解能力を獲得します。

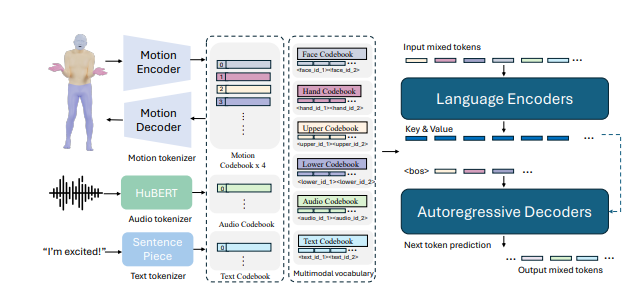

これを達成するために、研究チームはまず体をさまざまな部分(顔、手、上半身、下半身)に分割し、各部分に動きのラベルを個別に付けました。 テキストと音声のトークナイザーを組み合わせると、あらゆるモダリティでの入力を、言語モデルで使用するための一連のトークンとして表すことができます。 このモデルは 2 段階のトレーニング プロセスを採用しています。最初の事前トレーニングでは、身体の動きを組み合わせてさまざまなモダリティを調整し、音声とテキストを調整します。 その後、下流のタスクが命令に変換され、モデルがさまざまなタスクの命令に従うことができるように、これらの命令に基づいてトレーニングされます。

このモデルは、BEATv2 協調音声ジェスチャ生成ベンチマークで良好なパフォーマンスを示し、既存のモデルをはるかに上回りました。 特にデータが不足している場合、事前トレーニング戦略の効果も検証されており、強力な汎化能力が示されています。 音声アクションおよびテキストアクションタスクの事後トレーニングにより、モデルは音声とテキストのプロンプトに従うだけでなく、アクションデータから感情を予測するなどの新しい機能も実現できます。

技術的な詳細では、このモデルはモダリティ固有のトークナイザーを採用して、さまざまな入力モダリティを処理します。 具体的には、このモデルは、顔、手、上半身、下半身の動きを個別のマーカーに変換する複合身体動作 VQ-VAE をトレーニングします。 これらのモダリティ固有の語彙 (音声とテキスト) は、統合されたマルチモーダル語彙に結合されます。 トレーニング中、さまざまなモダリティの混合トークンが入力として使用され、出力はエンコーダー/デコーダー言語モデルによって生成されます。

このモデルはまた、マルチモーダル語彙を利用して、さまざまなモーダルデータを処理用の統一フォーマットに変換します。 事前トレーニング段階では、モデルはモダリティ間の変換タスクを実行することで、異なるモダリティ間の対応関係を学習します。 たとえば、モデルは上半身の動きを下半身の動きに変換したり、音声をテキストに変換したりすることを学習できます。 さらに、モデルは特定のアクション フレームをランダムにマスクすることにより、アクションの時間的展開を学習します。

トレーニング後のフェーズでは、ペアのデータを使用してモデルが微調整され、共同音声ジェスチャの生成やテキストからアクションへの生成などの下流タスクを実行します。 モデルが人間の自然な指示に従うことができるようにするために、研究者らは、音声からアクション、テキストからアクション、感情からアクションなどのタスクを指示に変換するテンプレートに従ってマルチタスク指示を構築しました。 このモデルには、ジェスチャを編集して、テキストと音声の合図に基づいて調整された全身の動きを生成する機能もあります。

最後に、このモデルは、行動から感情を予測するための新しい機能も解放します。 これはメンタルヘルスや精神医学などの分野に重要な影響を及ぼします。 このモデルは、他のモデルよりも行動で表現される感情をより正確に予測でき、強力なボディランゲージ理解能力を示します。

この研究は、人間の行動の言語と非言語を統合することが実用化にとって重要であり、言語モデルがそのための強力なフレームワークを提供することを示しています。

論文アドレス: https://arxiv.org/pdf/2412.10523v1

全体として、この研究はマルチモーダル人工知能の分野に大きな進歩をもたらし、人間とコンピューターの相互作用、仮想キャラクターの作成、感情認識における応用の可能性は非常に大きく、さらなる注目と研究に値します。 将来的には、このモデルはより多くの分野で役割を果たし、人工知能技術の開発を促進することが期待されています。