Zhipu AI は、GLM-4V-9B トレーニングに基づいた CogAgent-9B モデルをオープンソース化しました。これは、スクリーンショットを通じてユーザーの指示を理解し、次の GUI 操作を予測できるエージェント タスク モデルです。このモデルは汎用性が高く、パソコン、携帯電話、自動車などのさまざまな GUI インタラクション シナリオに適しています。以前のバージョンと比較して、CogAgent-9B-20241220 は多くの点で大幅に改善され、中国語と英語のバイリンガルをサポートし、詳細な思考プロセス、行動の説明、感性判断を出力できるようになりました。複数のデータセットで優れた結果を達成し、GUI の位置決め、シングルステップおよびマルチステップ操作における利点を実証しています。オープンソースの CogAgent-9B は、大型モデル技術の開発を促進するだけでなく、視覚障害者に新たな可能性を提供します。

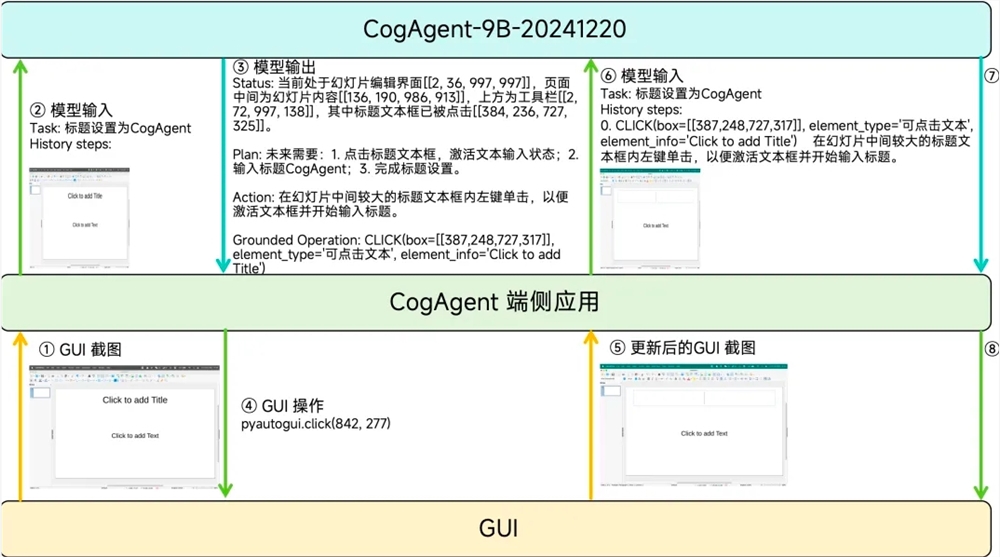

2023 年 12 月にオープンソース化された CogAgent モデルの最初のバージョンと比較して、CogAgent-9B-20241220 は、GUI の認識、推論予測の精度、アクション スペースの完全性、タスクの汎用性と一般化の点で大幅に向上しており、バイリンガルのスクリーンショットと言語をサポートしています。中国語と英語でのやりとり。 CogAgent の入力には、ユーザーの自然言語命令、実行されたアクション履歴記録、および GUI スクリーンショットのみが含まれ、レイアウト情報や追加の要素ラベル情報のテキスト表現は含まれません。出力には、思考プロセス、次のアクションの自然言語記述、次のアクションの構造化記述、次のアクションの感性判断が含まれます。

パフォーマンス テストでは、CogAgent-9B-20241220 が複数のデータ セットで優れた結果を達成し、GUI の位置決め、シングルステップ操作、中国語のステップワイズ リスト、およびマルチステップ操作における利点を実証しました。スマート スペクトラム テクノロジーによるこの動きは、大型モデル テクノロジーの開発を促進するだけでなく、視覚障害のある IT 実務者に新しいツールと可能性を提供します。

コード:

https://github.com/THUDM/CogAgent

モデル:

ハギングフェイス: https://huggingface.co/THUDM/cogagent-9b-20241220

Cogagent コミュニティ: https://modelscope.cn/models/ZhipuAI/cogagent-9b-20241220

CogAgent-9B のオープンソースは、大規模モデルのエージェント エコシステムにおける重要な一歩を示します。その効率的な GUI インタラクション機能と幅広い適用性は、インテリジェント インタラクション テクノロジの将来の開発に新たな方向性を提供し、より便利でスマートな将来のアプリケーション シナリオの到来を告げるものでもあります。 CogAgent-9B をベースにしたさらに革新的なアプリケーションが登場することを楽しみにしています。