NVIDIA は GB300 および B300 GPU をすぐに発売し、GB200 および B200 のリリースからわずか半年で、特に推論モデルで大幅なパフォーマンスの向上を達成しました。これは単なるハードウェアのアップグレードではなく、AI アクセラレーションの分野における NVIDIA の戦略的なレイアウト調整を表しており、業界に大きな影響を与えることになります。このアップグレードの核心は、推論パフォーマンスの大幅な飛躍と、大規模な言語モデルの効率とコストに直接影響するメモリとアーキテクチャの最適化にあります。

GB200 と B200 のリリースからわずか 6 か月後、Nvidia は再び新しい GPU GB300 と B300 を発売しました。これは小さなアップグレードのように見えるかもしれませんが、実際には大きな変更が含まれており、特に推論モデルのパフォーマンスが大幅に向上しており、業界全体に大きな影響を与えることになります。

B300/GB300: 推論パフォーマンスの大幅な飛躍

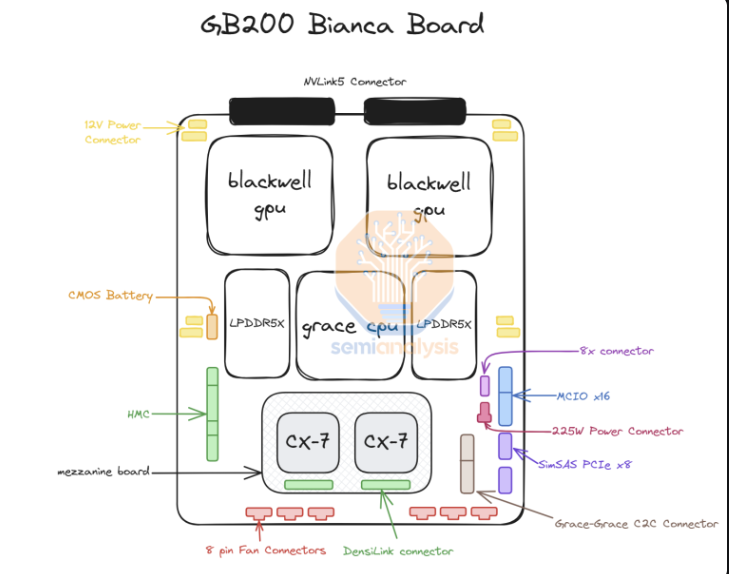

B300GPU は TSMC の 4NP プロセス ノードを使用し、コンピューティング チップ用に最適化されています。これにより、B300 の FLOPS パフォーマンスは B200 よりも 50% 高くなります。パフォーマンス向上の一部は TDP の増加によるもので、GB300 と B300HGX の TDP はそれぞれ 1.4KW と 1.2KW に達します (GB200 と B200 はそれぞれ 1.2KW と 1KW)。残りのパフォーマンスの向上は、CPU と GPU 間の動的な電力割り当てなど、アーキテクチャの強化とシステム レベルの最適化によってもたらされます。

FLOPSの向上に加えて、メモリも12-Hi HBM3Eにアップグレードされ、各GPUのHBM容量は288GBに増加しました。ただし、ピン速度は変わらないため、GPU あたりのメモリ帯域幅は 8TB/s のままです。サムスンがGB200またはGB300のサプライチェーンに参入できなかったことは注目に値します。

さらに、Nvidia は価格調整も行っています。これは、Blackwell 製品の利益率にある程度影響しますが、より重要なのは、B300/GB300 のパフォーマンス向上が主に推論モデルに反映されることです。

推論モデルに合わせてカスタマイズ

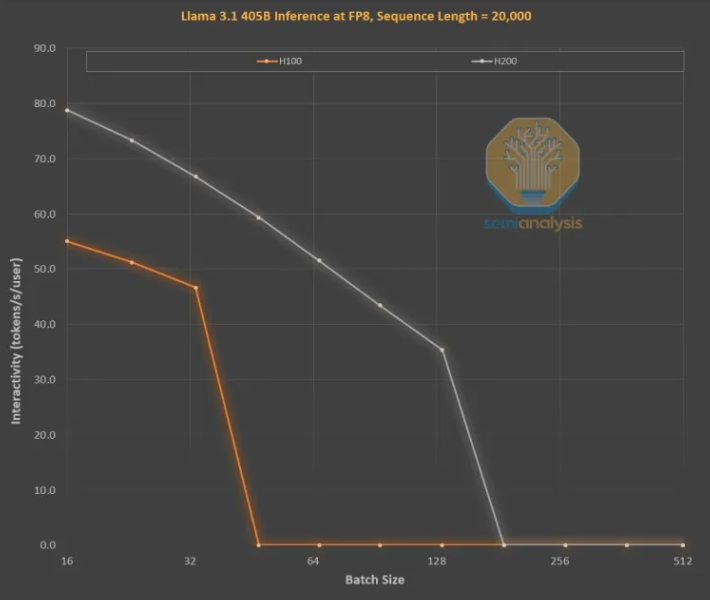

長いシーケンスにより KVCache が増加し、重要なバッチ サイズとレイテンシーが制限されるため、OpenAI O3 スタイルの LLM 推論トレーニングにはメモリの改善が不可欠です。 H100 から H200 へのアップグレード (主にメモリの増加) により、次の 2 つの側面が改善されました。

より高いメモリ帯域幅 (H200 では 4.8 TB/秒、H100 では 3.35 TB/秒) により、同等のすべてのバッチ サイズで対話性が全体的に 43% 向上しました。

H200 は H100 よりも大きなバッチ サイズを実行するため、1 秒あたりに生成されるトークンの数が 3 倍に増加し、コストが約 3 倍削減されます。この違いは主に、合計バッチ サイズを制限する KVCache によるものです。

メモリ容量の増加によるパフォーマンスの向上は大幅です。 2 つの GPU 間のパフォーマンスと経済的な違いは、仕様が示すよりもはるかに大きいです。

リクエストとレスポンスの間に大幅な遅延が発生するため、推論モデルのユーザー エクスペリエンスが低下する可能性があります。推論時間を大幅に短縮できれば、ユーザーの利用意欲や支払い意欲も高まるでしょう。

中世代メモリのアップグレードによるハードウェア パフォーマンスの 3 倍の向上は驚異的で、ムーアの法則、ファンの法則、またはこれまでに見てきた他のハードウェアの向上よりもはるかに高速です。

全体として、NVIDIA B300/GB300 の発売は、GPU テクノロジーのさらなる飛躍であるだけでなく、AI 推論モデルの適用を強力に推進し、ユーザー エクスペリエンスを大幅に向上させ、コストを削減し、AI 業界をリードします。新たな発展段階に入ります。