大規模な AI モデルのトレーニングにはコストがかかり、膨大なリソースが必要になるため、その広範な適用が制限され、エネルギー効率と環境への影響に関する懸念が生じます。従来のトレーニング方法は非効率的で、密な行列に依存しており、大量のメモリと計算能力を必要とします。いくつかの既存の方法はこれらの問題を軽減しようとしていますが、実際の応用には依然として限界があります。したがって、パフォーマンスを損なうことなく、メモリ使用量、計算コスト、トレーニング時間を同時に削減できるアプローチを開発することが重要です。

大規模な AI モデル (Transformers や言語モデルなど) のトレーニングは、AI 分野において不可欠な重要なリンクとなっていますが、高いコンピューティング コスト、メモリ消費量、エネルギー要件にも直面しています。たとえば、OpenAI の GPT-3 には 1,750 億のパラメータがあり、数週間の GPU トレーニングが必要です。この膨大なリソース要件により、このテクノロジーの適用は豊富なコンピューティング リソースを持つ大規模組織に制限されると同時に、エネルギー効率と環境への影響に関する懸念も悪化します。これらの課題に対処することは、AI 開発のより広範なアクセシビリティと持続可能性を確保するために重要です。

従来のトレーニング方法は非効率的であり、革新的なソリューションが緊急に必要とされています

CoMERA フレームワーク: 適応テンソル最適化による効率的なトレーニング

CoMERA の基礎は適応テンソル表現であり、これによりモデル レイヤーがリソースの制約に基づいてランクを動的に調整できるようになります。テンソル ランクを変更することで、フレームワークはニューラル ネットワークの動作上の整合性を損なうことなく圧縮を可能にします。この動的な最適化は、次の 2 段階のトレーニング プロセスを通じて実現されます。

初期段階: 安定したコンバージェンスに重点を置きます。

後の段階: 特定の圧縮目標を達成するためにランクを微調整します。

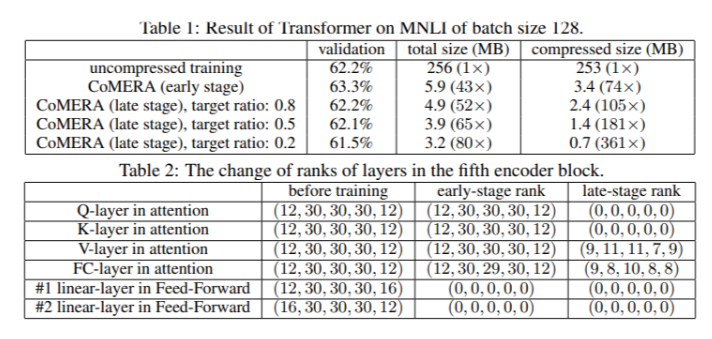

6 エンコーダーの Transformer モデルで、CoMERA は初期段階で最大 43 倍の圧縮率を達成し、その後の最適化段階ではさらに高い 361 倍の圧縮率を達成しました。さらに、GaLore と比較してメモリ消費量が 9 倍削減され、ラウンドあたりのトレーニングが 2 ~ 3 倍高速化されます。

複数のテスト結果により、CoMERA は優れたパフォーマンスを示しています

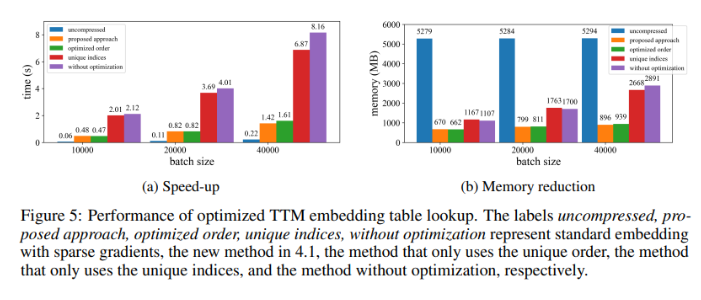

MNLI データセットでトレーニングされた Transformer モデルに適用すると、CoMERA は精度を維持しながらモデル サイズを 256 MB から 3.2 MB まで削減します。 DLRM などの大規模なレコメンダー システムでは、CoMERA はモデルを 99 倍圧縮し、ピーク時のメモリ使用量を 7 分の 1 に削減します。このフレームワークは、ドメイン固有の大規模言語モデルである CodeBERT の事前トレーニングでも良好なパフォーマンスを示し、全体の圧縮率 4.23 倍を達成し、一部のトレーニング ステージで 2 倍の高速化を達成しました。これらの結果は、さまざまなタスクとアーキテクチャを処理する能力を強調し、さまざまな分野での適用可能性を拡張します。

CoMERA フレームワークの主な利点の概要

この研究の主な結論は次のとおりです。

CoMERA は、特定のレイヤーで最大 361 倍、モデル全体で最大 99 倍の圧縮率を達成し、ストレージとメモリの要件を大幅に削減します。

このフレームワークにより、Transformer および推奨システムの各ラウンドのトレーニング時間が 2 ~ 3 倍短縮され、コンピューティング リソースと時間が節約されます。

テンソル化表現と CUDA グラフを使用することにより、CoMERA はピーク時のメモリ消費量を 7 分の 1 に削減し、より小型の GPU でのトレーニングを可能にします。

CoMERA のアプローチは、精度を維持または向上させながら、Transformers や大規模な言語モデルを含む複数のアーキテクチャをサポートします。

CoMERA は、トレーニングに必要なエネルギーとリソースを削減することで、より持続可能な AI 実践を可能にし、最先端のモデルをより幅広いユーザーが利用できるようにします。

全体として、CoMERA フレームワークは、大規模な AI モデルを効率的にトレーニングするための画期的なソリューションを提供します。これにより、モデルの精度を維持しながら、適応テンソル最適化によって計算コストとメモリ要件が大幅に削減されます。この研究は、AI 分野の継続的な開発とより広範なアクセシビリティに重要な貢献を果たします。