最近、Googleの深層学習チームと複数の大学の研究者は、動的なビデオからカメラパラメータと深度マップを効率的に推定できる「MegaSaM」と呼ばれる新しいシステムをリリースした。これはコンピュータビジョンの分野における大きな進歩であり、ビデオ処理技術に革命をもたらし、多くの分野に広範な応用をもたらすことが期待されています。動的なシーンを扱う場合、従来の方法には多くの制限がありました。MegaSaM の登場により、これらの問題が効果的に解決され、動的なビデオ分析のための新しいソリューションが提供されます。

最近、Googleの深層学習チームと複数の大学の研究者が共同で、通常の動的なビデオからカメラパラメータと深度マップを迅速かつ正確に推定できる「MegaSaM」と呼ばれる新しいシステムをリリースした。このテクノロジーの出現により、特に動的なシーンのキャプチャと分析の点で、私たちが日常生活で記録するビデオにさらなる可能性がもたらされます。

従来の Structure from Motion (SfM) および Monocular Simultaneous Localization and Mapping (SLAM) テクノロジーでは、通常、静的シーンのビデオの入力が必要であり、高い視差要件が必要です。動的なシーンに直面すると、静的な背景がない場合、アルゴリズムでエラーが発生しやすくなるため、これらの方法のパフォーマンスは満足のいくものではないことがよくあります。近年、いくつかのニューラル ネットワーク ベースの手法がこの問題を解決しようと試みていますが、これらの手法は多くの場合、特にカメラの動きが制御されていない場合や視野が不明な場合、ダイナミック ビデオにおいて膨大な計算オーバーヘッドと安定性の欠如を伴います。

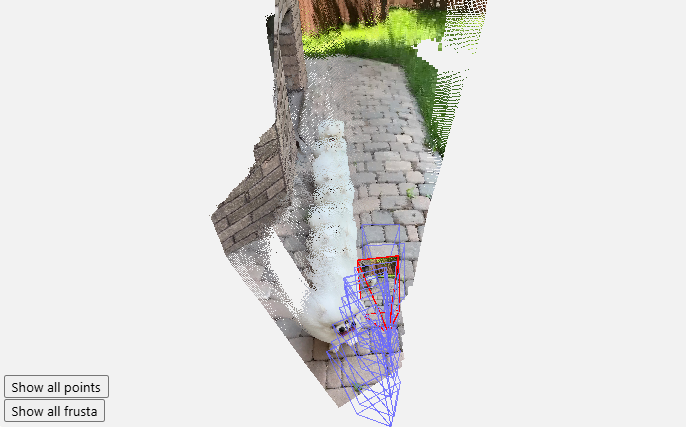

MegaSaM の登場により、この状況は変わりました。研究チームは、特にカメラの経路が制限されていない場合に、複雑な動的なシーンに適応できるように、ディープ ビジョン SLAM フレームワークを慎重に修正しました。一連の実験の結果、研究者らは、MegaSaM がカメラのポーズと深度推定の点で以前の関連技術を大幅に上回り、実行時間の点でも優れた性能を発揮し、一部の手法と同等であることを発見しました。

このシステムの能力により、撮影中に激しい動きやシーンのダイナミクスが発生する可能性のあるカジュアルな映像など、事実上あらゆるビデオを処理できます。 MegaSaM はソースビデオを毎秒約 0.7 フレームで処理し、優れたパフォーマンスを発揮します。研究チームは、実際のアプリケーションでの有効性を実証するために、ギャラリーでさらに多くの処理結果も示しています。

この研究成果は、コンピュータビジョンの分野に新たな風を吹き込むだけでなく、ユーザーの日常生活における映像処理の新たな可能性を提供するものであり、今後さらに多くのシーンでMegaSaMが活用されることを期待しています。

プロジェクトの入り口: https://mega-sam.github.io/#demo

ハイライト:

MegaSaM システムは、通常のダイナミック ビデオからカメラ パラメータと深度マップを迅速かつ正確に推定できます。

このテクノロジーは、動的なシーンにおける従来の方法の欠点を克服し、複雑な環境のリアルタイム処理に適応します。

実験結果は、MegaSaM が精度と運用効率の両方で以前のテクノロジーよりも優れていることを示しています。

MegaSaM システムの出現は、動的なビデオ処理に革命的な変化をもたらし、その効率的で正確なパフォーマンスにより、将来的にはより多くのアプリケーション シナリオが可能になる可能性があります。技術の継続的な開発と改善により、MegaSaMはより多くの分野で重要な役割を果たし、人々の生活にさらなる利便性をもたらすと考えられています。