Qwen チームは、最新のマルチモーダル推論モデル QVQ をオープンソース化しました。これは Qwen2-VL-72B 上に構築されており、AI の視覚的な理解と推論能力を大幅に向上させます。 QVQ は MMMU テストで 70.3 という高スコアを達成し、複数の数学的ベンチマークで前モデルを上回りました。この記事では、QVQ モデルの特徴、利点、制限、使用法を詳細に紹介し、読者が QVQ モデルをさらに理解して使用できるように関連リンクを提供します。

Qwen チームは最近、最新のマルチモーダル推論モデル QVQ のオープンソースを発表しました。これは、人工知能の視覚的理解と複雑な問題解決能力における重要な一歩を示しています。このモデルは Qwen2-VL-72B に基づいて構築されており、言語情報と視覚情報を組み合わせることで AI の推論能力を向上させることを目的としています。 MMMU の評価では、QVQ は 70.3 の高スコアを達成し、複数の数学関連のベンチマーク テストで Qwen2-VL-72B-Instruct と比較して大幅なパフォーマンスの向上を示しました。

QVQ モデルは、視覚的推論タスク、特に複雑な分析的思考を必要とする分野で特に利点を示しています。 QVQ-72B-Preview の優れたパフォーマンスにもかかわらず、チームは、言語の混合とコード切り替えの問題、循環論理パターンに陥る可能性、安全性と倫理的考慮事項、パフォーマンスとベンチマークの制限など、モデルのいくつかの制限も指摘しました。研究チームは、このモデルは視覚的推論において改善されているものの、Qwen2-VL-72B の能力を完全に置き換えることはできず、複数ステップの視覚的推論のプロセス中に、モデルが徐々に画像の内容に集中できなくなり、幻覚を引き起こす可能性があることを強調しました。

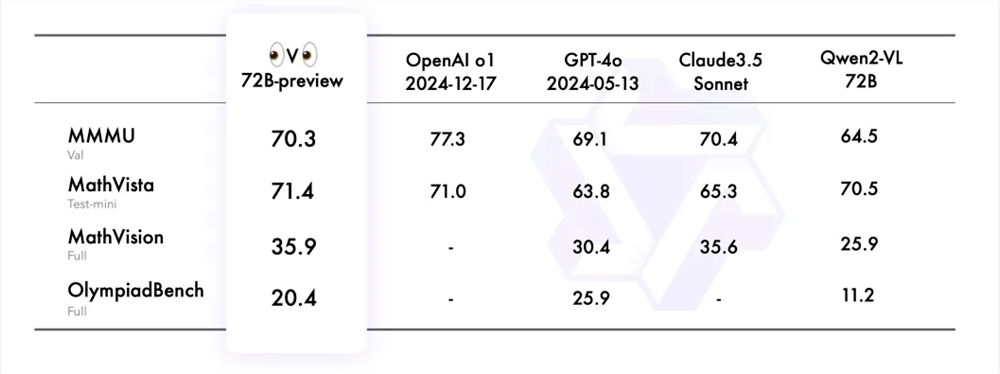

Qwen チームは、MMMU、MathVista、MathVision、OlympiadBench を含む 4 つのデータ セットで QVQ-72B-Preview を評価しました。これらのデータ セットは、視覚に関連するモデルの包括的な理解と推論能力を調べるように設計されています。 QVQ-72B-Preview はこれらのベンチマークで良好なパフォーマンスを示し、主要モデルとの差を効果的に縮めました。

視覚的推論タスクにおける QVQ モデルの適用をさらに実証するために、Qwen チームはいくつかの例を提供し、技術ブログへのリンクを共有しました。さらに、チームはモデル推論のコード例と、Magic API-Inference を使用して QVQ-72B-Preview モデルを直接呼び出す方法も提供しました。 Magic Platform の API 推論は QVQ-72B-Preview モデルのサポートを提供し、ユーザーは API 呼び出しを通じてモデルを直接使用できます。

モデルリンク:

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

体験リンク:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

中国語ブログ:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

QVQ モデルのオープンソースは、マルチモーダル人工知能研究に貴重なリソースを提供するだけでなく、将来の視覚推論の分野における AI のさらなる発展の前兆でもあります。 いくつかの制限はありますが、多くのベンチマーク テストでの優れたパフォーマンスは依然として印象的です。 今後、QVQ モデルのさらなる最適化と改善が期待されます。