Magic Square Quantitative は最近、新世代の大型モデル DeepSeek-V3 をリリースしました。その 6,710 億パラメータのスケールと MoE アーキテクチャにより、そのパフォーマンスはトップのクローズドソース モデルに匹敵し、低コストと高効率という特徴も備えており、広く注目を集めています。業界で注目。 DeepSeek-V3 は、多くのテストで優れたパフォーマンスを示し、特に数学的能力テストでは既存のすべてのモデルを上回り、GPT-4 などのモデルよりも大幅に低い価格で API サービスを提供し、開発者や企業に費用対効果の高い AI ソリューションを提供します。この記事では、DeepSeek-V3 のパフォーマンス、コスト、商用化戦略を詳細に分析し、AI 業界への影響について説明します。

Magic Square Quantitative は 12 月 26 日の夜、新世代の大型モデル DeepSeek-V3 をリリースし、驚くべき技術的進歩を示しました。 MoE (Mixed Experts) アーキテクチャを使用したこのモデルは、上位のクローズドソース モデルと性能が同等であるだけでなく、その低コストと高効率の機能が業界の注目を集めています。

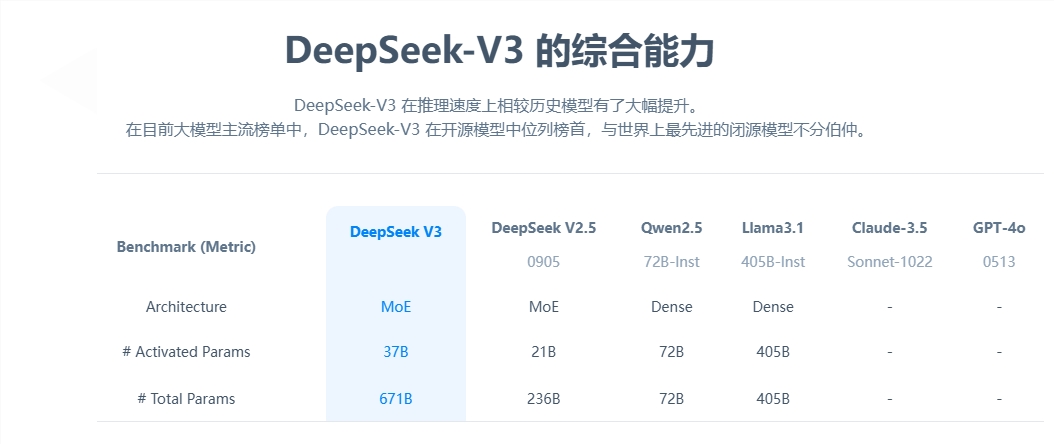

コアパラメーターの観点から見ると、DeepSeek-V3 には 6,710 億個のパラメーターがあり、そのうち 370 億個がアクティベーションパラメーターであり、14.8 兆トークンのデータ規模で事前トレーニングを完了しています。前世代の製品と比較して、新モデルの生成速度は 3 倍向上し、1 秒あたり 60 個のトークンを処理できるため、実用的なアプリケーションの効率が大幅に向上します。

性能評価においては、DeepSeek-V3が優れた強みを示しています。 Qwen2.5-72B や Llama-3.1-405B などの有名なオープン ソース モデルを上回るだけでなく、複数のテストにおいて GPT-4 や Claude-3.5-Sonnet と同等の性能を発揮します。特に数学的能力テストにおいて、このモデルは既存のすべてのオープンソース モデルおよびクローズドソース モデルを上回り、優れた結果をもたらしました。

最も顕著なのは、DeepSeek-V3 の低コストの利点です。オープンソースの論文によると、GPU 時間あたり 2 米ドルで計算すると、モデルのトレーニングの総コストはわずか 557 万 6,000 米ドルです。この画期的な結果は、アルゴリズム、フレームワーク、ハードウェアの協調的な最適化によるものです。 OpenAI の共同創設者である Karpathy 氏はこれを高く評価し、DeepSeek-V3 はわずか 280 万 GPU 時間で Llama3 を上回るパフォーマンスを達成し、コンピューティング効率が約 11 倍向上したと指摘しました。

製品化にあたっては、DeepSeek-V3のAPIサービス価格は前世代に比べて値上げされましたが、依然として高いコストパフォーマンスを維持しています。新しいバージョンの価格は、入力トークン 100 万個あたり 0.5 ~ 2 元、出力トークン 100 万個あたり 8 元で、総コストは約 10 元です。比較すると、GPT-4 の同等サービス価格は約 140 元であり、価格差は顕著です。

包括的なオープンソースの大規模モデルとして、DeepSeek-V3 のリリースは中国の AI テクノロジーの進歩を実証するだけでなく、開発者や企業に高性能で低コストの AI ソリューションを提供します。

DeepSeek-V3 の登場は、大規模言語モデルの分野における中国の AI 技術の大きな進歩を示しており、その低コストと高性能の利点により商用アプリケーションでの競争力が高く、今後の発展が期待されています。 。 このモデルのオープンソースは、世界の AI コミュニティに貴重なリソースを提供し、AI テクノロジーの共有と開発を促進します。