OpenAI の最新の o シリーズ AI モデルは、より深いルール理解と推論機能を通じて AI システムのセキュリティを向上させるように設計されています。過去の学習例のみに依存するのとは異なり、このモデルはセキュリティ ガイドラインを積極的に理解して適用し、有害なリクエストを効果的にブロックできます。 この記事では、o1 モデルの 3 段階のトレーニング プロセスと、セキュリティ テストにおける他の主流の AI システムを上回るそのパフォーマンスについて詳しく説明します。 ただし、o1 モデルが改良されたとしても、依然として操作の可能性があり、AI の安全性の分野における継続的な課題が浮き彫りになっています。

OpenAI は、セキュリティ ルールの処理方法を変更することで AI システムのセキュリティを向上させることを目的とした、AI セキュリティに対する新しいアプローチを発表しました。この新しい O シリーズ モデルは、例から良い動作と悪い動作を学習することだけに依存するのではなく、特定の安全ガイドラインを理解し、積極的に推論することができます。

OpenAI の調査の一例では、ユーザーが暗号化されたテキストを介して違法行為の指示を取得しようとしたとき、モデルは情報の解読に成功しましたが、違反する可能性のあるセキュリティ ルールを具体的に引用して要求を拒否しました。この段階的な推論プロセスでは、モデルが関連する安全ガイドラインにどの程度効果的に準拠しているかを示します。

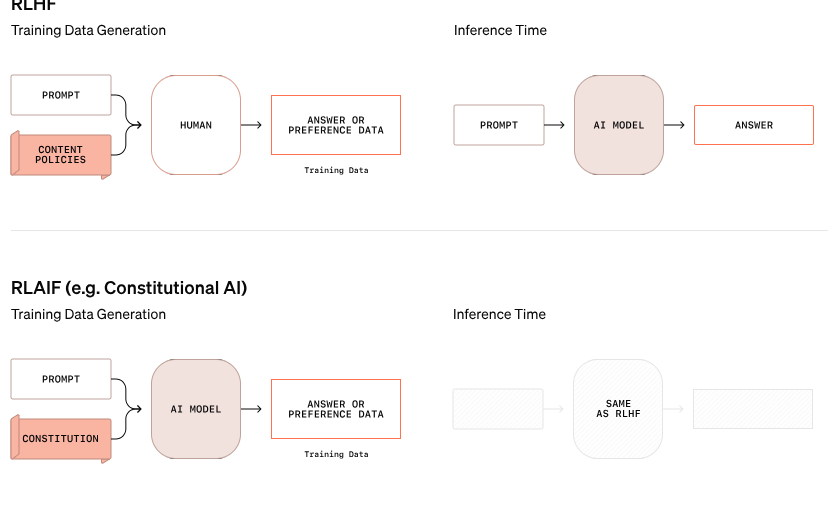

この o1 モデルのトレーニング プロセスは 3 つの段階に分かれています。まず、モデルは支援方法を学習します。次に、モデルは教師あり学習を通じて、特定の安全ガイドラインを研究します。最後に、モデルは強化学習を使用してこれらのルールの適用を練習します。これは、モデルがこれらの安全ガイドラインを真に理解し、浸透させるのに役立つステップです。

OpenAI のテストでは、新しく発売された o1 モデルは、GPT-4o、Claude3.5Sonnet、Gemini1.5Pro など、セキュリティの点で他の主流システムよりも大幅に優れたパフォーマンスを示しました。モデルが有害なリクエストをどのように拒否し、適切なリクエストを通過させるかを含むテストでは、o1 モデルが精度とジェイルブレイクの試みに対する耐性の両方で最高のスコアを達成したことが示されました。

OpenAIの共同創設者であるWojciech Zaremba氏は、ソーシャルプラットフォーム上で、この「思慮深い調整」作業を非常に誇りに思っており、この種の推論モデルは、特に汎用人工知能(AGI)の開発において全く新しい方法で調整できると信じていると述べた。システムが人間の価値観と一致していることを保証することは大きな課題です。

OpenAI の進歩の主張にもかかわらず、「解放者プリニウス」という名前のハッカーは、新しい o1 および o1-Pro モデルですら操作してセキュリティ ガイドラインに違反できることを示しました。プリニウスは、モデルがアダルト コンテンツを生成し、さらには火炎瓶の作り方を共有できるようにすることに成功しましたが、システムは当初これらの要求を拒否しました。これらの事件は、これらの複雑な AI システムが厳密なルールではなく確率に基づいて動作するため、制御することの難しさを浮き彫りにしています。

ザレンバ氏は、OpenAIにはAIの安全性と人間の価値観との一貫性に専念する約100人の従業員がいると述べた。同氏は、競合他社のセキュリティへのアプローチ、特にセキュリティ対策よりも市場の成長を優先するイーロン・マスク氏のxAIや、適切な保護策を講じずにAIエージェントを最近発売したAnthropicについて疑問を呈し、これがOpenAIに「大きな否定的なフィードバック」をもたらすだろうとザレンバ氏は考えている。

公式ブログ:https://openai.com/index/deliberative-alignment/

ハイライト:

OpenAI の新しい o シリーズ モデルは、セキュリティ ルールを積極的に推論し、システム セキュリティを向上させることができます。

o1 モデルは、有害なリクエストの拒否と精度において、他の主流の AI システムよりも優れています。

改善されたにもかかわらず、新しいモデルは依然として操作される可能性があり、セキュリティ上の課題は依然として深刻です。

全体として、OpenAI の o シリーズ モデルは AI セキュリティの分野で大きな進歩を遂げましたが、同時に大規模な言語モデルのセキュリティの複雑さと継続的な課題も明らかにしました。 将来的には、AI セキュリティ リスクに真に効果的に対処するために、さらなる取り組みを継続する必要があります。