VideoLLaMA2 は、ビデオ理解機能、特に時空間モデリングと音声理解の向上に重点を置いた高度なマルチモーダル言語モデルです。たとえば、31 秒のビデオの場合、認識が完了して字幕が生成されるまでにかかる時間はわずか 19 秒です。このプロジェクトは、ビデオ大規模言語モデル技術の開発を促進し、ユーザーにより便利で深いビデオコンテンツ理解体験を提供することを目的としています。この記事では、VideoLLaMA2の機能、活用シーン、お試しエントリーについて詳しく紹介します。

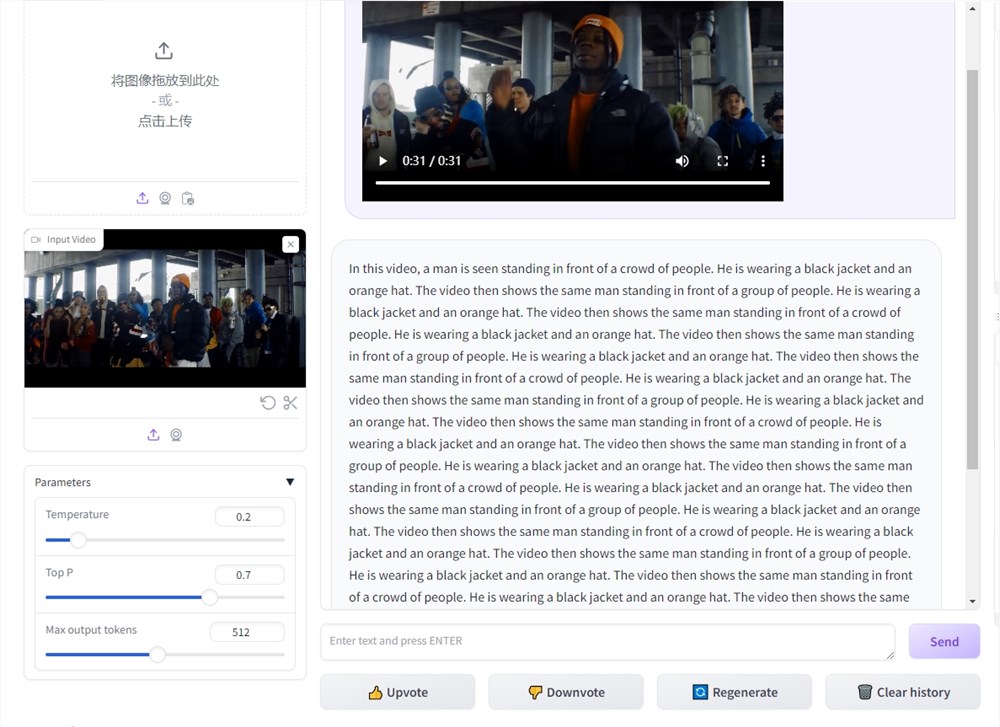

人工知能技術の発展に伴い、ビデオの理解はますます重要になっています。このような背景から、ビデオ大規模言語モデルの時空間モデリングと音声理解機能を向上させることを目的とした VideoLLaMA2 プロジェクトが誕生しました。このプロジェクトは、ユーザーがビデオ コンテンツをより深く理解できるようにする高度なマルチモーダル言語モデルです。テストでは、VideoLLaMA2 はビデオ コンテンツを非常に迅速に認識しました。たとえば、31 秒のビデオを認識して字幕を生成するのにわずか 19 秒かかりました。以下のビデオの字幕は、VideoLLaMA2 が指示に基づいてビデオを理解したものです。

ビデオのキャプションには次のように書かれています。 このビデオは、コーヒーの泡の乱流の中を航行するミニチュアの海賊船の活気に満ちた風変わりなシーンを捉えています。これらの複雑なデザインの船は、帆を上げ、旗を振り、泡の海を渡る冒険の旅をしているかのように見えます。船には詳細な艤装とマストがあり、シーンの信憑性を高めています。スペクタクル全体は、一杯のコーヒーの範囲内で海洋冒険を楽しく想像力豊かに描いたものです。

現在、VideoLLaMA2 の体験版が正式にリリースされています。その体験は次のとおりです。

VideoLLaMA2 プロジェクト入口: https://top.aibase.com/tool/videollama-2

トライアルURL:https://huggingface.co/spaces/lixin4ever/VideoLLaMA2

VideoLLaMA2 の機能:

1. 時空間モデリング: VideoLLaMA2 は、正確な時空間モデリングを実行し、ビデオ内のアクションとイベント シーケンスを識別できます。ビデオ コンテンツをモデル化することで、ビデオ ストーリーをより深く理解できます。

時空間モデリングとは、モデルがビデオ内の時間的および空間的情報を正確にキャプチャできることを意味し、それによってビデオ内のイベントやアクションのシーケンスを推測できます。この機能により、ビデオ コンテンツをより正確かつ詳細に理解できるようになります。

2. 音声理解: VideoLLaMA2 は優れた音声理解機能も備えており、ビデオ内の音声コンテンツを識別して分析できます。これにより、ユーザーは単なる視覚情報を超えて、ビデオコンテンツをより包括的に理解できるようになります。

音声の理解とは、モデルが音声対話、音楽、その他のコンテンツを含むビデオ内の音声を認識して分析できることを意味します。音声を理解することで、ユーザーはビデオのBGMや会話の内容などをより深く理解できるようになり、ビデオをより包括的に理解できるようになります。

VideoLLaMA2 アプリケーション シナリオ:

上記の機能に基づいて、VideoLLaMA2 アプリケーション シナリオは、リアルタイムのハイライト モーメントの生成、リアルタイムのライブ コンテンツの理解と要約などに使用できます。それは次のように要約できます。

ビデオ理解研究: 学術分野では、VideoLLaMA2 をビデオ理解研究に使用でき、研究者がビデオ コンテンツを分析し、ビデオ ストーリーの背後にある情報を探索するのに役立ちます。

メディア コンテンツ分析: メディア業界は、VideoLLaMA2 をビデオ コンテンツ分析に使用して、ユーザーのニーズをより深く理解し、コンテンツの推奨事項を最適化できます。

教育とトレーニング: 教育の分野では、VideoLLaMA2 を使用して教育ビデオを作成し、教育内容の理解を支援し、学習効果を向上させることができます。

全体として、VideoLLaMA2 は、その強力な時空間モデリングと音声理解機能により、ビデオ コンテンツ理解の分野で大きな可能性を示しており、将来の応用の可能性が広く、さらなる開発と応用に期待する価値があります。