ByteDance は最近、新世代の深度モデルである Depth Anything V2 をリリースしました。これは、単眼深度推定の分野で大きな進歩を遂げました。前世代と比較して、V2 バージョンは詳細精度、堅牢性、効率性の点で大幅に向上しており、その速度は安定拡散に基づくモデルよりも 10 倍以上高速です。このテクノロジーの進歩は、モデル自体の最適化だけでなく、コンピューター ビジョンの分野に新たな可能性をもたらす革新的なトレーニング方法にも反映されています。この記事では、Depth Anything V2 の主な機能、トレーニング方法、幅広いアプリケーション シナリオについて詳しく説明しており、このテクノロジーの進歩を深く理解することができます。

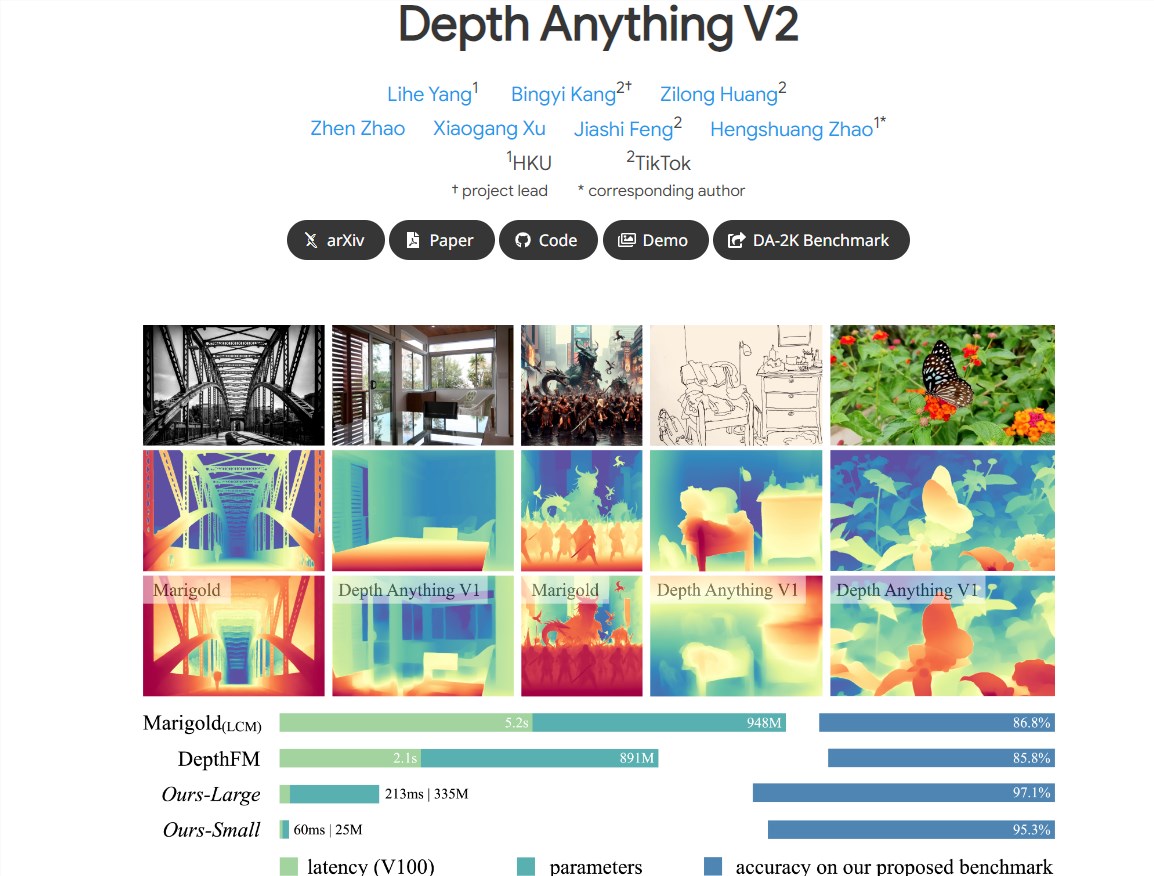

6 月 14 日の ChinaZ.com からのニュース: ByteDance は、単眼深度推定の分野で大幅なパフォーマンス向上を達成した新世代の Depth Anything V2 深度モデルをリリースしました。前世代の Depth Anything V1 と比較して、V2 バージョンはより詳細なディテールと強力な堅牢性を備えていると同時に、効率も大幅に向上し、Stable Diffusion ベースのモデルよりも 10 倍以上高速です。

主な特徴:

より詳細な詳細: V2 モデルは詳細に最適化されており、より詳細な深度予測を提供します。

高い効率と精度: SD に基づいて構築されたモデルと比較して、V2 は効率と精度が大幅に向上しました。

マルチスケール モデルのサポート: さまざまなアプリケーション シナリオに適応するために、25M から 1.3B の範囲のパラメーターを持つさまざまなスケールのモデルを提供します。

主な実践方法: 実際の画像を合成画像に置き換え、教師モデルの容量を拡張し、大規模な疑似注釈付き画像を使用して生徒モデルを教えることにより、モデルのパフォーマンスを向上させます。

モデルのパフォーマンスを向上させるための 3 つの重要な実践方法:

合成画像の使用: 注釈付きのすべての実際の画像が合成画像に置き換えられるため、モデルのトレーニング効率が向上します。

教師モデルの容量の拡張: 教師モデルの容量を拡張することで、モデルの汎化能力が強化されます。

疑似アノテーション付き画像の適用: 大規模な疑似アノテーション付き実画像をブリッジとして使用して、学生モデルを指導し、モデルの堅牢性を向上させます。

幅広いアプリケーション シナリオのサポート:

幅広いアプリケーションのニーズを満たすために、研究者はさまざまなスケールのモデルを提供し、その一般化機能を活用してメトリック深度ラベルによる微調整を行っています。

将来の研究を促進するために、まばらで深い注釈を含む多様な評価ベンチマークが構築されています。

合成画像と実際の画像に基づくトレーニング方法:

研究者らはまず合成画像で最大の教師モデルをトレーニングし、次にラベルのない大規模な実画像に対して高品質の擬似ラベルを生成し、これらの擬似ラベル付き実画像で学生モデルをトレーニングしました。

トレーニング プロセスでは、595,000 枚の合成画像と 6,200 万枚以上の実際の擬似ラベル付き画像が使用されます。

Depth Anything V2 モデルの発表は、深層学習テクノロジーの分野における ByteDance の革新的な機能を実証しており、その効率的で正確なパフォーマンス特性は、このモデルがコンピューター ビジョンの分野で幅広い応用可能性を持っていることを示しています。

プロジェクトアドレス: https:// Depth-anything-v2.github.io/

全体として、Depth Anything V2 モデルの登場は、単眼深度推定技術における大きな進歩を示しています。その高い効率、精度、幅広い応用の可能性により、将来的にはコンピュータ ビジョンの分野で大きな発展の可能性があり、より多くのアプリケーション シナリオでの実装を期待する価値があります。