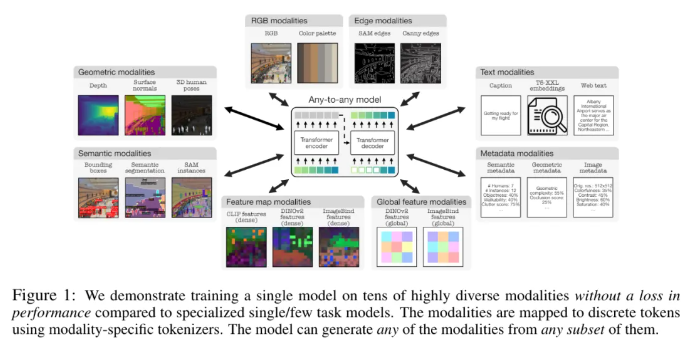

Apple とスイスのローザンヌ工科大学 (EPFL) は協力して、画期的なマルチモーダル モデル 4M-21 を開発しました。このモデルは 21 の異なるモダリティで学習でき、そのパフォーマンスは既存のモデルよりも大幅に向上し、クロスモーダル検索や制御可能な生成などの複数の機能を実現します。この研究では、モデルとデータセットのサイズを拡大し、トレーニングモダリティの種類と数を増やし、共同トレーニング戦略を採用することで、モデルのパフォーマンスと適応性が大幅に向上しました。 4M-21 モデルは、Transformer ベースのエンコーダー/デコーダー アーキテクチャを採用し、新しいモダリティに適応する追加のモーダル埋め込みを追加します。そのトレーニング プロセスでは、さまざまなモダリティの特性が十分に考慮され、モーダルに特定のトークン化方法が使用されます。

この研究では、4M 事前トレーニング ソリューションを採用しました。これは、モデルとデータセットのサイズを拡大し、モデルのトレーニングに関与するモダリティの種類と数を増やし、複数のモダリティで共同トレーニングを実施することにより、モデルのパフォーマンスと適応性を向上させることができます。データセット。研究者は、さまざまなトークン化手法を使用して、グローバルな画像の埋め込み、人間のポーズ、セマンティック インスタンスなど、さまざまな特徴を持つモダリティを離散化します。アーキテクチャの選択に関して、この研究では、Transformer に基づく 4M エンコーダ/デコーダ アーキテクチャを採用し、新しいモダリティに適応するためにモーダル エンベディングを追加しています。

このモデルは、DIODE 表面法線と深さの推定、COCO セマンティックとインスタンスのセグメンテーション、3DPW3D 人間の姿勢推定などの一連の一般的な視覚タスクをすぐに実行できるだけでなく、任意のトレーニング モダリティを生成し、いくつかの機能をサポートすることもできます。きめの細かいマルチモーダルな生成が実行され、他のモダリティをクエリとして使用して RGB 画像や他のモダリティを取得できます。さらに研究者らは、NYUv2、Hypersim セマンティック セグメンテーション、ARKitScenes でのマルチモーダル伝送実験も実施しました。

その重要な機能的特徴は次のとおりです。

Any-to-Any モダリティ: 既存の最高の Any-to-Any モデルの 7 つのモダリティから 21 の異なるモダリティに増加し、クロスモーダル検索、制御可能な生成、およびすぐに使用できる強力なパフォーマンスが可能になります。

多様性のサポート: 人間のポーズ、SAM インスタンス、メタデータなど、より構造化されたデータのサポートを追加します。

トークン化: グローバルな画像の埋め込み、人間のポーズ、セマンティック インスタンスなどのモダリティ固有の方法を使用して、さまざまなモダリティの個別のトークン化を研究します。

スケーリング: モデル サイズを 3B パラメーターに拡張し、データセットを 0.5B サンプルに拡張します。

共同トレーニング: 視覚と言語を同時に共同トレーニングします。

論文アドレス: https://arxiv.org/pdf/2406.09406

ハイライト:

- Apple とスイスのローザンヌ工科大学 (EPFL) の研究者は、21 の異なるモダリティでトレーニングできる単一の Any-to-Any モダリティ モデルを共同開発しました。

- このモデルは、すぐに使用できるさまざまな一般的な視覚タスクを実行でき、任意のトレーニング モダリティを生成することもでき、きめの細かいマルチモーダル生成を実行するためのいくつかの方法をサポートします。

- 研究者らは、NYUv2、Hypersim セマンティック セグメンテーション、ARKitScenes に関するマルチモーダル伝送実験も実施しました。

全体として、4M-21 モデルはマルチモーダル研究の分野で大きな進歩を遂げ、その強力なパフォーマンスと幅広い応用の見通しにより、マルチモーダル人工知能の将来の開発に新たな方向性をもたらします。 このモデルのオープンソースと将来のアプリケーションには期待に値します。