南京大学、復旦大学、ファーウェイのノアの方舟研究所の研究チームは、3Dデジタルヒューマンの分野で大きな進歩を遂げ、既存の手法におけるマルチビューの一貫性と感情表現力が不十分であるという問題を解決した。彼らは、制御可能な感情を備えた 3D トーキング アバターの合成を可能にし、口唇同期とレンダリング品質の大幅な向上を実現する新しい方法を開発しました。研究結果は、新たに構築された EmoTalk3D データセットに基づいており、これには調整されたマルチビュー ビデオ、感情的な注釈、フレームごとの 3D 幾何学情報が含まれており、非営利研究目的で公開されています。 「音声から幾何学、外観へ」というマッピングフレームワークにより、この手法は微妙な表情を正確に捉え、自由な視野角で忠実度の高いレンダリングを実現します。

製品入口:https://nju-3dv.github.io/projects/EmoTalk3D/

彼らは、調整されたマルチビュー ビデオ、感情の注釈、フレームごとの 3D ジオメトリを含む EmoTalk3D データセットを収集しました。また、制御可能な感情を持つ 3D トーキング アバターを合成するための新しい方法が提案され、口唇同期とレンダリング品質が大幅に向上しました。

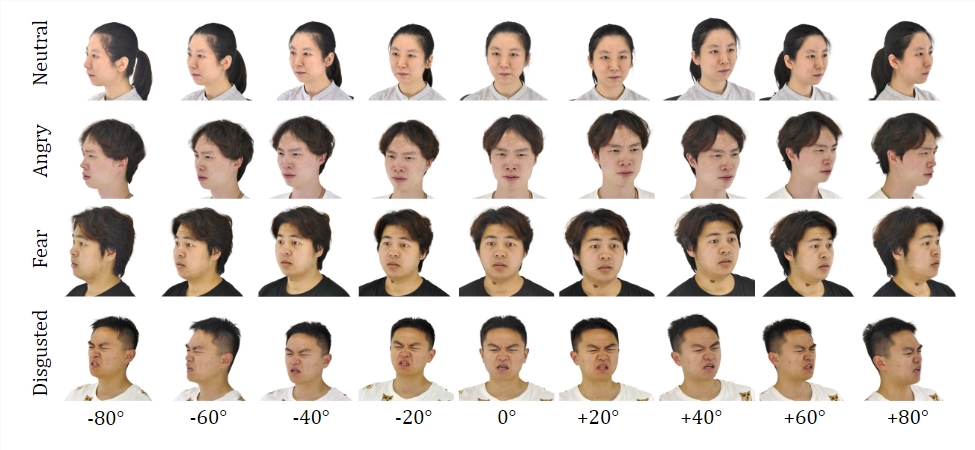

データセット:

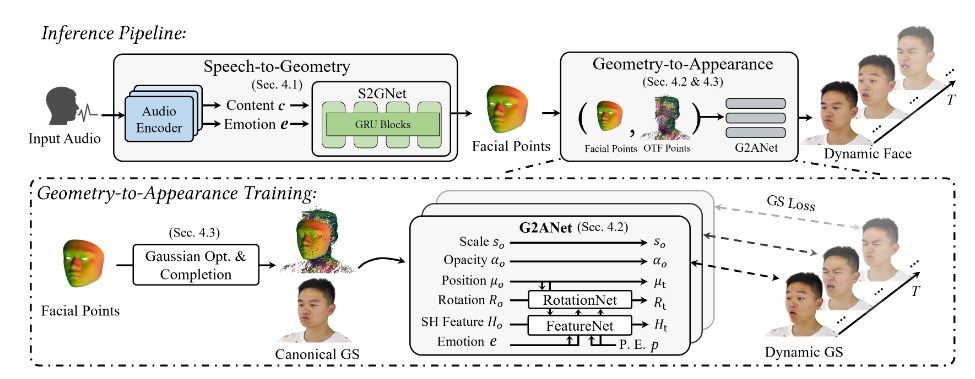

EmoTalk3D データセットでトレーニングすることにより、研究チームは「音声からジオメトリ、外観に至るまで」のマッピング フレームワークを構築しました。現実的な 3D 幾何学的シーケンスが最初にオーディオ特徴から予測され、次に 4D ガウスで表される 3D トーキング ヘッドの外観が、予測された幾何学的形状に基づいて合成されます。外観はさらに標準ガウスとダイナミック ガウスに分解され、マルチビュー ビデオから学習され、フリービュー トーキング ヘッド アニメーションをレンダリングするために融合されます。

このモデルは、生成された会話アバターで制御可能な感情を可能にし、それらを幅広い視野角にわたってレンダリングします。しわや微妙な表情などのダイナミックな顔のディテールをキャプチャしながら、唇の動きの生成におけるレンダリング品質と安定性の向上を実証しました。生成された結果の例では、3D デジタル ヒューマンの喜ぶ、怒る、イライラする表情が正確に表示されています。

そのプロセス全体には 5 つのモジュールが含まれています。

1 つ目は、入力音声からコンテンツと感情的特徴を解析する感情コンテンツ分解エンコーダーです。2 つ目は、特徴から動的 3D 点群を予測する音声変換ネットワークです。3 つ目は、確立するためのガウス最適化および補完モジュールです。 4 番目は、ジオメトリから外観への変換で、動的 3D 点群に基づいて顔の外観を合成します。5 番目は、動的ガウスをフリービュー アニメーションにレンダリングするレンダリング モジュールです。

さらに、フレーム単位の 3D 顔形状を備えた感情注釈付きマルチビュー トーキング ヘッド データセットである EmoTalk3D データセットを構築し、非営利研究目的で一般公開される予定です。

ハイライト:

制御可能な感情を備えたデジタルヒューマンを合成する新しい方法を提案します。

「音声からジオメトリ、外観に至るまで」のマッピング フレームワークを構築します。

EmoTalk3D データ セットが確立され、開く準備ができました。

この研究は、3D デジタル ヒューマン テクノロジーの開発に新たな方向性を与えるものであり、提案された手法とデータ セットは、将来の研究に貴重なリソースを提供し、より現実的で感情表現が豊かな 3D デジタル ヒューマン テクノロジーの開発を促進します。 EmoTalk3D データセットの公開により、学術コミュニティでの協力と交流も促進されます。