Transformer モデルのデコード速度は、常にそのアプリケーションを制限する重要なボトルネックでした。最近、韓国科学技術研究院、LG、DeepMind の研究者らが共同で、ブロック トランスフォーマーと呼ばれる新しいアーキテクチャを提案し、デコード速度を 10 ~ 20 倍も高速化しました。この画期的な開発の中核は、Transformer のアテンション メカニズムの賢い「スライス」にあり、これにより、従来の Transformer の GPU 使用率が低いという問題が効果的に解決され、メモリのオーバーヘッドが大幅に削減されます。

Transformer モデルは強力ですが、デコードの効率が常に悩みの種でした。しかし、韓国科学技術研究院、LG、DeepMind の研究者は、今回私たちに驚きをもたらしました。彼らは、ブロック トランスフォーマーと呼ばれる新しいトランスフォーマー アーキテクチャを提案しました。これにより、デコード速度が 10 ~ 20 倍に直接向上しました。

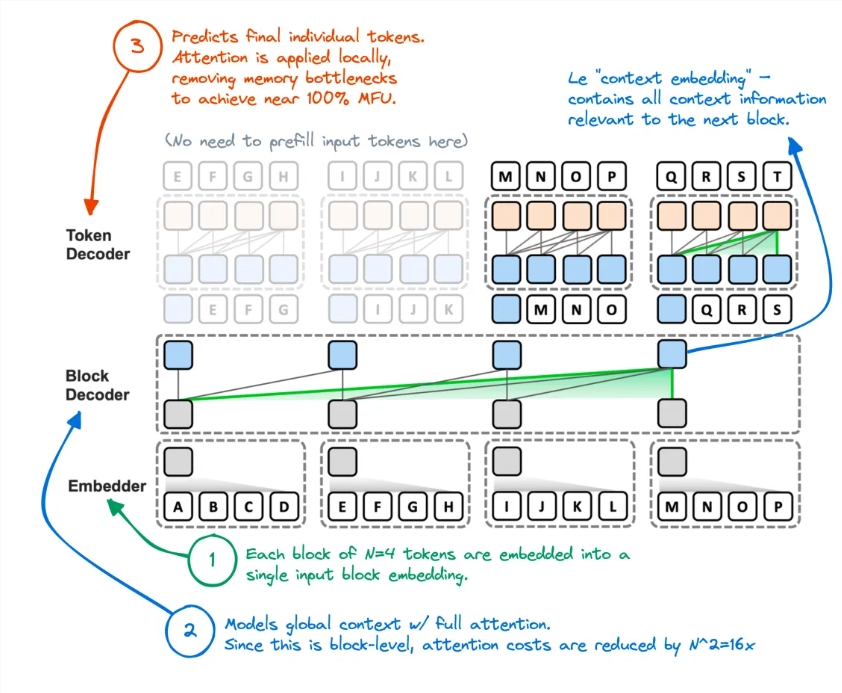

これはどのように行われるのでしょうか? 彼らはトランスフォーマーの注意メカニズムを「切断」していることが判明しました。このようにして、トークンが生成されるたびにグローバル KV キャッシュにアクセスするという元の Transformer の非効率な方法は完全に覆されました。

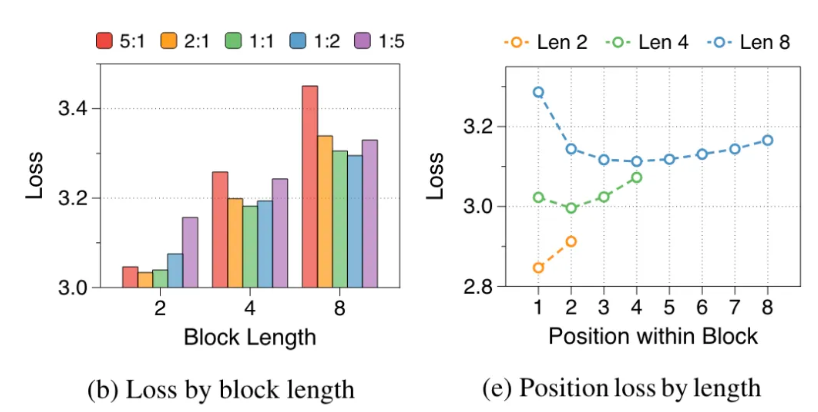

研究者らは、オリジナルの Transformer の欠点を分析しました。GPU の有効利用率は 1% 未満で、残りの 99% はメモリ アクセスに使用されていました。これは明らかに不合理であるため、この新しいアーキテクチャは、ブロックレベルのアテンションとブロック内アテンションの分解を使用して、モデルの推論スループットを直接爆発させることを提案しました。

具体的には、Block Transformer のワークフローは次のとおりです。まずシーケンスをブロックに分割し、次に Embedder を使用して各ブロックを埋め込みベクトルに変換します。ブロック デコーダーは、ブロック埋め込みベクトルの処理とブロック間のグローバル依存関係のキャプチャを担当し、トークン デコーダーはトークン間のローカル依存関係の処理とトークン シーケンスの生成を担当します。

この方法により、推論速度が向上するだけでなく、メモリのオーバーヘッドも大幅に削減されます。一部のネチズンは、以前にも同様のアイデアを持っていたが、結果として得られたモデルのパフォーマンスが不十分だったと述べました。現在、この方法は効果的に KV キャッシュを削減しているようです。

さらに、複数のゼロショット タスクにおけるブロック トランスフォーマーの精度は、同じサイズのオリジナルのトランスフォーマーと同等かわずかに高いため、品質を犠牲にすることなく効率が向上することが証明されています。

この研究の意味はそれだけにとどまりません。また、モデルのトレーニング コストも削減され、世界的に注目される二次メモリ アクセスのオーバーヘッドが 16 分の 1 に削減され、GPU 使用率も 1% から 44% に増加しました。

論文アドレス: https://arxiv.org/abs/2406.02657

Block Transformer の登場により、Transformer モデルのアプリケーションの新たな可能性が広がり、将来的には大規模な言語モデルの効率最適化に対する新たな方向性も提供されました。速度と効率の大幅な向上により、AI技術のさらなる開発と応用が促進されることが期待されます。