中山大学とバイト デジタル ヒューマン チームは、MMTryon と呼ばれる仮想試着フレームワークを共同開発しました。このフレームワークは、衣服の写真と着用方法に関するテキストの説明を入力するだけで、ワンクリックで高品質のモデルの試着効果を生成できます。現実のキャラクターと漫画のキャラクターをサポートし、仮想試着プロセスを大幅に簡素化します。この技術は、従来のアルゴリズムの限界を打ち破り、衣服を細かく分割することなく、複雑な着こなしシーンや任意の服装スタイルを正確に処理することを実現し、効率と利便性を大幅に向上させます。

最近、中山大学と Byte Digital Human チームが MMTryon と呼ばれる仮想試着フレームワークを提案したことが大きなニュースになりました。これは単純ではありません。服の写真を数枚入力し、その着方に関するテキストをいくつか追加するだけで、ワンクリックでモデルの試着効果を生成でき、その品質は非常に高いです。

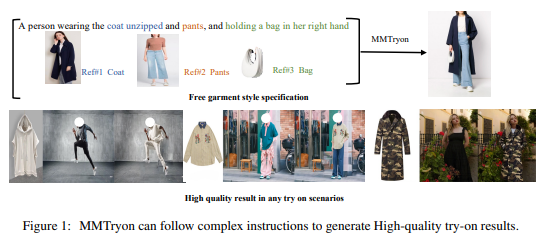

コート、パンツ、バッグを選択し、クリックするだけで自動的にポートレートに配置されると想像してください。実在の人物であろうと漫画のキャラクターであろうと、ワンクリックでそれを行うことができます。この操作はあまりにもクールです。

さらに、MMTryon の力はそれだけではありません。単一画像のドレスアップに関しては、大量のデータを使用して、さまざまな複雑なドレスアップ シーンやあらゆる服装スタイルに対応できる服装エンコーダーを設計します。衣服の変更の組み合わせに関しては、衣服の細かいセグメンテーションに依存する従来のアルゴリズムを打ち破り、テキスト コマンドで実行でき、生成される効果は現実的かつ自然です。

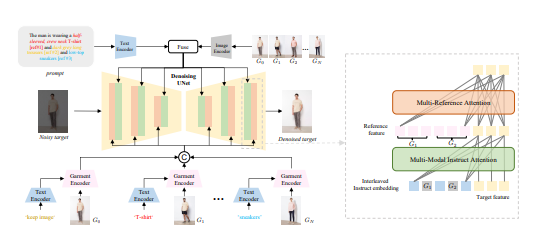

ベンチマークテストではMMTryonが新SOTAに直接勝利しており、この結果は無視できるものではありません。研究チームはまた、ドレッシング効果をより正確かつ柔軟にするために、マルチモーダルなマルチリファレンス・アテンション・メカニズムを開発しました。以前の仮想試着ソリューションでは、1 つのアイテムしか試着できなかったか、服のスタイルについて無力でした。しかし今では、MMTryon がすべてを解決します。

さらに、MMTryon は非常にスマートでもあり、豊富な表現機能を備えた衣服エンコーダと、新しいスケーラブルなデータ生成プロセスを組み合わせて使用するため、服装プロセスはセグメンテーションを必要とせず、テキストと複数のデータを介して直接高レベルのパフォーマンスを実現できます。高品質の仮想ドレスアップ。

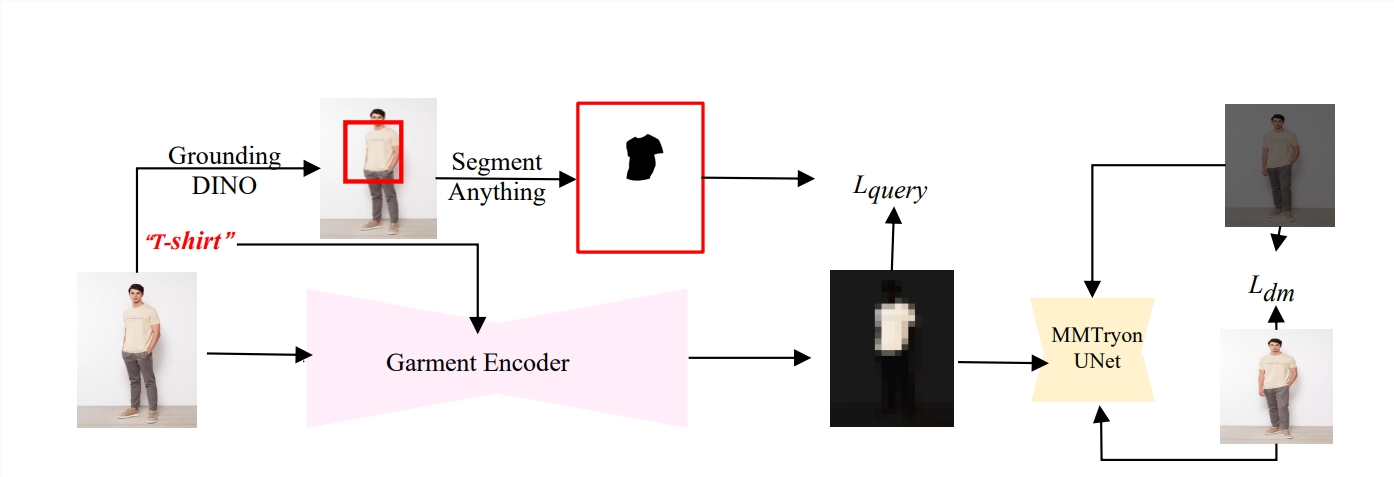

オープンソースのデータセットと複雑なシナリオに関する広範な実験により、MMTryon が既存の SOTA 手法よりも定性的および定量的に優れていることが証明されました。研究チームはまた、テキストをクエリとして使用して、テキストの対応する領域の機能をアクティブにする衣服エンコーダーを事前トレーニングし、衣服のセグメンテーションへの依存を取り除きました。

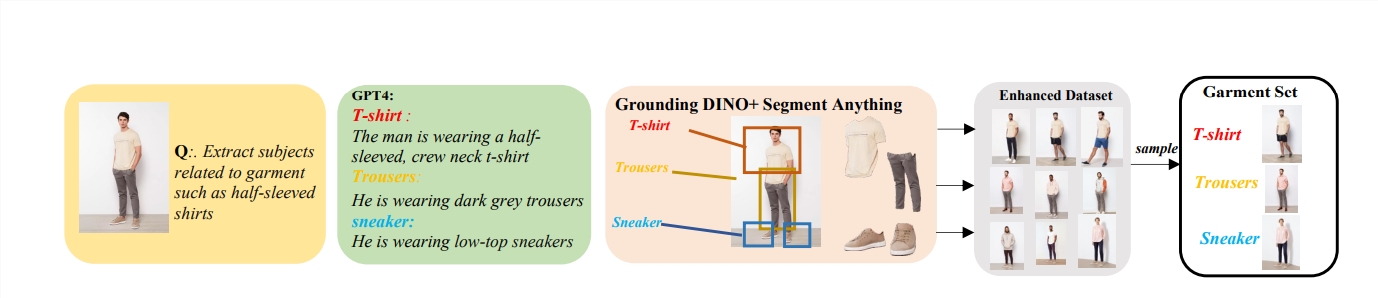

さらにすごいのは、組み合わせた服装の変更をトレーニングするために、研究チームが大規模モデルに基づいたデータ増幅モデルを提案し、100 万件の強化されたデータセットを構築したことで、MMTryon がさまざまな種類の服装の変更について実際の仮想トライアルを実行できるようになったということです。効果。

MMTryon はファッション業界のブラックテクノロジーのようなもので、ワンクリックで服を試着できるだけでなく、服選びをサポートするファッションアシスタントとしても機能します。 MMTryonは、定量的な指標や人間による評価において、他のベースラインモデルを上回り、優れた効果を発揮します。

論文アドレス: https://arxiv.org/abs/2405.00448

全体として、MMTryon は効率的、正確かつ便利な仮想試着機能によりファッション分野で大きな応用可能性を示し、衣料品のデザインとショッピング体験に革命的な変化をもたらしました。その最先端のテクノロジーと優れたパフォーマンスにより、バーチャル試着の分野における新たなベンチマークとなります。