kimi オープン プラットフォームは、待望のコンテキスト キャッシュ機能の内部テストを開始しようとしています。この革新的なテクノロジは、長いテキストの大規模モデルのユーザー エクスペリエンスを大幅に向上させます。コンテキスト キャッシュは、重複したトークン コンテンツをキャッシュすることで、同じコンテンツをリクエストするユーザーのコストを大幅に削減し、API インターフェイスの応答速度を大幅に向上させることができます。これは、大規模で反復性の高いプロンプト シナリオなど、頻繁なリクエストと多数の初期コンテキストへの繰り返しの参照を必要とするアプリケーション シナリオでは特に重要です。

6 月 20 日の ChinaZ.com からのニュース: キミ オープン プラットフォームは最近、待望のコンテキスト キャッシュ機能が間もなく内部テストを開始すると発表しました。この革新的な機能は、長いテキストの大規模なモデルをサポートし、効率的なコンテキスト キャッシュ メカニズムを通じてユーザーに前例のないエクスペリエンスを提供します。

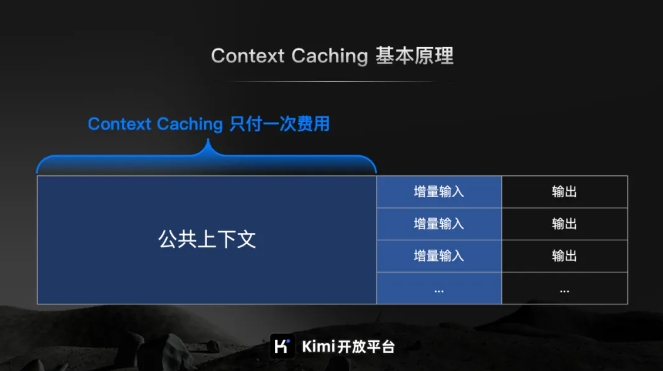

Kim Open Platform の公式紹介によると、Context Caching は、重複した Tokens コンテンツをキャッシュすることで、同じコンテンツをリクエストするユーザーのコストを大幅に削減するように設計された最先端のテクノロジーです。その動作原理は、処理されたテキストの断片をインテリジェントに識別して保存し、ユーザーが再度リクエストすると、システムがそれをキャッシュから迅速に取得できるため、API インターフェイスの応答速度が大幅に向上します。

大規模で反復性の高いプロンプト シナリオの場合、コンテキスト キャッシュ機能の利点は特に重要です。頻繁に発生する大量のリクエストに迅速に対応し、キャッシュされたコンテンツを再利用することでコストを削減しながら、処理効率を大幅に向上させることができます。

コンテキスト キャッシュ機能は、頻繁なリクエストや多数の初期コンテキストへの繰り返しの参照を必要とするアプリケーション シナリオに特に適していることは特に言及する価値があります。この機能により、ユーザーは効率的なコンテキスト キャッシュを簡単に実装できるため、作業効率が向上し、運用コストが削減されます。

コンテキスト キャッシュ機能の内部テストが間もなく開始されます。これは、大規模モデルの効率を向上させ、ユーザーのコストを削減する上で、Kimi オープン プラットフォームが講じた重要な一歩を示すものです。