北京大学は Kuaishou AI チームと協力して、VideoTetris と呼ばれる新しいビデオ生成フレームワークを開発しました。これにより、複雑なビデオ生成の問題の解決に成功し、そのパフォーマンスは Pika や Gen-2 などの商用モデルを上回りました。このフレームワークは、結合されたビデオ生成タスクを革新的に定義し、複雑な命令に従ってビデオを正確に生成でき、長いビデオ生成とプログレッシブなマルチオブジェクト命令をサポートし、複数の命令や詳細を正確に配置するなど、複雑な命令や詳細を処理する際の既存のモデルの欠点を効果的に解決します。オブジェクトとその特徴的な詳細を維持します。

6 月 17 日の ChinaZ.com からのニュース: 北京大学と Kuaishou AI チームが協力して、複雑なビデオ生成の問題を克服することに成功しました。彼らは、さまざまな詳細をパズルのように簡単に組み合わせて、高難易度で複雑な命令を含むビデオを生成できる、VideoTetris と呼ばれる新しいフレームワークを提案しました。このフレームワークは、複雑なビデオ生成タスクにおいて Pika や Gen-2 などの商用モデルを上回ります。

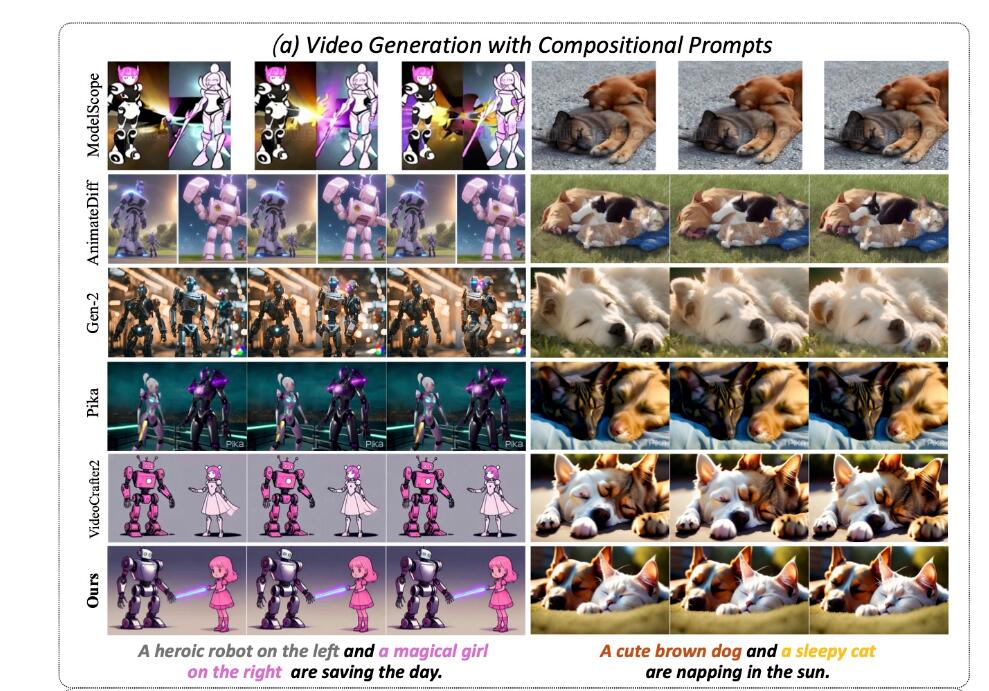

VideoTetris フレームワークは、2 つのサブタスクを含む結合ビデオ生成タスクを初めて定義します: 1) 複雑な結合命令に従うビデオ生成、2) プログレッシブ結合マルチオブジェクト命令に従う長いビデオ生成。チームは、ほとんどすべての既存のオープンソースおよび商用モデルが正しいビデオを生成できないことを発見しました。たとえば、「左側にかわいい茶色の犬、右側に日向で昼寝している昼寝猫」と入力すると、結果として得られるビデオは 2 つのオブジェクトに関する情報が融合され、奇妙に見えることがよくあります。

対照的に、VideoTetris はすべての位置情報と詳細な機能を正常に保持します。長いビデオの生成では、「ヘーゼル ナッツの山の上のかわいい茶色のリスから、ヘーゼル ナッツの山の上のかわいい茶色のリスとかわいい白リスへの移行」など、より複雑な命令がサポートされます。生成されたビデオの順序は入力された指示と一致しており、2 匹のリスは自然に餌を交換できます。

VideoTetris フレームワークは時空間結合拡散法を採用しています。まず、時間に従ってテキスト プロンプトを分解し、異なるビデオ フレームに異なるプロンプト情報を割り当てます。次に、空間次元がフレームごとに分解されて、さまざまなオブジェクトがさまざまなビデオ領域にマッピングされます。最後に、時空間クロスアテンションを通じて効率的な組み合わせ命令の生成が実現されます。

より高品質の長いビデオを生成するために、チームはまた、長いビデオの生成をより動的かつ安定にするための強化されたトレーニング データ前処理方法も提案しました。さらに、参照フレーム アテンション メカニズムが導入され、CLIP エンコーディングを使用する他のモデルとは異なり、ネイティブ VAE を使用して前のフレーム情報をエンコードすることで、コンテンツの一貫性が向上します。

最適化の結果、長いビデオに広範囲の色かぶりがなくなり、複雑な命令にうまく適応できるようになり、生成されたビデオはよりダイナミックでより自然になります。チームはまた、新しい評価指標 VBLIP-VQA および VUnidet を導入し、複合世代の評価方法を初めてビデオの次元に拡張しました。

実験テストによると、ビデオ生成機能を組み合わせた点で、VideoTetris モデルは、Gen-2 や Pika などの商用モデルを含むすべてのオープン ソース モデルよりも優れたパフォーマンスを発揮します。コードは完全にオープンソースになると報告されています。

プロジェクトアドレス: https://top.aibase.com/tool/videotetris

全体として、VideoTetris フレームワークは複雑なビデオ生成の分野で大きな進歩を遂げ、その効率的な時空間結合拡散手法と革新的な評価指標は、将来のビデオ生成技術の開発に新たな方向性を提供します。このプロジェクトのオープンソースは、より多くの研究者に貴重なリソースを提供し、この分野のさらなる発展を促進します。今後、VideoTetris がより多くのアプリケーション シナリオで役割を果たすことができることを楽しみにしています。