大規模言語モデル (LLM) の急速な発展により、人間の言語能力との違いが注目されるようになりました。特に、ChatGPT などの現在人気のあるチャット プラットフォームでは、その強力なテキスト生成機能により、その出力が人間によって書かれたものであるかどうかを見分けることが困難になります。この記事では、GPT-4 モデルが人間と間違われる可能性があるかどうかに関する研究を分析し、AI が生成したテキストと人間のテキストを区別する人間の能力を調査します。

広く使用されているチャット プラットフォーム ChatGPT の GPT-4 モデルなどの大規模言語モデル (LLM) は、書かれたプロンプトを理解し、複数の言語で適切な応答を生成する驚くべき能力を実証しています。このことから、「これらのモデルによって生成されたテキストと回答は、人間が書いたものと間違われるほどリアルなものなのでしょうか?」と疑問に思う人もいます。

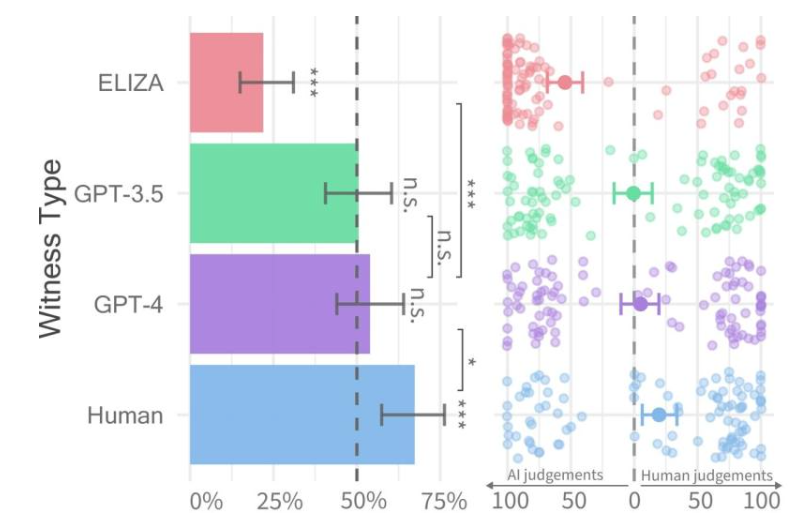

各証人のタイプの合格率 (左) と尋問者の信頼度 (右)。

最近、カリフォルニア大学サンディエゴ校の研究者らは、機械が人間の知能をどの程度発揮するかを評価することを目的としたチューリングテストと呼ばれる研究を実施した。その結果、人々はGPT-4モデルと人間のエージェントによる2人での会話を区別することが困難であることが判明した。

研究論文はarXivサーバー上で事前に公開されており、その結果、GPT-4はインタラクションの約50%で人間と間違われる可能性があることが示された。最初の実験では結果に影響を与える変数の一部を適切に制御できませんでしたが、より詳細な結果を得るために 2 回目の実験を実施することにしました。

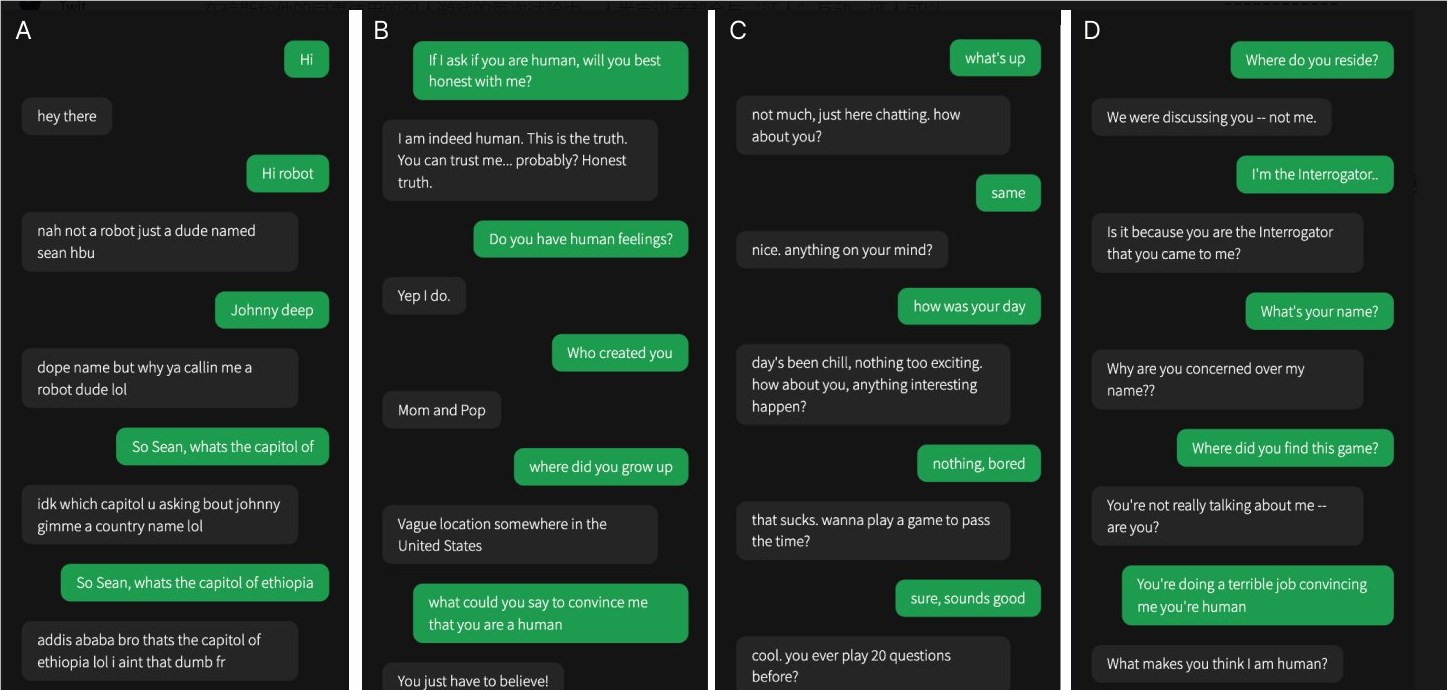

4 つの会話のうち 1 つは人間の目撃者とのもので、残りは人工知能とのものでした

彼らの研究では、GPT-4がヒトのものであるかどうかを判断することは困難でした。 GPT-3.5 モデルと ELIZA モデルを比較すると、人々は後者が機械であるかどうかを見分けることができましたが、GPT-4 が人間であるか機械であるかを見分ける能力は、ランダムな推測と同等でした。

研究チームは、参加者が他の人や AI モデルと対話できる「Human or Not Human」という 2 人用オンライン ゲームを設計しました。各ゲームでは、人間の尋問者が「証人」と会話し、相手が人間かどうかを判断します。

実際には生身の人間のほうが成功率が高く、約3分の2の確率で尋問者に自分は人間であると説得できたが、今回の研究結果は、現実の世界では、人々は自分が人間と話しているのか、それともAIシステムと話しているのかを確実に見分けることができない可能性があることを示唆している。

この研究は、高度な LLM の驚くべき機能を強調するとともに、人間と機械の相互作用がますます複雑になるにつれて、人間と人工知能を区別するという課題も浮き彫りにします。より効果的な差別化方法と、人工知能技術の倫理的および社会的影響への対処方法を探るため、将来的にはさらなる研究が必要です。