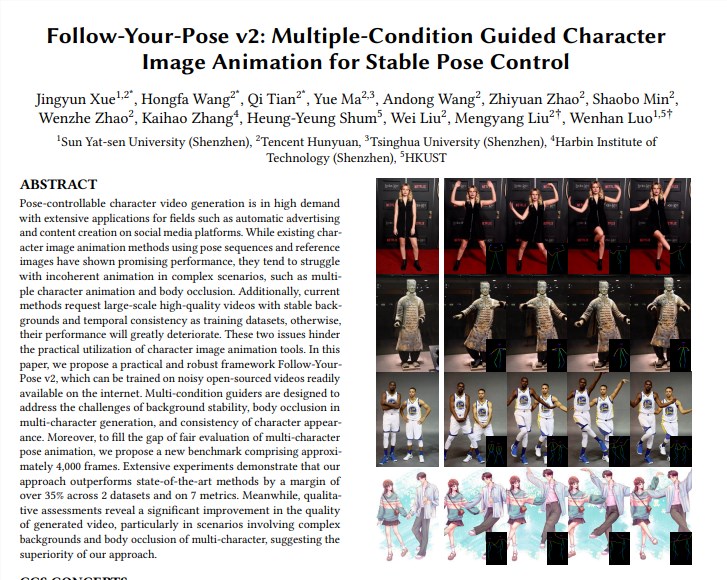

Tencent Hunyuan チームは中山大学および香港科技大学と協力して新しい Tusheng ビデオ モデル「Follow-Your-Pose-v2」を発表し、一人から複数人へのビデオ生成技術のブレークスルーを達成しました。このモデルは、複数人の集合写真を処理し、生成されたビデオ内で写真内の人物を同時に動かすことができるため、ビデオ生成の効率と品質が大幅に向上します。このテクノロジーのハイライトは、複数人のビデオ アクションの生成をサポートし、強力な汎化機能を備え、日常生活の写真/ビデオを使用してトレーニングおよび生成でき、キャラクター オクルージョンなどの問題を正しく処理できることです。このモデルは、複数のデータセットに対して既存の手法を上回っており、その強力なパフォーマンスと広範なアプリケーションの見通しを示しています。

複数人のビデオ アクションの生成をサポート: より少ない時間の推論で複数人のビデオ アクションの生成を実現します。

強力な一般化能力: 年齢、服装、人種、背景の乱雑さ、アクションの複雑さに関係なく、高品質のビデオを生成できます。

日常生活の写真/ビデオが利用可能: モデルのトレーニングと生成では、高品質の写真/ビデオを探すことなく、日常生活の写真 (スナップショットを含む) またはビデオを使用できます。

キャラクター オクルージョンを正しく処理: 1 つの画像内で複数のキャラクターの体が互いにブロックし合うという問題に直面しても、正しい前後関係を持つオクルージョン画像を生成できます。

技術的な実装:

「オプティカルフローガイド」を用いて背景のオプティカルフロー情報を導入することで、手ブレや背景が不安定な場合でも安定した背景アニメーションを生成することができます。

「推論マップガイド」と「深度マップガイド」を通じて、モデルは写真内のキャラクターの空間情報と複数のキャラクターの空間的位置関係をよりよく理解し、マルチキャラクターアニメーションとボディオクルージョンの問題を効果的に解決できます。 。

評価と比較:

チームは、マルチキャラクター生成の効果を評価するために、約 4,000 フレームのマルチキャラクター ビデオを含む新しいベンチマーク マルチキャラクターを提案しました。

実験の結果、「Follow-Your-Pose-v2」は、2つの公開データセット(TikTokとTEDのスピーチ)と7つの指標において、最先端のものよりも35%以上優れていることが示されました。

アプリケーションの見通し:

画像からビデオの生成技術は、映画コンテンツ制作、拡張現実、ゲーム制作、広告など、多くの業界で幅広い応用が期待されており、2024年に大きな注目を集めるAI技術の1つです。

追加情報:

Tencent の Hunyuan チームは、Vincentian グラフの大規模なオープンソース モデル (Hunyuan DiT) の高速化ライブラリも発表しました。これにより、推論効率が大幅に向上し、グラフの生成時間が 75% 短縮されます。

Hunyuan DiT モデルを使用するための敷居が低くなり、ユーザーは 3 行のコードで Hugging Face の公式モデル ライブラリ内のモデルを呼び出すことができます。

論文アドレス: https://arxiv.org/pdf/2406.03035

プロジェクトページ:https://top.aibase.com/tool/follow-your-pose

「Follow-Your-Pose-v2」モデルの登場は、Tusheng のビデオ技術における大きな進歩を示しており、多くの分野での応用の可能性が期待されています。将来的には、技術の継続的な開発と改善により、このモデルはより多くのシナリオで重要な役割を果たし、人々により便利でインテリジェントなビデオ生成体験をもたらすと考えられています。