マルチモーダル大規模言語モデル (MLLM) の急速な発展に伴い、視覚、言語、および音声モダリティの効果的な統合が研究のホットスポットになっています。しかし、視覚の空間情報や音声の時系列情報など、さまざまなモーダル データの本質的な違いによってもたらされる課題が、効率的なマルチモーダル インタラクションを妨げています。既存の方法は独立した ASR および TTS モジュールに依存することが多く、これにより待ち時間が増加し、対話のスムーズさが低下します。本稿では、これらの問題の解決を目的とした、視覚、言語、音声を統合したマルチモーダル大規模言語モデル VITA-1.5 を紹介します。

最近、マルチモーダル大規模言語モデル (MLLM)、特にビジュアル モダリティとテキスト モダリティの統合において大きな進歩が見られました。しかし、人間とコンピュータの対話の人気が高まるにつれて、特にマルチモーダル対話システムにおいて、音声モダリティの重要性がますます顕著になってきています。音声は情報伝達の重要なメディアであるだけでなく、インタラクションの自然さと利便性を大幅に向上させます。

ただし、視覚データと音声データの間には本質的な違いがあるため、それらを MLLM に統合することは簡単ではありません。たとえば、視覚データは空間情報を伝えますが、音声データは時系列での動的な変化を伝えます。これらの基本的な違いは、2 つのモダリティの同時最適化に課題をもたらし、多くの場合、トレーニング プロセス中に競合が発生します。さらに、従来の音声合成システムは、個別の自動音声認識 (ASR) モジュールとテキスト読み上げ (TTS) モジュールに依存しているため、遅延が増加し、一貫性が低下し、リアルタイム アプリケーションでの有用性が制限されます。

これらの課題に対処するために、研究者らは、視覚、言語、音声を統合するマルチモーダル大規模言語モデルである VITA-1.5 を立ち上げました。 VITA-1.5 は、慎重に設計された 3 段階のトレーニング方法を使用して、強力なマルチモーダル パフォーマンスを維持しながらモーダルの競合を軽減するために視覚データと音声データを徐々に導入します。

最初の段階では、モデルは視覚言語トレーニングに焦点を当て、視覚アダプターをトレーニングすることで強力な視覚機能を構築し、説明キャプションと視覚的な質問と回答のデータを使用してモデルを微調整します。

第 2 段階では、音声文字起こしのペア データを使用してオーディオ エンコーダーをトレーニングし、音声の質問と回答のデータを使用して微調整することによって、音声入力処理を導入します。これにより、モデルが音声入力を効果的に理解して応答できるようになります。最後に、第 3 段階では、外部 TTS モジュールを必要とせずにエンドツーエンドの音声出力を実現するようにオーディオ デコーダーがトレーニングされます。これにより、VITA-1.5 がスムーズな音声応答を生成し、マルチモーダルな対話の自然さと双方向性を強化できるようになります。システム。

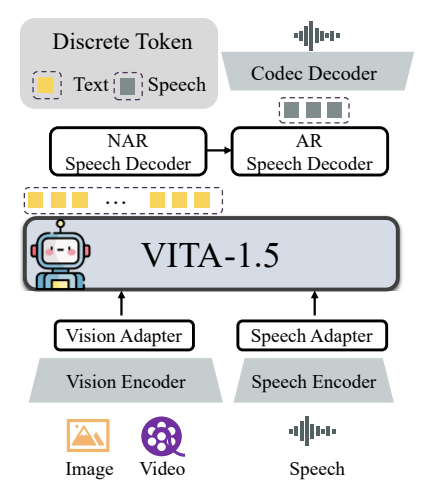

VITA-1.5 の全体的なアーキテクチャには、大規模な言語モデルに接続するためのビジュアルおよびオーディオ エンコーダとアダプタが含まれています。出力には、オリジナルの VITA-1.0 バージョンのような外部 TTS モデルを使用する代わりに、エンドツーエンドの音声生成モジュールが含まれています。ビジュアル エンコーダは InternViT-300M を使用し、入力画像サイズは 448×448 ピクセルで、各画像は 256 個のビジュアル トークンを生成します。

高解像度画像の場合、VITA-1.5 は動的パッチ戦略を採用して局所的な詳細をキャプチャします。ビデオは、ビデオの長さに基づいてフレームがサンプリングされる特別なマルチイメージ入力タイプとして扱われます。オーディオ コーディング モジュールは、複数のダウンサンプリング畳み込みレイヤーと 24 個の Transformer ブロックで構成され、出力フレーム レートは 12.5 Hz です。オーディオ アダプターは、2 倍のダウンサンプリングを備えた複数の畳み込みレイヤーで構成されます。 TiCodec がコーデック モデルとして使用されており、連続音声信号を周波数 40 Hz の離散音声トークンにエンコードし、それらをサンプリング レート 24,000 Hz の音声信号にデコードできます。モデルが音声トークンを出力できるようにするために、テキスト トークンの後に、非自己回帰 (NAR) 音声デコーダーと自己回帰 (AR) 音声デコーダーの 2 つの音声デコーダーが追加されます。

VITA-1.5の学習データは、中国語や英語をはじめ、字幕データや質疑応答データなど多岐にわたります。さまざまなトレーニング段階で、さまざまな目標を達成するためにデータセット全体のサブセットが選択的にサンプリングされます。トレーニング戦略は 3 つの段階で実行されます。

第 1 段階: 視覚的調整、視覚的理解、視覚的教師付き微調整などの視覚言語トレーニングは、視覚と言語の間のギャップを埋め、モデルが画像コンテンツを理解し、視覚的な質問に答えられるようにすることを目的としています。

フェーズ 2: オーディオ調整やオーディオ監視付き微調整などのオーディオ入力チューニングは、モデルがオーディオ入力を理解し、音声質問とテキスト回答を通じて対話できるように設計されています。

第 3 段階: コーデック トレーニングや NAR + AR デコーダー トレーニングを含むオーディオ出力チューニングは、モデルが音声出力を生成し、エンドツーエンドの音声インタラクションを実現できるように設計されています。

研究者らは、画像、ビデオ、音声理解に関するさまざまなベンチマークで広範な評価を実施し、その結果をオープンソースおよび独自のモデルと比較しました。結果は、VITA-1.5 が画像およびビデオのタスクに関して主要な MLLM に匹敵する認識能力と推論能力を示し、音声能力の大幅な向上を達成していることを示しています。たとえば、画像理解ベンチマークでは、VITA-1.5 は最先端のオープン ソース モデルと同等のパフォーマンスを示し、一部のクローズド ソース モデルをも上回っています。ビデオの理解という点では、VITA-1.5 はトップのオープンソース モデルと同等のパフォーマンスを発揮します。さらに、VITA-1.5 は中国語と英語の両方の ASR タスクで優れた精度を達成し、プロの音声モデルを上回りました。

全体として、VITA-1.5 は、慎重に設計された 3 段階のトレーニング戦略を通じて視覚と音声を統合することに成功し、強力な視覚および音声理解機能を実現し、個別の ASR または TTS モジュールに依存することなく効率的な音声間の対話を可能にします。この研究は、リアルタイムマルチモーダルインタラクションの分野におけるオープンソースモデルの進歩を促進することが期待されています。

プロジェクトアドレス: https://github.com/VITA-MLLM/VITA

VITA-1.5 の登場は、マルチモーダル大規模言語モデルの開発における新たな段階を示し、そのエンドツーエンドの音声生成機能と、画像、ビデオ、および音声理解タスクにおける優れたパフォーマンスにより、より自然でスムーズな言語モデルが構築されます。将来のマルチモーダル言語モデルは、新しい可能性を提供します。 この研究成果は注目に値し、実用化に向けて重要な役割を果たすことが期待されます。