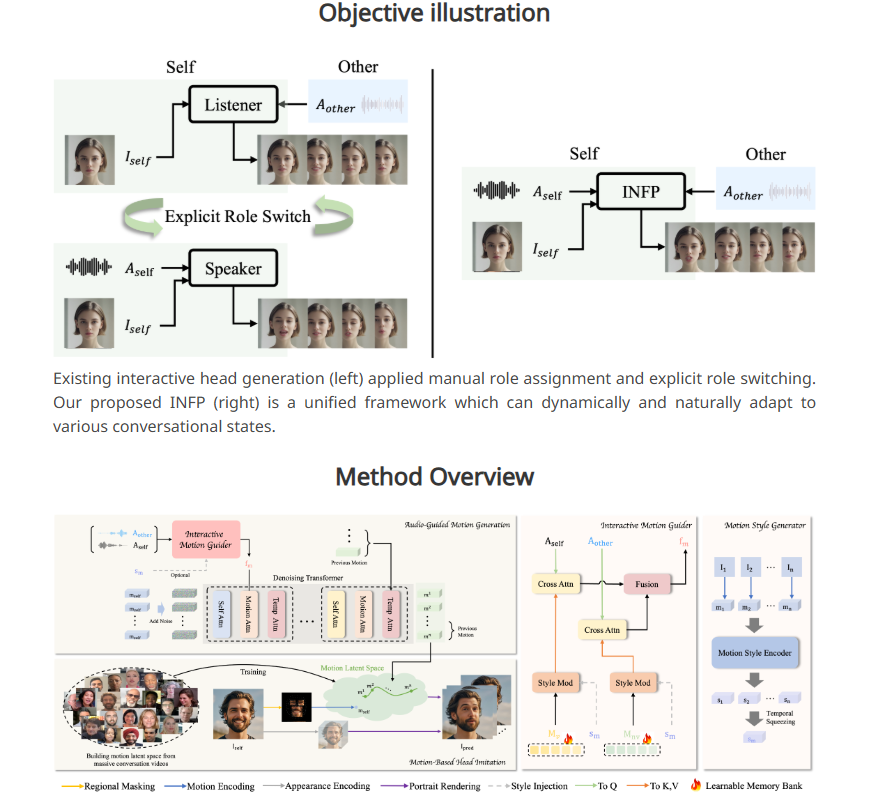

ByteDance は、静止したポートレート写真が音声入力を通じて「話し」、反応できるようにする新しい AI システム INFP を発表しました。 INFPは従来の技術のように手動で役割を指定する必要がなく、会話に基づいてシステムが自動的に判断するため、効率と利便性が大幅に向上します。そのコア技術は、「モーションベースの頭部模倣」と「音声ガイドによるモーション生成」の 2 つのステップにあり、顔の表情、頭の動き、会話中の音声入力を分析することで、静止画を表現するための自然で滑らかなモーション パターンを生成します。人生へ。 INFP をトレーニングするために、ByteDance はシステムの高品質出力を保証するために 200 時間以上の実際の会話ビデオを含む DyConv データセットも構築しました。

INFP のワークフローには 2 つの主なステップがあります。 「モーションベースの頭部模倣」と呼ばれる最初のステップでは、システムは会話中の人々の顔の表情と頭の動きを分析することでビデオから詳細を抽出します。このモーション データは、後続のアニメーションで使用できる形式に変換され、元のキャラクターのモーションに静止画を一致させることができます。

2 番目のステップは「音声ガイド付き動作生成」で、システムは音声入力に基づいて自然な動作パターンを生成します。研究チームは、会話中の双方の音声を分析し、話すときと聞くときの動作パターンを作成する「モーションガイド」を開発した。その後、拡散トランスフォーマーと呼ばれる AI コンポーネントがこれらのパターンを段階的に最適化し、オーディオ コンテンツに完全に一致するスムーズでリアルなモーションを実現します。

システムを効果的にトレーニングするために、研究チームは、200 時間以上の実際の対話ビデオを収集した DyConv と呼ばれる対話データセットも確立しました。 ViCo や RealTalk などの既存の会話データベースと比較して、DyConv は感情表現とビデオ品質において独自の利点を持っています。

ByteDanceによると、INFPはいくつかの重要な分野、特に唇の動きと音声の一致、個々の顔の特徴の保存、多様な自然な動きの作成において既存のツールよりも優れているという。さらに、このシステムは、対話者のみが聞こえるビデオを生成する場合にも同様に良好に機能しました。

INFP は現在音声入力のみをサポートしていますが、研究チームはこのシステムを画像とテキストに拡張する可能性を検討しており、将来の目標はキャラクターの全身のリアルなアニメーションを作成できるようにすることです。しかし、この種の技術がフェイクビデオの作成や誤った情報の拡散に使用される可能性があることを考慮し、研究チームはマイクロソフトによる高度な音声クローンシステムの管理と同様に、中核技術の使用を研究機関に限定する予定だ。

このテクノロジーは、ByteDance の広範な AI 戦略の一部であり、人気のあるアプリケーションである TikTok と CapCut を利用して、ByteDance は広範な AI 革新的なアプリケーション プラットフォームを備えています。

プロジェクト入口: https://grisoon.github.io/INFP/

ハイライト:

INFP では、静止ポートレートが音声を通じて「話す」ことができ、対話の役割を自動的に決定できます。

このシステムは 2 つのステップで動作します。1 つ目は人間の会話から動きの詳細を抽出し、2 つ目は音声を自然な動きのパターンに変換します。

ByteDance の DyConv データ セットには、システム パフォーマンスの向上に役立つ 200 時間以上の高品質の会話ビデオが含まれています。

INFP システムの開始は、人工知能の分野における ByteDance の革新的な強みを示しています。その将来の発展の可能性は大きいですが、潜在的な倫理的リスクにも慎重に対処する必要があります。 テクノロジーの進歩は常に社会的利益を重視し、人類に利益をもたらすために確実に利用されるべきです。