ByteDance がリリースした最新の LatentSync リップシンク フレームワークは、安定拡散に基づくオーディオ条件付き潜在拡散モデルを使用して、より正確かつ効率的なリップシンク効果を実現します。以前の方法とは異なり、LatentSync はエンドツーエンドのアプローチを採用し、中間のモーション表現を必要とせずにオーディオとビジョンの間の複雑な関係を直接モデル化し、処理効率と同期精度を大幅に向上させます。このフレームワークは、音声の埋め込みに Whisper を巧みに使用し、それを TREPA メカニズムと組み合わせて時間的一貫性を強化し、リップシンクの精度を維持しながら、出力ビデオが時間的一貫性を維持することを保証します。

最近、ByteDance は、LatentSync と呼ばれる新しいリップシンク フレームワークをリリースしました。これは、オーディオ状態の潜在拡散モデルを使用して、より正確なリップシンクを実現することを目的としています。このフレームワークは安定拡散に基づいており、時間の一貫性を考慮して最適化されています。

ピクセルの空間拡散や 2 段階の生成に基づく以前の方法とは異なり、LatentSync は中間のモーション表現を必要としないエンドツーエンドのアプローチを採用し、複雑なオーディオとビジュアルの関係を直接モデル化できます。

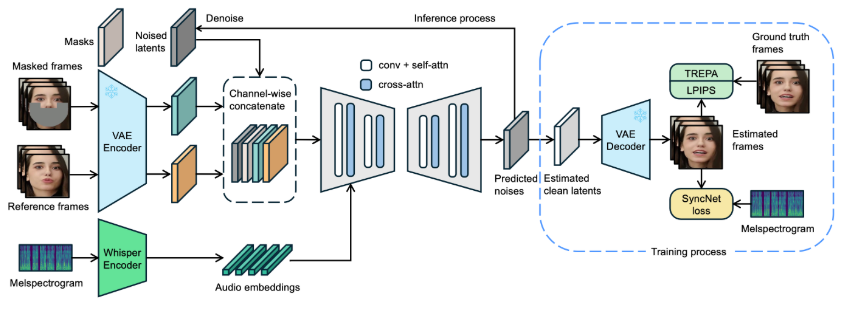

LatentSync のフレームワークでは、Whisper は最初にオーディオ スペクトログラムをオーディオ埋め込みに変換するために使用され、クロス アテンション レイヤーを通じて U-Net モデルに統合されます。このフレームワークは、U-Net への入力としてノイズ潜在変数を使用して、参照フレームとマスク フレームのチャネルレベルの連結を実行します。

トレーニング中に、ワンステップ アプローチを使用して予測ノイズからクリーンな潜在変数を推定し、デコードしてクリーンなフレームを生成します。同時に、このモデルには時間的一貫性を強化するための Temporal REPresentation Alignment (TREPA) メカニズムが導入されており、生成されたビデオが口唇同期の精度を維持しながら時間的一貫性を維持できるようになります。

このテクノロジーの有効性を実証するために、プロジェクトでは、オリジナルのビデオとリップシンクされたビデオを示す一連のサンプルビデオを提供しています。ユーザーは、ビデオリップシンクにおける LatentSync の大幅な進歩を、例を通じて直感的に感じることができます。

元のビデオ:

出力ビデオ:

さらに、このプロジェクトでは、ユーザーのトレーニングとテストを容易にするために、推論コードとチェックポイントをオープンソースにすることも計画しています。推論を試してみたいユーザーは、必要なモデル重みファイルをダウンロードするだけで準備完了です。完全なデータ処理プロセスも設計されており、ビデオ ファイルの処理から顔の位置調整までのすべてのステップをカバーしており、ユーザーが簡単に始めることができます。

モデルプロジェクトの入り口: https://github.com/bytedance/LatentSync

ハイライト:

LatentSync は、中間のモーション表現を必要としない、オーディオ条件付き潜在拡散モデルに基づくエンドツーポート同期フレームワークです。

このフレームワークは Whisper を利用してオーディオ スペクトログラムをエンベディングに変換し、リップ シンク中のモデルの精度と時間的一貫性を向上させます。

このプロジェクトでは一連のサンプルビデオを提供しており、ユーザーの使用とトレーニングを容易にするために、関連するコードとデータ処理プロセスをオープンソースにする予定です。

LatentSync のオープンソースと使いやすさは、リップシンク技術のさらなる開発と応用を促進し、ビデオ編集とコンテンツ作成の分野に新たな可能性をもたらします。 さらなる驚きをもたらすこのプロジェクトの今後のアップデートを楽しみにしています。