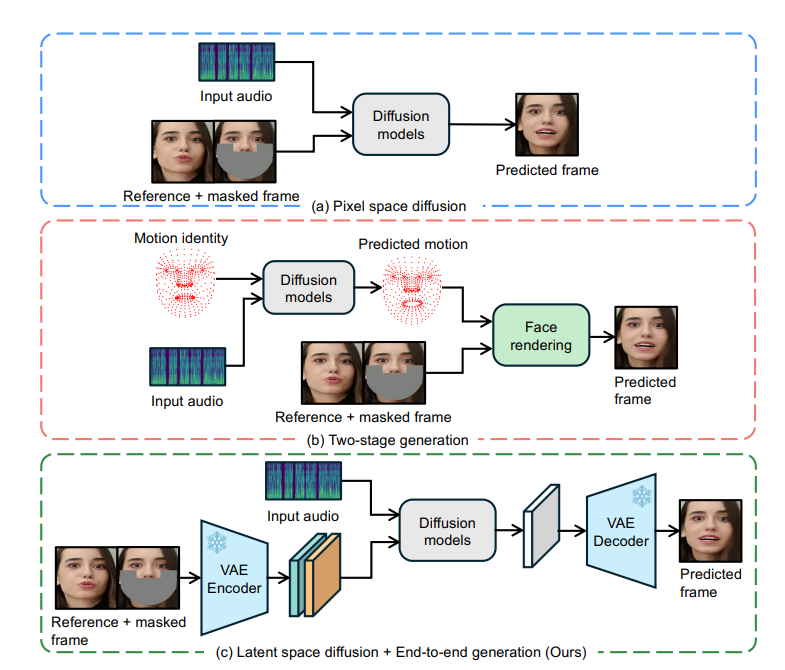

ByteDance は、LatentSync と呼ばれる革新的なリップ同期テクノロジーをオープンソース化しました。これは、音声条件の潜在拡散モデルに基づいており、ビデオ内のキャラクターの唇の動きと音声の正確な同期を実現します。中間のモーション表現を必要とせずに安定拡散の力を直接利用し、複雑なオーディオとビジュアルの関連性を効果的にモデル化し、Temporal Representation Alignment (TREPA) テクノロジーによって時間的一貫性を強化します。 LatentSync は、SyncNet の収束問題も最適化し、リップシンクの精度を大幅に向上させます。このテクノロジーは、エンドツーエンドのフレームワーク、高品質の生成、時間的一貫性、SyncNet の最適化において大きな利点があり、オーディオ駆動のポートレート アニメーションに新しいソリューションを提供します。

拡散ベースのリップシンク方法は、異なるフレーム間の拡散プロセスに不一致があるため、時間的一貫性の点でパフォーマンスが低いことがわかりました。この問題を解決するために、LatentSync は Time Representation Alignment (TREPA) テクノロジーを導入しました。 TREPA は、大規模な自己教師ありビデオ モデルから抽出された時間表現を活用して、生成されたフレームを実際のフレームと位置合わせすることで、リップ シンクの精度を維持しながら時間的な一貫性を高めます。

さらに、研究チームは SyncNet の収束問題についても詳細な調査を実施し、多数の実証研究を通じて、モデル アーキテクチャ、トレーニング ハイパーパラメータ、データ前処理方法など、SyncNet の収束に影響を与える重要な要素を特定しました。これらの要素を最適化することで、HDTF テスト セットに対する SyncNet の精度が 91% から 94% に大幅に向上しました。 SyncNet の全体的なトレーニング フレームワークは変更されていないため、この経験は、SyncNet を利用した他のリップ シンクやオーディオ駆動のポートレート アニメーション方法にも適用できます。

LatentSync の利点

エンドツーエンドのフレームワーク: 中間のモーション表現を使用せずに、同期した唇の動きをオーディオから直接生成します。

高品質の生成: 安定した拡散の強力な機能を使用して、ダイナミックでリアルなスピーキング ビデオを生成します。

時間的一貫性: TREPA テクノロジーを通じてビデオ フレーム間の時間的一貫性を強化します。

SyncNet の最適化: SyncNet の収束問題を解決し、リップ シンクの精度を大幅に向上させます。

動作原理

LatentSync の中核は、画像間の修復技術に基づいており、マスクされた画像を参照として入力する必要があります。元のビデオの顔の視覚的特徴を統合するために、モデルは参照画像も入力します。チャネル スプライシングの後、これらの入力情報は処理のために U-Net ネットワークに入力されます。

このモデルは、事前トレーニングされたオーディオ特徴抽出器 Whisper を使用してオーディオの埋め込みを抽出します。唇の動きは周囲のフレームの音声の影響を受ける可能性があるため、モデルは複数の周囲のフレームの音声を入力としてバンドルして、より多くの時間情報を提供します。オーディオの埋め込みは、クロスアテンション レイヤーを通じて U-Net に統合されます。

SyncNet が画像空間入力を必要とするという問題を解決するために、モデルは最初にノイズの多い空間で予測し、次に単一ステップの方法で推定されたクリーンな潜在空間を取得します。この研究では、ピクセル空間での SyncNet のトレーニングが潜在空間でのトレーニングよりも優れていることがわかりました。これは、VAE エンコード中に唇領域の情報が失われるためである可能性があります。

トレーニング プロセスは 2 つの段階に分かれています。最初の段階では、U-Net はピクセル空間デコードなしで視覚的特徴を学習し、SyncNet 損失を追加します。第 2 段階では、デコードされたピクセル空間監視方法を使用して SyncNet 損失を追加し、LPIPS 損失を使用して画像の視覚的品質を向上させます。モデルが時間情報を正しく学習できるようにするには、入力ノイズも時間的に一貫している必要があり、モデルは混合ノイズ モデルを使用します。さらに、データの前処理段階では、顔の正面化を実現するためにアフィン変換も使用されます。

トレパ技術

TREPA は、生成された画像シーケンスと実際の画像シーケンスの時間表現を調整することにより、時間的一貫性を向上させます。この方法では、大規模な自己教師ありビデオ モデル VideoMAE-v2 を使用して時間表現を抽出します。画像間の距離損失のみを使用する方法とは異なり、時間表現は画像シーケンスの時間的相関を捉えることができるため、TREPA はリップシンクの精度を損なわないだけでなく、実際に向上させることができることが研究でわかっています。

SyncNet コンバージェンスの問題

研究によると、SyncNet のトレーニング損失は 0.69 付近に留まる傾向があり、これ以上減らすことはできないことがわかっています。研究チームは、広範な実験分析を通じて、バッチ サイズ、入力フレーム数、データ前処理方法が SyncNet の収束に大きな影響を与えることを発見しました。モデル アーキテクチャも収束に影響しますが、程度は低いです。

実験結果は、LatentSync が複数の指標において他の最先端のリップシンク手法よりも優れていることを示しています。特にリップシンクの精度に関しては、最適化された SyncNet とオーディオ クロス アテンション レイヤーのおかげで、オーディオと唇の動きの関係をより適切に捉えることができます。さらに、LatentSync の時間の一貫性は、TREPA テクノロジーのおかげで大幅に向上しました。

プロジェクトアドレス: https://github.com/bytedance/LatentSync

LatentSync のオープンソースは、リップシンク技術の開発に新たなブレークスルーをもたらし、その効率的で正確なパフォーマンスと最適化されたトレーニング方法は研究と応用の価値があります。今後、この技術は映像制作やVRなどの分野での活躍が期待されています。