Alibaba Damo Academy の研究チームは、NeurIPS 2024 カンファレンスで「SHMT: Self-supervised Hierarchical Makeup Transfer」というタイトルの論文を発表し、この研究は新しいメイクアップ効果転写技術を提案しました。この技術は、潜在拡散モデルを利用してメイクアップ画像を正確に生成する技術であり、メイクアップ用途や画像処理の分野で大きな応用が期待されています。 SHMT モデルは、メイクアップ効果をターゲットの顔に転送するために、メイクアップ参照画像とターゲット人物の写真のみを必要とし、メイクアップ効果の編集と適用プロセスを大幅に簡素化します。研究者によるさらなる研究開発を促進するために、チームはトレーニング コード、テスト コード、および事前トレーニングされたモデルをオープンソース化しました。

最近、アリババダモアカデミーの研究チームは「SHMT:自己教師付き階層メイクアップ転送」と呼ばれる重要な研究成果を発表し、その論文がトップ国際学会NeurIPS2024に採択されました。本研究では、潜在拡散モデル(潜在拡散モデル)を用いて正確なメイクアップ画像の生成を実現する新しいメイクアップ効果転写技術を実証し、メイクアップ応用と画像処理の分野に新たな活力を吹き込みます。

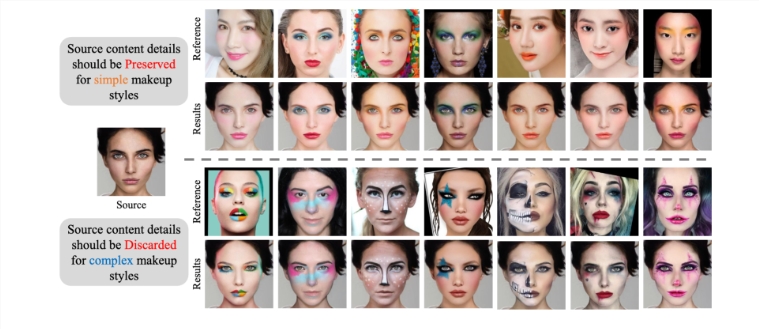

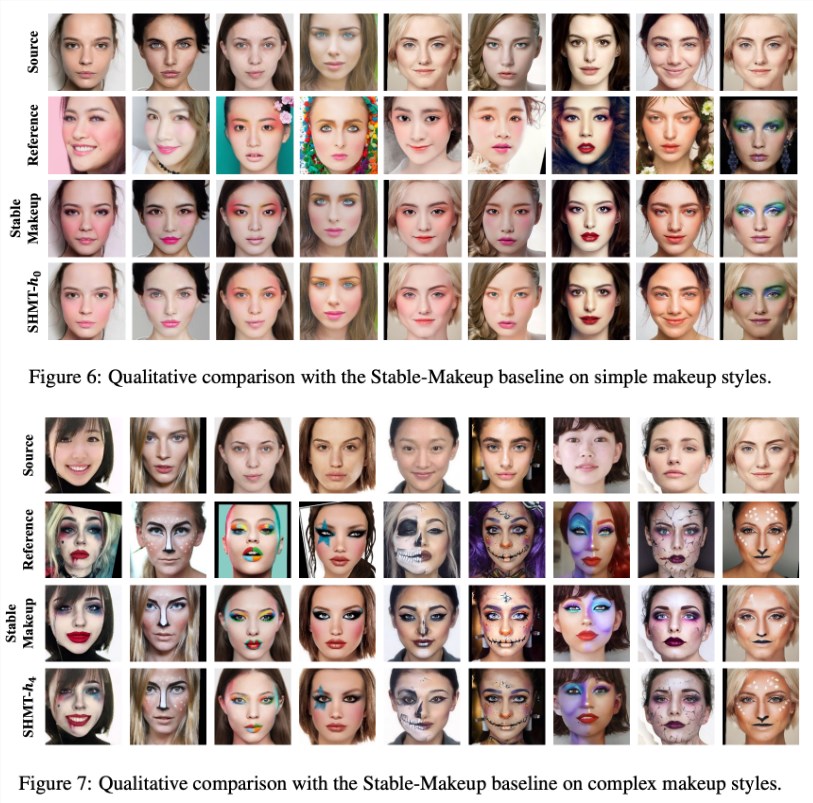

SHMTは、簡単に言うと、メイク参考画像と対象キャラクターの写真さえあれば、対象の顔にメイク効果を転写できる技術です。

チームはプロジェクトにオープンソースのアプローチを採用し、トレーニング コード、テスト コード、事前トレーニング モデルをリリースし、研究者が関連する研究開発を容易に行えるようにしました。

モデル構築プロセス中に、チームはユーザーに「ldm」という名前の conda 環境を作成し、提供された環境ファイルを通じてセットアップを迅速に完了することを推奨します。さらに、調査では VQ-f4 が事前トレーニングされた自動エンコーディング モデルとして選択されました。推論をスムーズに開始するには、ユーザーがそれをダウンロードして、指定されたチェックポイント フォルダーに配置する必要があります。

データの準備は、SHMT モデルの運用を成功させる鍵となります。研究チームは、「BeautyGAN」が提供するメイクアップ転送データセットをダウンロードし、異なるメイクアップ画像と非メイクアップ画像を統合することを推奨しています。同時に、顔解析と 3D 顔データの準備も重要であり、ユーザーが効果的にデータを準備できるように、関連するツールとデータ パスが研究で詳しく説明されています。

モデルのトレーニングと推論に関して、研究チームはユーザーが自分のニーズに応じてパラメーターを調整できるように、詳細なコマンドライン スクリプトを提供しています。また、チームはデータ構造の重要性を特に強調し、ユーザーがデータを準備する方法をガイドできる明確なディレクトリ構造の例を提供しました。

SHMT モデルの発表は、メイクアップ効果伝達の分野における自己教師あり学習の応用に成功したことを示しており、将来的には美容、化粧品、画像処理などの業界で広く使用される可能性があります。この研究は、テクノロジーの可能性を実証するだけでなく、関連分野での詳細な研究のための強固な基盤を築きます。

プロジェクトの入り口: https://github.com/Snowfallingplum/SHMT

ハイライト:

1. SHMT モデルは潜在拡散モデルを使用してメイクアップ効果の伝達を実現しており、NeurIPS2024 に承認されています。

2. チームは、研究者の応用と改善を促進するために、完全なオープンソース コードと事前トレーニングされたモデルを提供します。

3. データの準備とパラメータの調整は非常に重要であり、この調査では操作プロセスとディレクトリ構造に関する詳細なガイダンスが提供されます。

全体として、SHMT モデルのオープンソース リリースは、メイクアップ効果移行研究のための強力なツールとリソースを提供し、美容、化粧品、画像処理の分野での応用の見通しは楽しみに値します。 この研究の革新性と実用性は、この分野における重要な進歩となり、将来の関連研究のための強固な基盤を築きます。