マイクロソフトの研究チームは、Windows プログラムを自律的に操作できる新しい人工知能テクノロジーであるラージ アクション モデル (LAM) をリリースし、単純な対話や提案から実際のタスクの実行に移行する AI の新たな段階を示しました。従来の言語モデルとは異なり、LAM はテキスト、音声、画像などのさまざまな入力を理解し、それらを詳細な行動計画に変換し、他の AI システムでは対処できない問題を解決するためにリアルタイムの状況に基づいて戦略を調整することもできます。と。この画期的なテクノロジーは、実用的なアプリケーションにおける AI の幅広い可能性を提供し、将来の人工知能アシスタントの開発への道を示します。

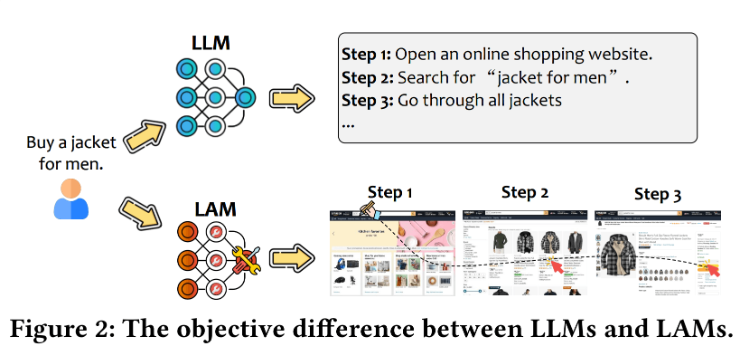

Microsoftの研究チームは最近、「Large Action Model」(LAM)と呼ばれる人工知能技術を発表し、AI開発の新たな段階を迎えた。 GPT-4o などの従来の言語モデルとは異なり、LAM は Windows プログラムを自律的に動作させることができます。つまり、AI は話したり提案したりするだけでなく、実際にタスクを実行することもできます。

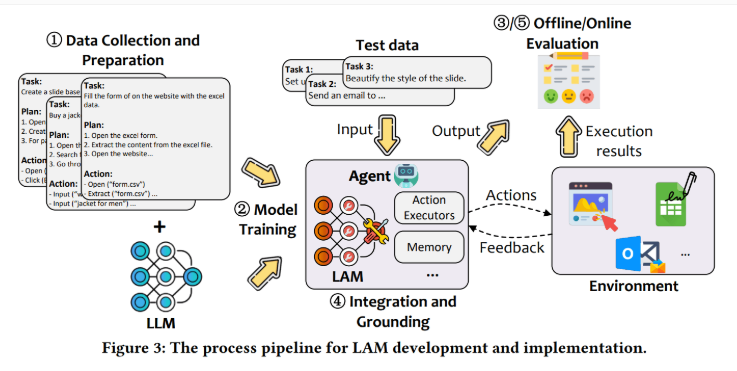

LAM の強みは、テキスト、音声、画像などのさまざまなユーザー入力を理解し、これらのリクエストを詳細な段階的な計画に変換できることです。 LAM は計画を作成するだけでなく、リアルタイムの状況に基づいて行動戦略を適応させます。 LAM を構築するプロセスは、主に 4 つのステップに分かれています。まず、モデルはタスクを論理的なステップに分割することを学習し、次に、より高度な AI システム (GPT-4o など) を通じて、これらの計画を次のステップに変換する方法を学習します。その後、LAM は独自に新しいソリューションを探索し、他の AI システムが対処できない問題も解決し、最終的には報酬メカニズムを通じてトレーニングを微調整します。

実験では、研究チームはMistral-7Bに基づいてLAMモデルを構築し、Wordテスト環境でテストした。結果は、視覚情報なしの GPT-4o の 63% と比較して、モデルは 71% の確率でタスクを正常に完了したことを示しました。

さらに、LAM はタスクの実行速度も優れており、各タスクにかかる時間はわずか 30 秒ですが、GPT-4o は 86 秒かかります。視覚情報を処理する場合の GPT-4o の成功率は 75.5% に増加しますが、全体として、LAM は速度と効果の点で大きな利点があります。

トレーニング データを構築するために、研究チームはまず、Microsoft ドキュメント、wikiHow 記事、Bing 検索からタスクと計画のペアの 29,000 個の例を収集しました。次に、GPT-4o を使用して単純なタスクを複雑なタスクに変換し、それによりデータセットを 150% 増加の 76,000 ペアに拡張しました。最終的に、約 2,000 の成功したアクション シーケンスが最終トレーニング セットに含まれました。

LAM は AI 開発における可能性を実証してきましたが、研究チームは依然として、AI の動作で起こり得るエラーの問題、規制関連の問題、さまざまなアプリケーションでのスケーリングと適応における技術的制限など、いくつかの課題に直面しています。しかし、研究者らは、LAM は AI 開発における重要な変化を表しており、人工知能アシスタントが人間の実践的なタスクの完了をより積極的に支援できるようになる可能性を示していると考えています。

ハイライト:

LAM は Windows プログラムを自律的に実行することができ、会話のみが可能な従来の AI の限界を打ち破ります。

⏱ Word テストでは、LAM がタスクを正常に完了する確率は 71% に達し、GPT-4o の 63% よりも高く、実行速度も高速です。

研究チームはデータ拡張戦略を使用してミッション計画ペアの数を 76,000 ペアに増やし、モデルの訓練効果をさらに向上させました。

LAM の出現は、人工知能が情報提供者から実際のアクションを実行する者への変革を予告し、将来の人間とコンピューターの相互作用と自動化されたオフィスに革命的な変化をもたらします。 LAMは依然として課題はあるものの、大きな可能性を秘めており、さまざまな分野での応用とさらなる発展が期待されています。