生成言語モデルの実際の適用効果は、多くの場合、推論段階のデコード戦略によって制限されます。 RLHF などの既存の手法は主にモデルの勝率に焦点を当てており、デコード戦略がモデルのパフォーマンスに与える影響を無視しているため、効率が低く、出力品質を確保することが困難です。この問題を解決するために、Google DeepMind と Google 研究チームは InfAlign フレームワークを提案しました。これは、推論戦略とモデル調整プロセスを組み合わせて、モデルの推論パフォーマンスと信頼性を向上させることを目的としています。

生成言語モデルは、トレーニングから実用化に至るまでの過程で多くの課題に直面します。主な問題の 1 つは、推論段階で最適なモデルのパフォーマンスを実現する方法です。

ヒューマン フィードバックによる強化学習 (RLHF) などの現在の対策は、主にモデルの勝率を向上させることに焦点を当てていますが、Best-of-N サンプリングや制御されたデコードなどの推論中のデコード戦略が無視されることがよくあります。トレーニングの目標と実際の使用状況との間にこのギャップがあると、非効率が生じ、出力の品質と信頼性に影響を与える可能性があります。

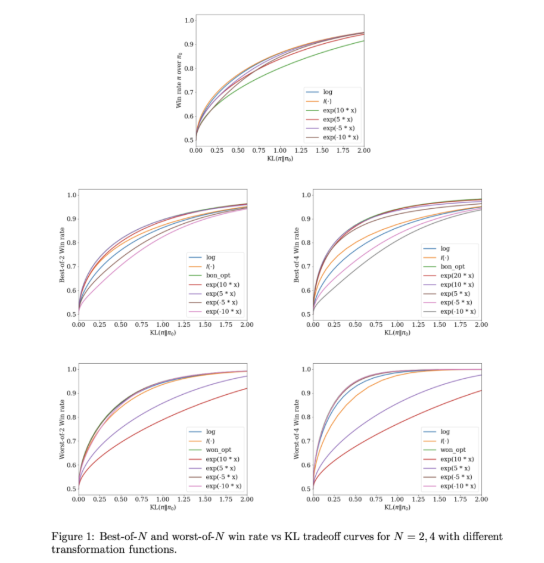

これらの問題に対処するために、Google DeepMind と Google Research チームは、推論戦略と組み合わせるように設計された機械学習フレームワークである InfAlign を開発しました。 InfAlign は、推論時のメソッドをアライメント プロセスに組み込み、トレーニングとアプリケーションの間のギャップを埋めるよう努めます。調整された強化学習手法を採用し、特定の推論戦略に基づいて報酬関数を調整します。 InfAlign は、Best-of-N サンプリング (複数の応答を生成し、最適なものを選択する) や Worst-of-N (安全性評価で一般的に使用される) などの手法で特に効果的であり、調整されたモデルが制御された環境と実際の環境の両方で機能することを保証します。 -人生のシナリオは良いです。

InfAlign の中核は、校正および変換強化学習 (CTRL) アルゴリズムであり、報酬スコアの校正、推論戦略に従ってこれらのスコアの変換、KL 正則化最適化問題の解決という 3 つのステップに従います。 InfAlign は、報酬変換を特定のシナリオに合わせて調整することで、トレーニング目標を推論要件に合わせます。この方法により、推論時の勝率が向上するだけでなく、計算効率も維持されます。さらに、InfAlign はモデルの堅牢性を強化し、さまざまなデコード戦略に効果的に対処し、一貫した高品質の出力を生成できるようにします。

InfAlign の有効性は、Anthropic の有用性と無害性のデータセットを使用した実験で検証されています。既存の手法と比較して、InfAlign は推論勝率を Best-of-N サンプリングで 8% ~ 12%、Worst-of-N セキュリティ評価で 4% ~ 9% 向上させます。これらの改善は、報酬モデルの誤った調整の問題を効果的に解決し、さまざまな推論シナリオで一貫したパフォーマンスを保証する、調整された報酬変換によるものです。

InfAlign は、生成言語モデルの調整における重要な進歩を表します。 InfAlign は、推論を意識した戦略を組み込むことで、トレーニングとデプロイメントの間の重要な違いに対処します。その強固な理論的基盤と実証結果は、AI システムの調整を包括的に改善する可能性を強調しています。

リンク: https://arxiv.org/abs/2412.19792

ハイライト:

InfAlign は、Google DeepMind によって開発された新しいフレームワークで、推論段階での言語モデルのパフォーマンスを向上させることを目的としています。

このフレームワークは、調整された強化学習手法を通じて推論戦略の報酬関数を調整し、トレーニング目標と推論要件の間の調整を実現します。

実験結果は、InfAlign が複数のタスクにおけるモデルの推論勝率を大幅に向上させ、優れた適応性と信頼性を実証したことを示しています。

InfAlign フレームワークの出現は、推論フェーズにおける生成言語モデルの効率と品質の問題を解決するための新しいアイデアを提供し、モデルの堅牢性と信頼性の向上に貢献することは注目に値します。今後の研究では、生成 AI テクノロジーの継続的な開発を促進するために、さまざまなモデルやタスクに対する InfAlign の適用をさらに検討することができます。