医療 AI の評価に関する論文で、複数の上位大規模言語モデルのパラメータ サイズが予期せず公開され、業界に大きな懸念を引き起こしました。 Microsoft が発表したこの論文は、MEDEC 医療分野のベンチマーク テストを中心に、OpenAI の GPT-4 シリーズや Anthropic の Claude 3.5 Sonnet などのモデルを含む、OpenAI、Anthropic およびその他の企業のモデル パラメータを推定しています。論文に記載されているパラメータスケールと公開情報には差異があります。たとえば、GPT-4 のパラメータスケールは、NVIDIA が以前に発表したデータとは大きく異なります。これは、モデルのアーキテクチャと技術について業界で激しい議論を引き起こしました。 AI モデルに対する人々の懸念を再び引き起こしました。

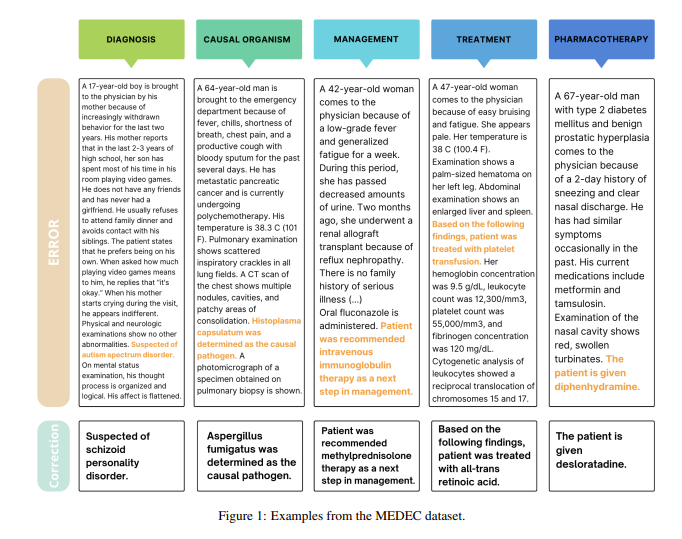

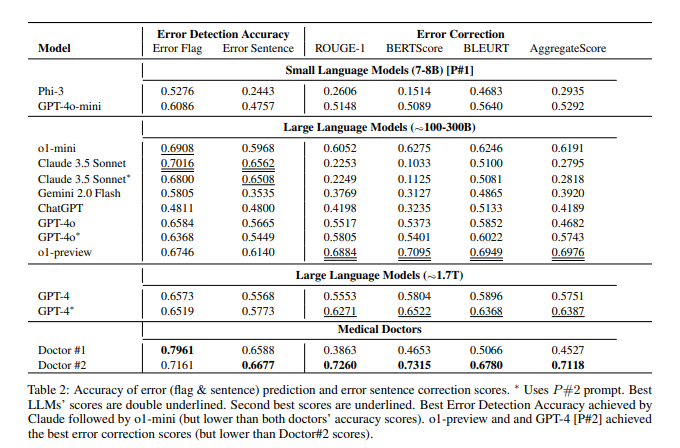

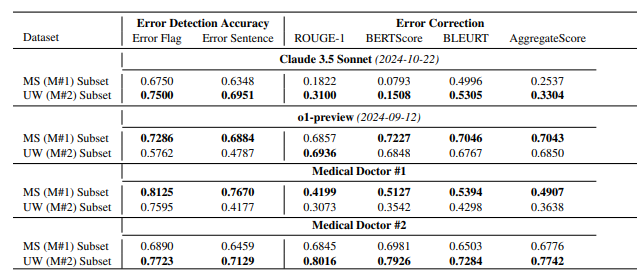

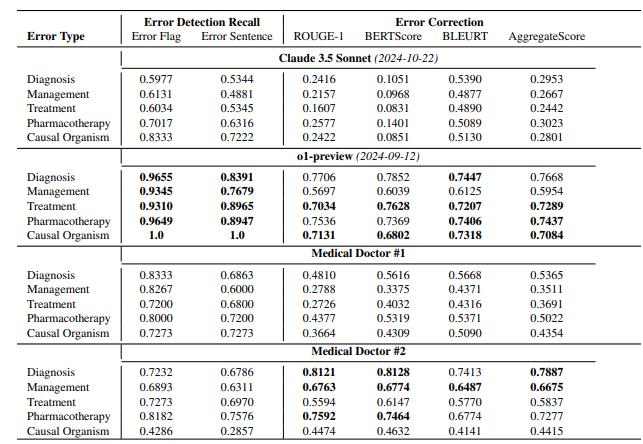

論文によると、OpenAI の o1-preview モデルには約 300B のパラメータがあり、GPT-4o には約 200B、GPT-4o-mini には 8B しかありません。Claude3.5Sonnet のパラメータ サイズは約 175B です。 MEDEC テストの結果は、Claude3.5Sonnet がエラー検出で優れたパフォーマンスを示し、スコアが 70.16 と高いことを示しています。 Google Gemini のパラメータについては論文では言及されていません。これは、Gemini が NVIDIA GPU の代わりに TPU を使用しているため、トークンの生成速度を正確に推定することが困難であるためと考えられます。 論文内で「流出した」パラメータ情報とモデル性能の評価結果は、業界が大型モデルの技術路線、ビジネス競争、将来の開発方向について深く考える上で貴重な参考資料となる。

Microsoftがモデルパラメータ情報を論文に「漏洩」したのはこれが初めてではない。昨年 10 月、Microsoft は GPT-3.5-Turbo のパラメータ サイズ 20B を論文で明らかにしましたが、その後、更新バージョンでこの情報を削除しました。このたび重なる「流出」に、業界関係者の間では「何か特別な意図があるのではないか」との憶測が飛び交っている。

このペーパーの主な目的は、MEDEC と呼ばれる医療分野のベンチマークを紹介することであることに注意してください。研究チームは、米国の 3 つの病院からの 488 件の臨床ノートを分析し、主要なモデルが医療文書の誤りを特定して修正する能力を評価しました。テスト結果は、Claude3.5Sonnet が 70.16 のスコアでエラー検出において他のモデルをリードしていることを示しています。

業界では、これらのデータの信頼性について激しい議論が行われてきました。 Claude3.5Sonnet がより少ないパラメータで優れたパフォーマンスを達成できれば、Anthropic の技術力が浮き彫りになると考える人もいます。一部のアナリストは、モデル価格の推論を通じて一部のパラメーターの推定値が合理的であると信じています。

特に注目すべき点は、この論文では主流モデルのパラメータのみが推定されており、Google Gemini の具体的なパラメータについては言及されていないことです。一部のアナリストは、これは Gemini が NVIDIA GPU ではなく TPU を使用していることに関連している可能性があり、トークンの生成速度を正確に見積もることが困難であると考えています。

OpenAI がオープンソースへの取り組みを徐々に薄めていくにつれ、モデルパラメータなどの核となる情報が引き続き業界で注目を集め続ける可能性があります。この予期せぬ漏洩は、人々が AI モデルのアーキテクチャ、技術的ルート、ビジネス競争について深く考えるきっかけとなりました。

参考文献:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probively_around_8b_active/

全体として、この論文で「漏洩した」モデルパラメータ情報は論文の研究の主な内容ではありませんが、大規模なモデルパラメータの規模、技術的ルートの選択、および技術的ルートの選択に関して業界での深い議論を引き起こしました。商業競争の状況を分析し、人工知能分野の将来の発展の基礎を提供します。新しい思考の方向性を提供します。