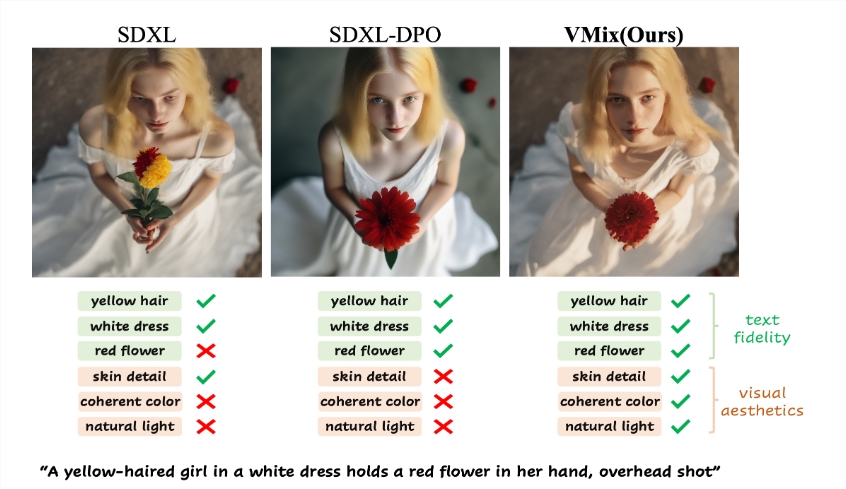

この記事では、テキストから画像への生成の品質と美的効果の向上を目的として、ByteDance と中国科学技術大学の研究チームが提案した新しい拡散モデル アダプター VMix を紹介します。 VMix は、賢い条件付き制御手法を使用して、モデルを再トレーニングすることなく、既存の拡散モデルの美的パフォーマンスを強化し、画像とテキストの説明の間の一貫性を維持します。テキストの手がかりをコンテンツと美的な説明に分解し、ハイブリッドクロスアテンションメカニズムを通じて画像生成プロセスに美的情報を統合して、画像の美的感覚をきめ細かく制御します。このアダプターはさまざまなコミュニティ モデルと互換性があり、幅広い用途が期待できます。

テキストからの画像生成の分野では、拡散モデルは並外れた能力を実証していますが、美的な画像生成にはまだいくつかの欠点があります。最近、ByteDance と中国科学技術大学の研究チームは、生成された画像の品質を向上させ、さまざまな視覚に対する感度を維持することを目的とした、「Cross-Attendant Value Mixing Control」(VMix) アダプターと呼ばれる新技術を提案しました。コンセプトの多様性。

VMix アダプターの中心となるアイデアは、画像とテキスト間の位置合わせを確保しながら、優れた条件付き制御方法を設計することで、既存の拡散モデルの美的パフォーマンスを向上させることです。

このアダプターは主に 2 つのステップを通じて目的を達成します。1 つ目は、美的埋め込みを初期化することで、入力テキスト キューをコンテンツの説明と美的説明に分解します。2 つ目は、ノイズ除去プロセス中に、クロスアテンションを混合して美的条件を組み込んで、美的表現を強化します。画像の美的効果を高め、画像とプロンプトワードの間の一貫性を維持します。 。このアプローチの柔軟性により、VMix を再トレーニングせずに複数のコミュニティ モデルに適用できるため、視覚的なパフォーマンスが向上します。

研究者らは一連の実験を通じて VMix の有効性を検証し、その結果、この方法が美的な画像生成において他の最先端の方法よりも優れていることが示されました。同時に、VMix はさまざまなコミュニティ モジュール (LoRA、ControlNet、IPAdapter など) とも互換性があり、その適用範囲がさらに広がります。

VMix の美学に対するきめ細かい制御は、美的埋め込みを調整する機能に反映されており、単一次元の美的ラベルを通じて画像の特定の寸法を改善したり、完全な正面の美的ラベルを通じて全体的な画像品質を向上させることができます。実験では、「窓にもたれる女の子、風が吹く、夏のポートレート、ミドル丈のミドル丈のショット」などのテキスト説明をユーザーに与えると、VMix アダプターは生成される画像の美しさを大幅に向上させることができました。

VMix アダプターは、テキストから画像への生成の美的品質を向上させるための新たな方向性を切り開き、将来的にはより幅広いアプリケーションでその可能性が実現されることが期待されています。

プロジェクトの入り口: https://vmix-diffusion.github.io/VMix/

ハイライト:

VMix アダプターは、美的埋め込みを通じてテキスト プロンプトをコンテンツと美的説明に分解し、画像生成の品質を向上させます。

このアダプターは複数のコミュニティ モデルと互換性があるため、ユーザーは再トレーニングせずに画像の視覚効果を向上させることができます。

実験結果は、VMix が美的生成において既存のテクノロジーを上回り、幅広い応用の可能性を秘めていることを示しています。

全体として、VMix アダプターは、AI 画像生成の芸術性と美しさを向上させるための効果的なソリューションを提供し、互換性と使いやすさの点でも優れたパフォーマンスを発揮し、将来の画像生成テクノロジーの開発に新たな方向性と可能性をもたらします。