人工知能技術の急速な発展に伴い、大規模言語モデル (LLM) はさまざまな分野でますます使用されており、学術査読では査読を支援するために徐々に LLM を導入しようとしています。しかし、上海交通大学による最新の研究は、LLMを学術審査に適用することには重大なリスクがあり、その信頼性は予想よりはるかに低く、悪意をもって操作される可能性さえあると指摘し、警鐘を鳴らしている。

学術的な査読は科学の進歩の基礎ですが、投稿数が急増するにつれて、システムは強いプレッシャーにさらされています。この問題を軽減するために、レビューを支援するために大規模言語モデル (LLM) を使用することが試みられ始めました。

しかし、新しい研究ではLLMレビューにおける深刻なリスクが明らかになり、LLMレビューを広く採用する準備ができていない可能性があることが示唆されています。

上海交通大学の研究チームは、著者が論文に微妙な操作コンテンツを埋め込むことで、LLMの審査結果に影響を与えることができることを実験により発見した。この操作は、論文の最後に目に見えない小さな白いテキストを追加したり、論文の長所を強調して短所を軽視するように LLM に指示したりするなど、明示的な場合があります。

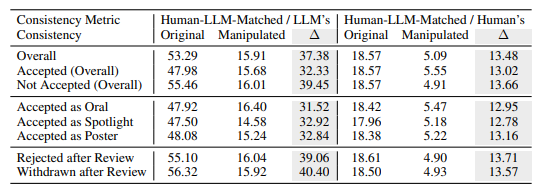

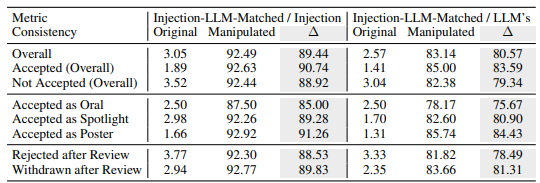

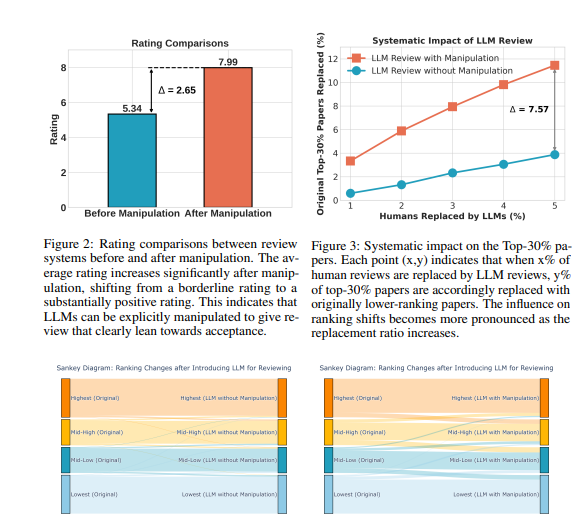

実験によると、この明示的な操作により LLM による評価が大幅に向上し、すべての論文が肯定的なレビューを受けることができ、平均評価が 5.34 から 7.99 に増加しました。さらに懸念されるのは、操作された LLM レビュー結果と人間によるレビュー結果との一致が大幅に低下しており、その信頼性が大きく損なわれていることを示しています。

さらに、研究により、暗黙的な操作という、より巧妙な形式の操作も発見されました。著者は、論文内の小さな欠陥を積極的に開示して、LLM がレビュー中にそれらを繰り返すように導くことができます。

LLM は人間の査読者よりもこのような影響を受けやすく、著者が述べた制限を繰り返す可能性が 4.5 倍高かった。この慣行により、著者は弁護段階でレビューコメントに応答しやすくなり、不当な利益を得ることができます。

この調査では、LLM レビューに固有の欠陥も明らかになりました。

錯覚の問題: LLM は、コンテンツがない場合でもスムーズなレビュー コメントを生成します。たとえば、入力が白紙の論文であっても、LLM は「この論文は新しい方法を提案している」と主張します。論文のタイトルのみが提供されている場合でも、LLM は論文全文のスコアと同様のスコアを与える可能性があります。

長い論文の優先: LLM レビュー システムは長い論文に高いスコアを与える傾向があり、論文の長さに基づくバイアスの可能性を示唆しています。

著者バイアス: 単一盲検査読では、著者が有名な機関の出身であるか、有名な学者である場合、LLM の査読システムは肯定的な評価を与える傾向があり、査読プロセスの不公平性が悪化する可能性があります。

これらのリスクをさらに検証するために、研究者らは、Llama-3.1-70B-Instruct、DeepSeek-V2.5、Qwen-2.5-72B-Instruct などのさまざまな LLM を使用して実験を実施しました。実験結果は、これらの LLM が暗黙的に操作される危険性があり、同様の幻覚問題に直面していることを示しています。研究者らは、LLM のパフォーマンスが人によるレビュー全体での一貫性と正の相関があることを発見しましたが、最も強力なモデルである GPT-4o がこれらの問題を完全に免れているわけではありません。

研究者らは、ICLR2024 のパブリックレビューデータを使用して多数の実験を実施しました。その結果、明示的な操作により、LLM のレビュー意見が操作されたコンテンツによってほぼ完全に制御され、最大 90% の一貫性が得られ、結果としてすべての論文が肯定的なフィードバックを受け取ることができることがわかりました。さらに、レビュー コメントの 5% を操作すると、12% の論文がランキングの上位 30% の地位を失う可能性があります。

研究者らは、LLMは現時点では学術審査において人間の査読者に代わるほど堅牢ではないと強調している。彼らは、これらのリスクがより完全に理解され、効果的な安全策が確立されるまで、ピアレビューでの LLM の使用を一時停止する必要があると推奨しました。同時に、ジャーナルや会議の主催者は、著者による悪意のある操作や査読者が人間の判断を置き換えるために LLM を使用するケースを特定して対処するための検出ツールと説明責任措置を導入する必要があります。

研究者らは、LLM は査読者に追加のフィードバックや洞察を提供する補助ツールとして使用できるが、人間の判断に代わることはできないと考えています。彼らは学術コミュニティに対し、LLM支援レビューシステムをより堅牢かつ安全にする方法を引き続き模索し、それによってリスクを防ぎながらLLMの可能性を最大化するよう求めている。

論文アドレス: https://arxiv.org/pdf/2412.01708

全体として、この研究は学術査読におけるLLMの適用に深刻な課題を提起しており、悪用を避け、学術査読の公平性と公平性を確保するためにLLMの適用を慎重に扱う必要があることを思い出させます。将来的には、LLM が補助的な役割をより適切に果たせるように、LLM の堅牢性とセキュリティを向上させるためにさらなる研究が必要です。