ビデオデータ量の爆発的な増加に伴い、ビデオ情報を知識検索や質問応答に効果的に使用する方法が研究のホットスポットになっています。従来の検索拡張生成 (RAG) システムは主にテキスト情報に依存しており、ビデオに含まれる豊富なマルチモーダル情報を十分に活用することが困難です。この記事では、クエリに関連するビデオを動的に取得し、視覚情報とテキスト情報を効果的に統合して、より正確で有益な回答を生成できる、VideoRAG と呼ばれる新しいフレームワークを紹介します。このフレームワークは、ラージ ビデオ言語モデル (LVLM) を利用して、マルチモーダル データのシームレスな統合を実現し、自動音声認識テクノロジを通じて字幕なしビデオを処理し、検索と生成の効率を大幅に向上させます。

ビデオ技術の急速な発展に伴い、ビデオは情報の検索と複雑な概念の理解のための重要なツールとなっています。ビデオは、視覚的データ、時間的データ、およびコンテキスト データを組み合わせて、静止画像やテキストを超えたマルチモーダルな表現を提供します。今日、ビデオ共有プラットフォームの急増と、教育および情報ビデオの急増により、ビデオを知識源として活用することで、詳細なコンテキスト、空間理解、プロセスのデモンストレーションを必要とするクエリを解決する前例のない機会が得られます。

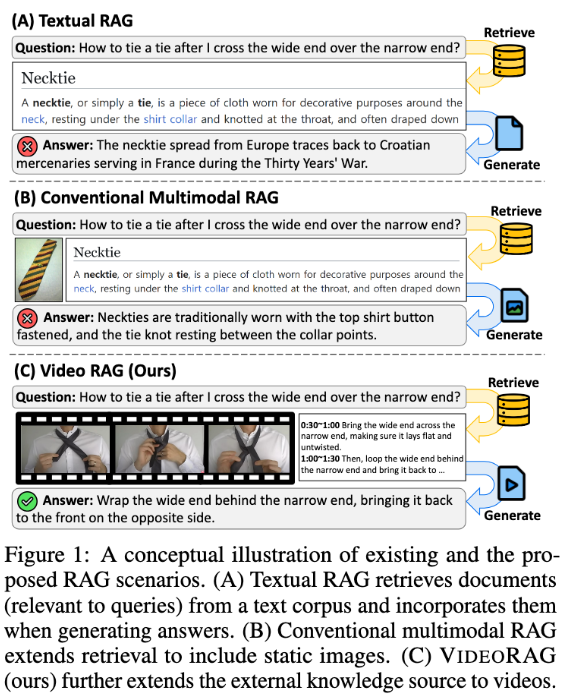

しかし、既存の検索拡張生成 (RAG) システムでは、ビデオ データの可能性を最大限に活用できないことがよくあります。これらのシステムはテキスト情報に依存することが多く、クエリ応答をサポートするために静止画像を使用することもありますが、複雑なタスクに不可欠なビデオに含まれる視覚的なダイナミクスやマルチモーダルな手がかりを捉えることができません。従来のアプローチでは、検索せずにクエリ関連のビデオを事前に定義するか、ビデオをテキスト形式に変換するため、重要な視覚的コンテキストと時間的ダイナミクスが失われ、正確で有益な回答を提供する能力が制限されます。

これらの問題を解決するために、韓国科学技術院 (KaIST) と DeepAuto.ai の研究チームは、新しいフレームワーク VideoRAG を提案しました。このフレームワークは、クエリに関連するビデオを動的に取得し、視覚情報とテキスト情報を生成プロセスに統合することができます。 VideoRAG は、高度な大規模ビデオ言語モデル (LVLM) を活用して、マルチモーダル データのシームレスな統合を実現し、取得されたビデオがユーザー クエリとコンテキストの一貫性を確保し、ビデオ コンテンツの時間的な豊かさを維持します。

VideoRAG のワークフローは、取得と生成の 2 つの主要な段階に分かれています。取得フェーズ中に、フレームワークはクエリを通じて視覚的およびテキスト的特徴に類似したビデオを識別します。

生成段階では、自動音声認識技術を使用して字幕なしのビデオの補助テキストデータを生成することで、すべてのビデオに対する応答生成が効果的に情報を提供できるようにします。取得された関連ビデオはさらに生成モジュールに入力され、ビデオ フレーム、字幕、クエリ テキストなどのマルチモーダル データが統合され、LVLM を使用してそれらのデータが処理されて、長く、豊富で、正確で、文脈に応じて適切な応答が生成されます。

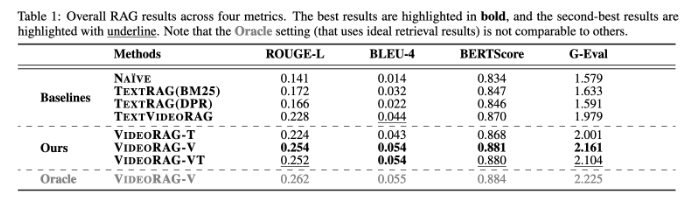

VideoRAG は WikiHowQA や HowTo100M などのデータセットに対して広範な実験を実施しており、その結果、応答品質が従来の方法よりも大幅に優れていることが示されています。この新しいフレームワークは、検索拡張生成システムの機能を向上させるだけでなく、将来のマルチモーダル検索システムの新しい標準を設定します。

論文: https://arxiv.org/abs/2501.05874

ハイライト:

**新しいフレームワーク**: VideoRAG は関連ビデオを動的に取得し、視覚情報とテキスト情報を融合して生成効果を向上させます。

**実験検証**: 複数のデータセットでテストされ、従来の RAG 手法よりも応答品質が大幅に優れていることがわかりました。

**技術革新**: 大規模なビデオ言語モデルを使用して、VideoRAG はマルチモーダル データ統合の新しい章を開きます。

全体として、VideoRAG フレームワークは、ビデオベースの検索強化タスクのための新しいソリューションを提供します。マルチモーダルなデータ統合と情報検索における画期的な進歩により、将来のよりスマートで正確な情報検索システムに重要な情報が提供されます。 研究成果は教育や医療などの分野で広く活用されることが期待されます。