近年、特にモバイルデバイスやパーソナルコンピューターなどのプラットフォームでは、軽量AIモデルの需要が高まっています。パフォーマンスを確保しながらモデルのサイズと計算コストを削減する方法が重要な研究方向になりました。この記事では、最近リリースされたSmolvlmは、速度と効率の観点から重要なブレークスルーを設計した2Bパラメーターの視覚言語モデルです。

近年、視覚および言語タスクにおける機械学習モデルのアプリケーションのニーズは増加していますが、ほとんどのモデルには巨大なコンピューティングリソースが必要であり、個人機器で効率的に動作することはできません。特に、ラップトップ、消費者GPU、モバイルデバイスなどの小さなデバイスは、視覚的な言語タスクを処理する際に大きな課題に直面しています。

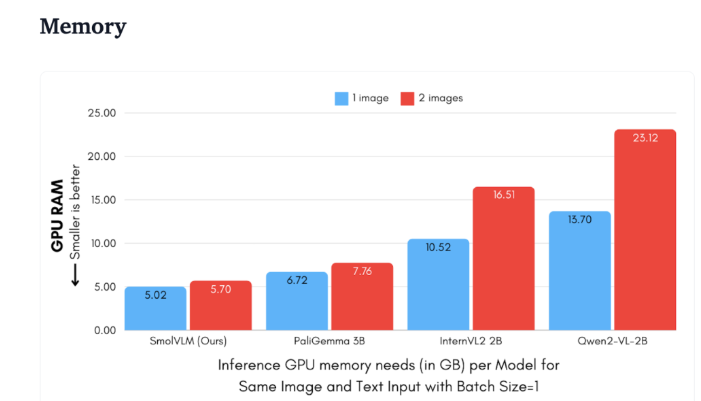

QWEN2-VLを例にとると、そのパフォーマンスは優れていますが、ハードウェアの要件は高く、リアルタイムアプリケーションでの可用性が制限されます。したがって、より低いリソースで動作する軽量モデルの開発が重要な需要になりました。

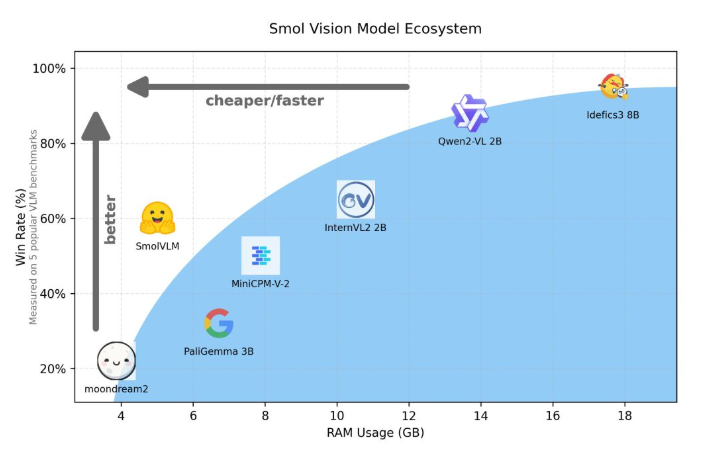

Hugging Faceは最近、Smolvlmをリリースしました。これは、機器のサイド推論用に設計された2Bパラメータービジュアル言語モデルです。 GPUメモリとトークンの生成速度でのSmolvlmのパフォーマンスは、他の同様のモデルを上回ります。その主な特徴は、パフォーマンスを犠牲にすることなく、ラップトップや消費者GPUなどの小さなデバイスで効果的に動作できることです。 Smolvlmは、パフォーマンスと効率性の理想的なバランスを見つけ、同じモデルを過去に克服するのが難しいという問題を解決しています。

QWEN2-VL2Bと比較して、SmolVLMは最適化されたアーキテクチャのおかげで7.5〜16倍高速で生成され、軽量の推論が可能になります。この効率は、エンドユーザーに実際的な利益をもたらすだけでなく、エクスペリエンスを大幅に改善します。

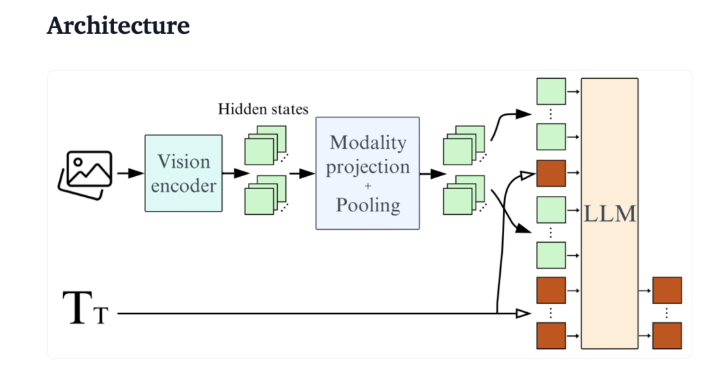

技術的な観点から見ると、Smolvlmには最適化されたアーキテクチャがあり、高効率デバイスの側面推論をサポートしています。ユーザーはGoogle Colabで微調整することもできます。これにより、テストと開発のしきい値が大幅に減少します。

記憶の職業が小さいため、Smolvlmは以前に同様のモデルによって運ばれていなかったデバイスでスムーズに実行できます。 50フレームのYouTubeビデオをテストすると、Smolvlmは27.14%のスコアでうまく機能し、2つのリソースよりも2つのリソース消費モデルよりも優れており、その強力な適応性と柔軟性を示しています。

Smolvlmには、視覚言語モデルの分野で重要なマイルストーンがあります。その発売により、複雑な視覚言語タスクが毎日の機器で実行され、現在のAIツールの重要なギャップが埋められます。

Smolvlmは、優れた速度と効率を実行するだけでなく、ハードウェアコストを高く投資せずに視覚的な言語処理のための強力なツールを開発者と研究者に提供します。 AIテクノロジーの継続的な普及により、Smolvlmなどのモデルにより、強力な機械学習能力がより触手になります。

デモ:https://huggingface.co/spaces/huggingfacetb/smolvlm

https://huggingface.co/spaces/huggingfacetb/smolvlm

ポイント:

Smolvlmは、Faceの抱きしめによって起動するデバイス側の推論用に設計された2Bパラメーターの視覚言語モデルです。

そのトークン生成速度は、同様のモデルの7.5〜16倍であり、ユーザーエクスペリエンスとアプリケーションの効率を大幅に向上させます。

テストでは、Smolvlmは強力な適応性を示しましたが、ビデオデータトレーニングなしではまだ良いスコアを得ることができます。

Smolvlmの出現は、視覚的な言語モデルの軽量開発における重要なブレークスルーをマークします。将来、Smolvlmのような効率的で軽量モデルは、より多くのシナリオで役割を果たし、より広く使用されている人工知能技術を促進します。