Alibaba International AIがリリースした最新のMarco-O1推論モデルは、オープンな問題を解決する上で重大な可能性を示しています。それは、標準的な回答の分野に限定された従来のモデルの制限を突破し、定量化が困難で明確な報酬の欠如の分野でアプリケーションを探索することに取り組んでいます。このモデルのコア機能は、スペース拡張戦略を調整するための独自のトレーニング方法であり、長くて難しい翻訳など、より複雑で困難なタスクを処理し、正確な答えを示すことができます。 Marco-O1のオープンソースは、AI研究コミュニティに貴重なリソースも提供します。

Alibaba Internationalチームは最近、Marco-O1と呼ばれる新しいタイプの推論モデルをリリースしました。研究チームは、そのようなモデルを定量化するのが難しく、明確な報酬の欠如を効果的に促進できるかどうかを調査することに取り組んでいます。

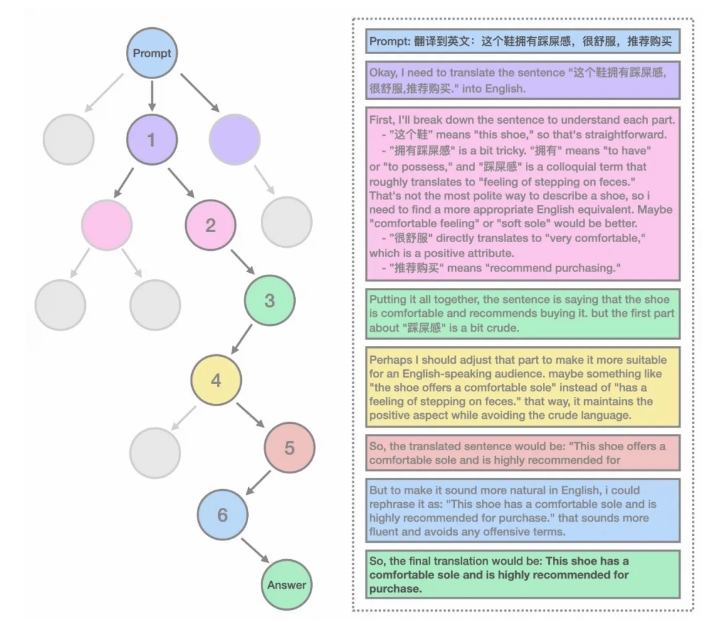

MARCO-O1モデルの特性には、MCTを使用してスペースを拡張するために、微調整のための超長COTデータの使用、および微調整された空間拡張が含まれます。このモデルは、自己プレイ+MCTを通じて反射および修正機能を備えた多くの超長COTデータを構築し、他のオープンソースデータと組み合わせてトレーニングされています。さらに、研究チームは、モデルのソリューション空間をさらに拡張し、モデル出力をより良い回答を出力するように導くミニステップも定義しています。

翻訳ミッションでは、Marco-O1モデルは、難易度の翻訳を処理する能力を示しました。研究チームは現在、いくつかのCOTデータと現在の最高のモデルのオープンソースであり、将来、より多くのデータとモデルをオープンする予定です。

モデルは、たとえば、「ストロベリー」の「R」の数がある場合、推論中に詳細な応答で考えます。機械翻訳の分野では、モデルは推論リンクを通じて困難を正しく識別し、全体的な翻訳の精度を向上させるために言葉で翻訳します。

また、研究チームは他の分野で、モデルが他の一般的な現実の問題を解決する能力があることを証明するために試みました。 MARCO-O1の全体的な構造は、自己プレイ+MCTを通じて反射および補正機能を備えた多くの超長COTデータを構築し、他のオープンソースデータで訓練されています。研究チームはまた、マルコポロファミリーからいくつかの指示を組み込み、データセットに従ってモデルの指示を強化して能力に従うようにしました。

使用法の観点から、研究チームは推論コードと微調整コードを提供し、モデルと単語の除数を簡単にロードし、チャットまたは微調整モデルを開始できます。さらに、このモデルは、ModelScopeのGGUFバージョンでも直接実行でき、より速いエクスペリエンスを提供します。

Marco-O1モデルのリリースは、推論モデルの分野におけるAlibaba International AIチームの重要なステップであり、オープンな問題を解決するための新しいアイデアとツールを提供します。

ModelScope:

https://modelscope.cn/models/aidc- ai/marco-e1

arxiv:

https://arxiv.org/abs/2411.14405

Github:

https://github.com/aidc- ai/marco-e1

顔を抱き締める:

https://huggingface.co/aidc-jarco- o1

全体として、MARCO-O1モデルのオープンソースは、AIの研究と応用に新しい可能性をもたらし、オープンな問題のブレークスルーは楽しみにしています。 関連するリンクは、ユーザーがこのモデルをさらに理解して使用するのに便利です。