メタAIは最近、スピリットLMと呼ばれるマルチモード言語モデルを開きました。音声モーダル状態スピリットLMは、テキストと音声を理解して生成することができますが、さらに重要なことに、音声認識、音声統合、音声分類などのさまざまな機能を実現することができます。 「基本バージョン」と「式バージョン」のバージョン。

Meta AIは最近、Spirit LMと呼ばれる基本的なマルチモーダル言語モデルをオープンしました。

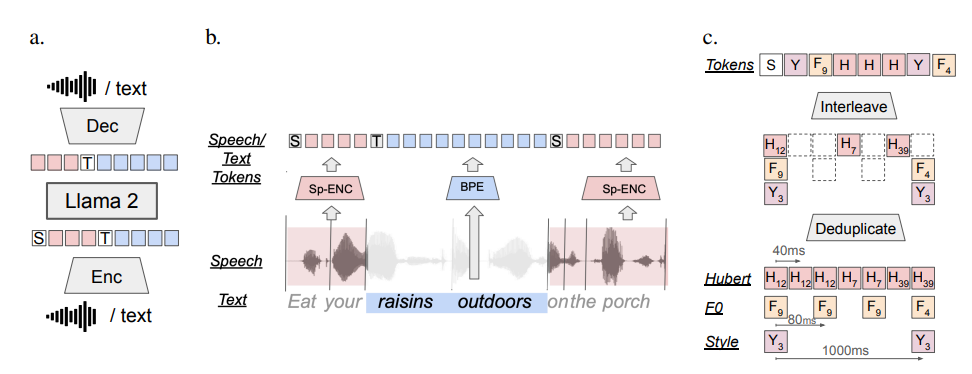

スピリットLMは、テキストと音声ユニットに関する継続的なトレーニングにより、70億パラメーターのトレーニング前のテキスト言語モデルに基づいています。テキストを大規模なテキストモデルのように理解し、生成することもでき、音声を理解して生成することもできます。それをとると、声をテキストに変換します。

さらに強力なのは、スピリットLMが「感情的な表現」に特に優れていることです。 スピリットLMによって生成された声は、もはや冷たいマシンの音ではなく、喜びと悲しみに満ちた本物の人のようなものであると想像できます!

AIをより良い「大声で」するために、Metaの研究者はSpirit LMの2つのバージョンも開発しました。

「Basic Edition」:このバージョンは、主に音声の「基本的な構成」、つまり音声の「基本的な構成」に焦点を当てています。

「表現力豊か」:音声情報に加えて、このバージョンはトーンとスタイル情報も追加し、AIの声をより鮮明で表現力豊かにすることができます。

それで、スピリットLMはこれをどのように行いますか?

簡単に言えば、Spirit LMは、Metaが以前にリリースした超強力テキストモデルに基づいてLlama2によって訓練されています。 研究者は、大量のテキストと音声データをLLAMA2に「供給」し、特別な「stogghtなトレーニング」方法を使用して、LLAMA2がテキストと音声の法則を同時に学習できるようにしました。

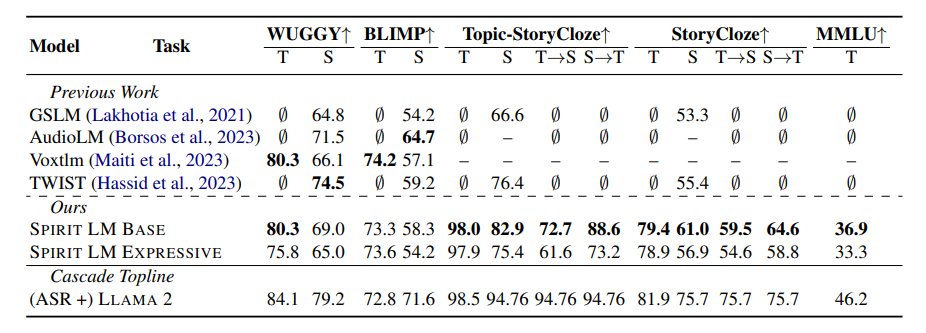

Spirit LMの「感情的表現」能力をテストするために、Metaの研究者は、新しいテストベンチマーク「Voice-Text Emotional Reservation Benchmark」(STSP)を具体的に設計しました。 このテストベンチマークには、AIモデルが対応する感情的な音声とテキストを正確に識別して生成できるかどうかをテストするために、さまざまな感情を表現するさまざまな音声およびテキストプロンプトが含まれています。 結果は、スピリットLMの「表現バージョン」が感情的な保持の観点からうまく機能したことを示しています。

もちろん、Metaの研究者は、Spirit LMにはまだ改善すべき場所がたくさんあることを認めました。 たとえば、Spirit LMは現在英語のみをサポートしており、将来的には他の言語に拡張する必要があります。モデルのパフォーマンスを改善します。

スピリットLMは、AI分野のメタの大きなブレークスルーです。 近い将来、スピリットLMの開発に基づいたより興味深いアプリケーションが見られるので、AIは実際の人々のような感情を表現し、より自然でより友好的な交流を私たちとコミュニケーションできると言うだけではないと思います!

プロジェクトアドレス:https://speechbot.github.io/spiritlm/

論文アドレス:https://arxiv.org/pdf/2402.057555

全体として、スピリットLMのオープンソースは、マルチモードAIの開発のための新しい機会をもたらします。 将来、より多くの言語とアプリケーションのシナリオでのSpirit LMの実装を楽しみにしています。